web

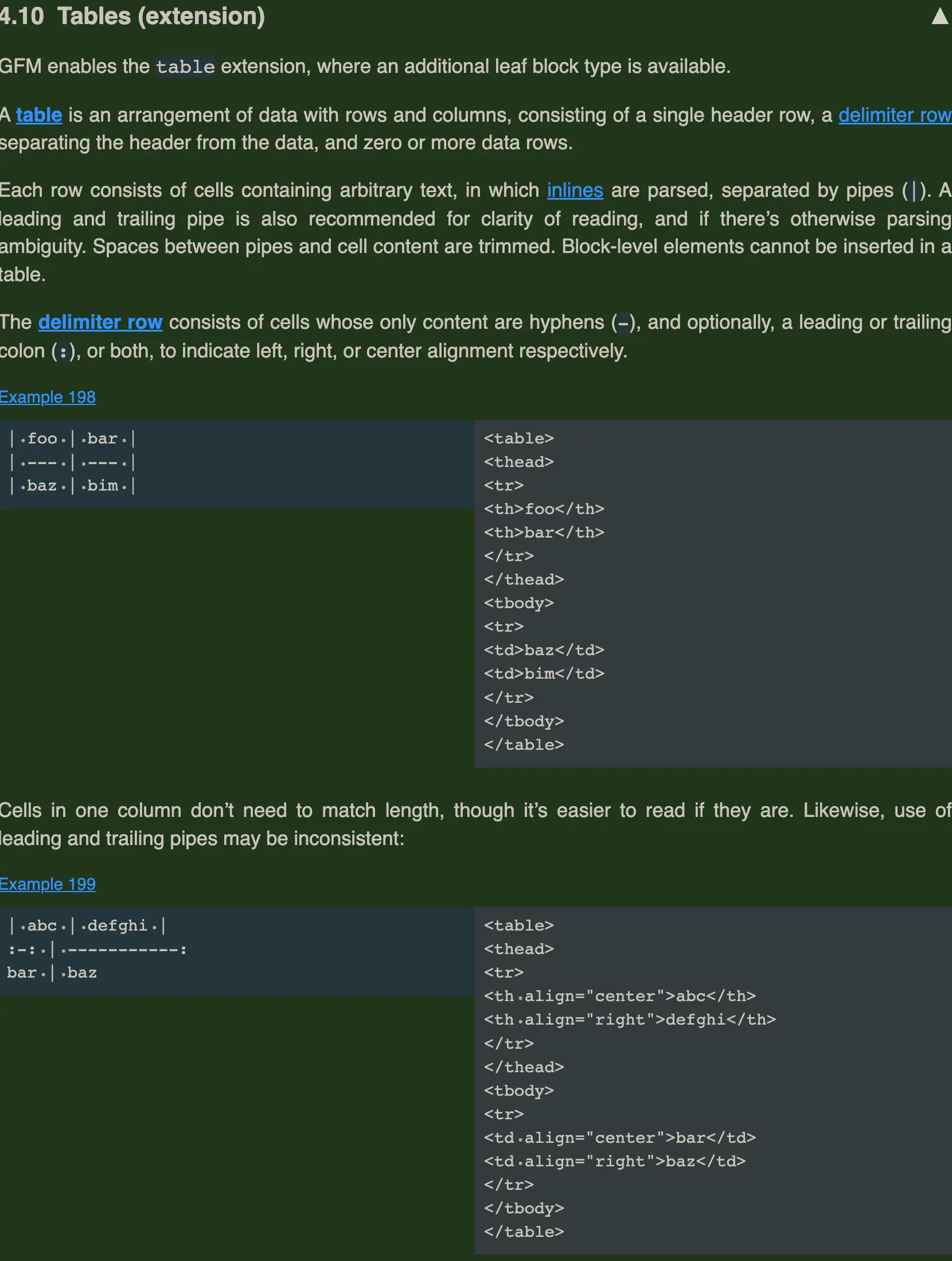

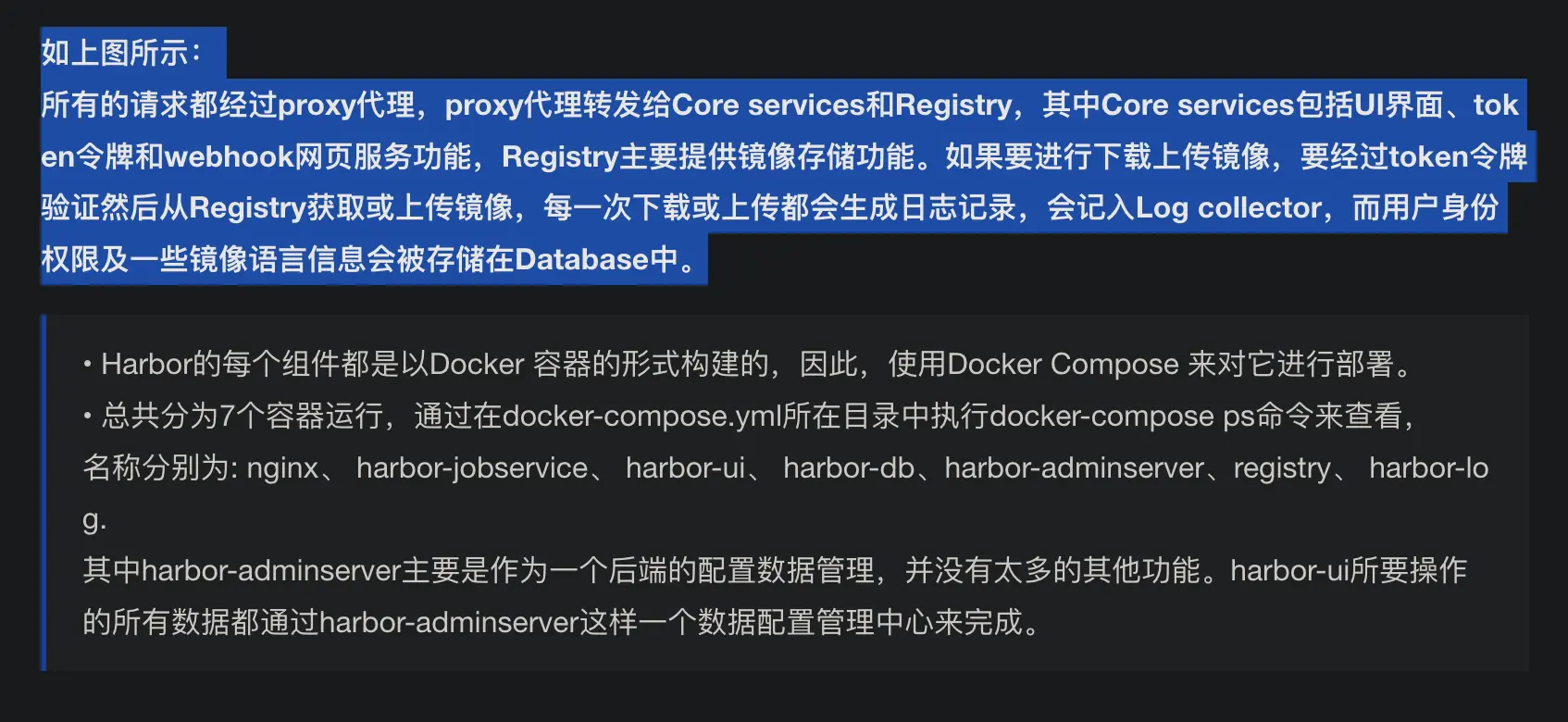

HTTP协议

flowchart LR

v1(HTTP1.1-1999年) --分帧复用--> v2(HTTP2-2015年)

v2 --tcp转向udp-->v3(HTTP3-2021年)

-

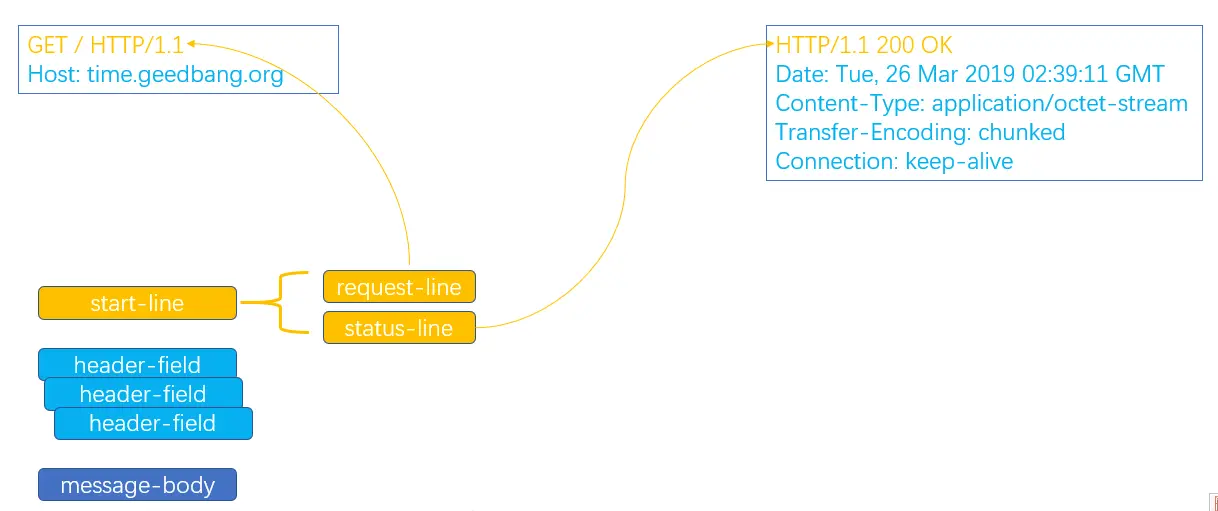

HTTP不变的协议过程

-

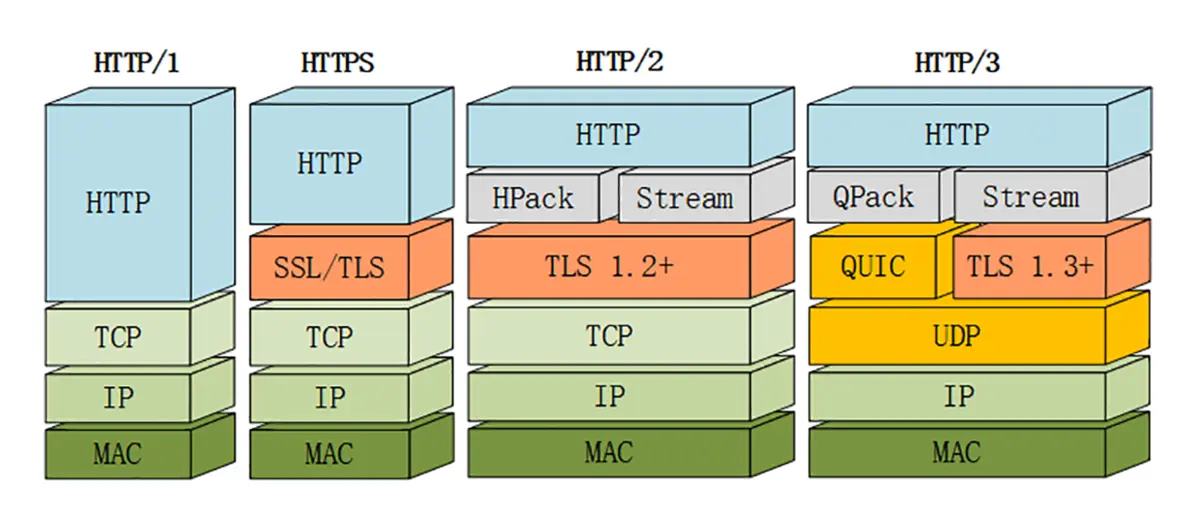

HTTP底层传输变化

-

HTTP1.1改进

- 默认持久连接

- 增加Cookie,虚拟主机,动态内容支持

- 使用CDN的实现域名分片机制

-

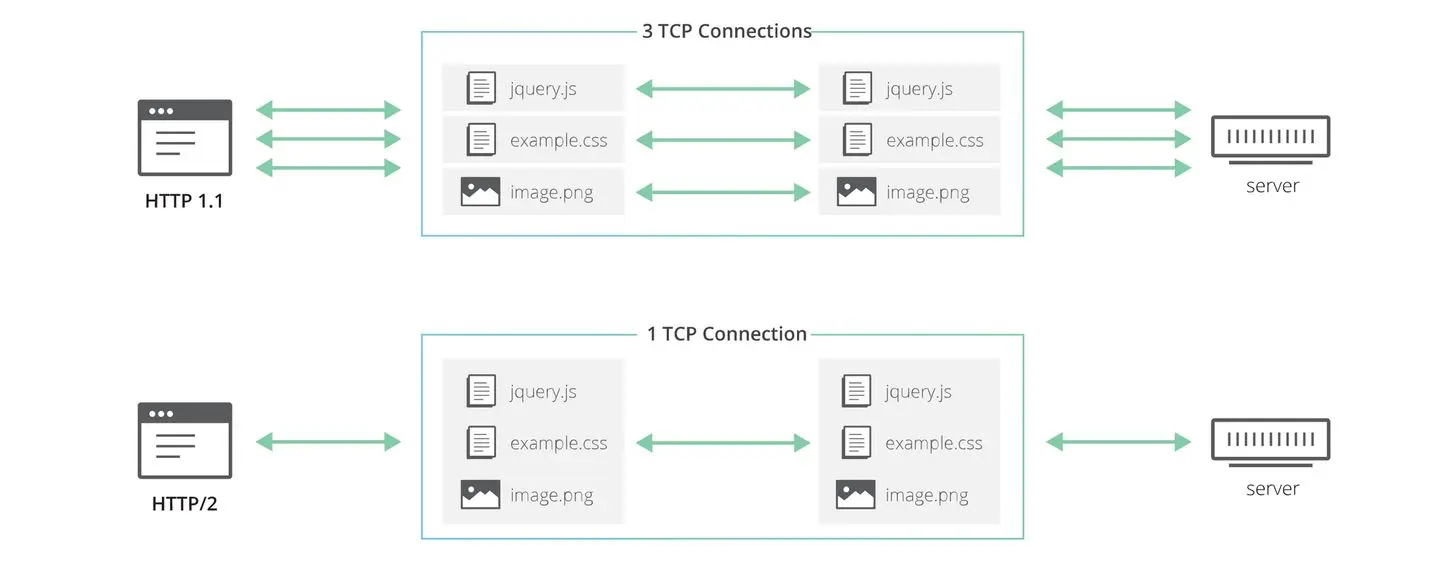

HTTP1.1问题

- TCP的慢启动

- 多条TCP连接竞争带宽

- 队头阻塞

-

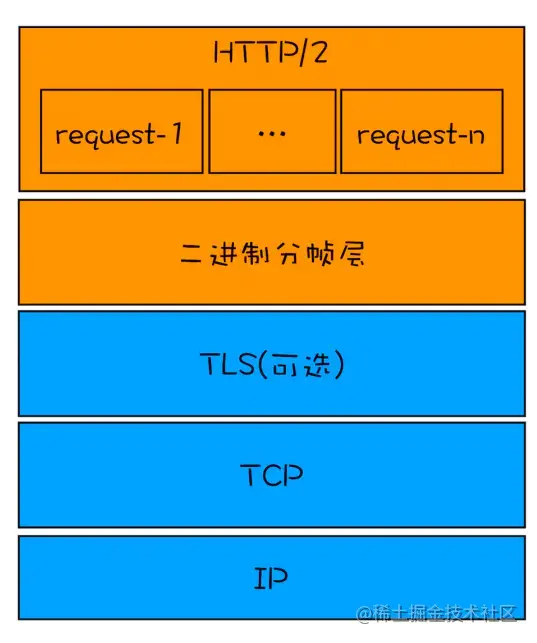

HTTP2改进

- 二进制分帧层

- 请求的优先级

- 服务器推送

- 头部压缩

-

HTTP2问题

- 有序字节流引出的队头阻塞(Head-of-line blocking),使得HTTP2的多路复用能力大打折扣

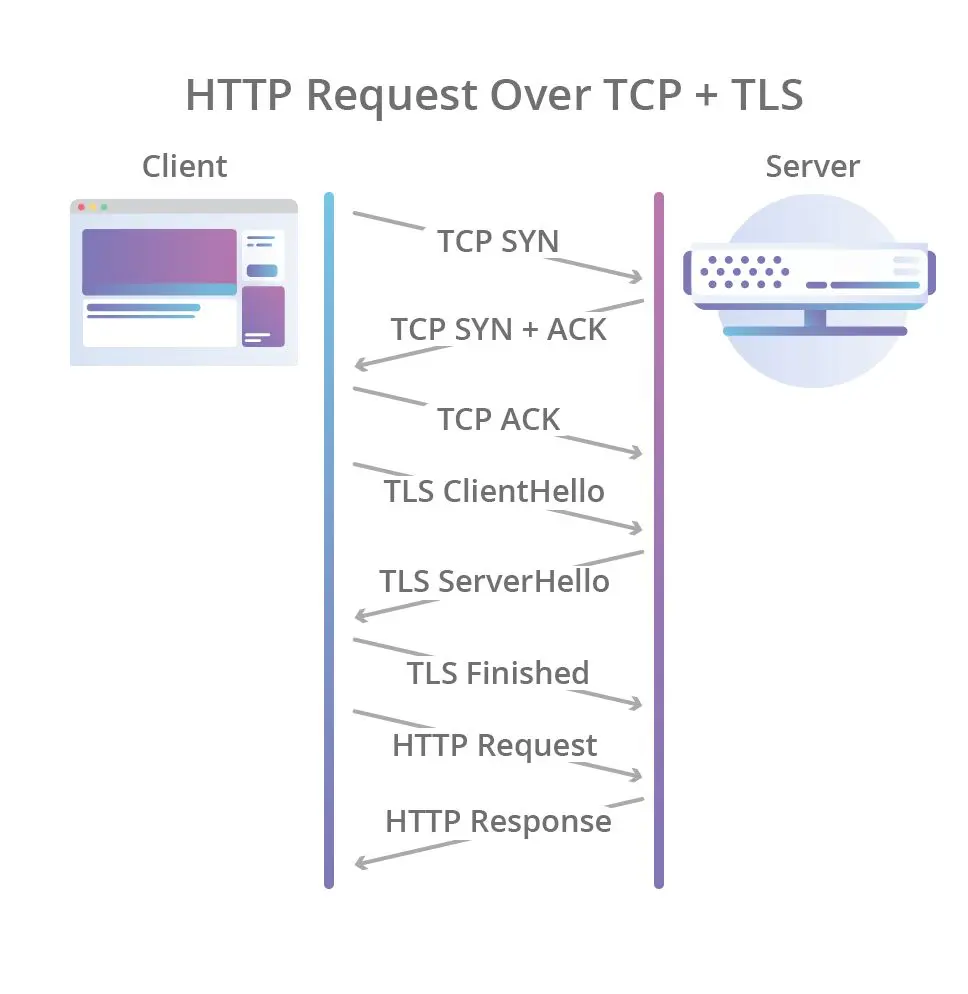

- TCP与TLS叠加了握手时延,建链时长还有1倍的下降空间

- 基于TCP四元组确定一个连接,这种诞生于有线网络的设计,并不适合移动状态下的无线网络,这意味着IP地址的频繁变动会导致TCP连接、TLS会话反复握手,成本高昂。

-

HTTP3改进

- HTTP3基于UDP协议重新定义了连接,在QUIC层实现了无序、并发字节流的传输,解决了队头阻塞问题

- HTTP3重新定义了TLS协议加密QUIC头部的方式,既提高了网络攻击成本,又降低了建立连接的速度

- HTTP3 将Packet、QUIC Frame、HTTP3 Frame分离,实现了连接迁移功能,降低了5G环境下高速移动设备的连接维护成本

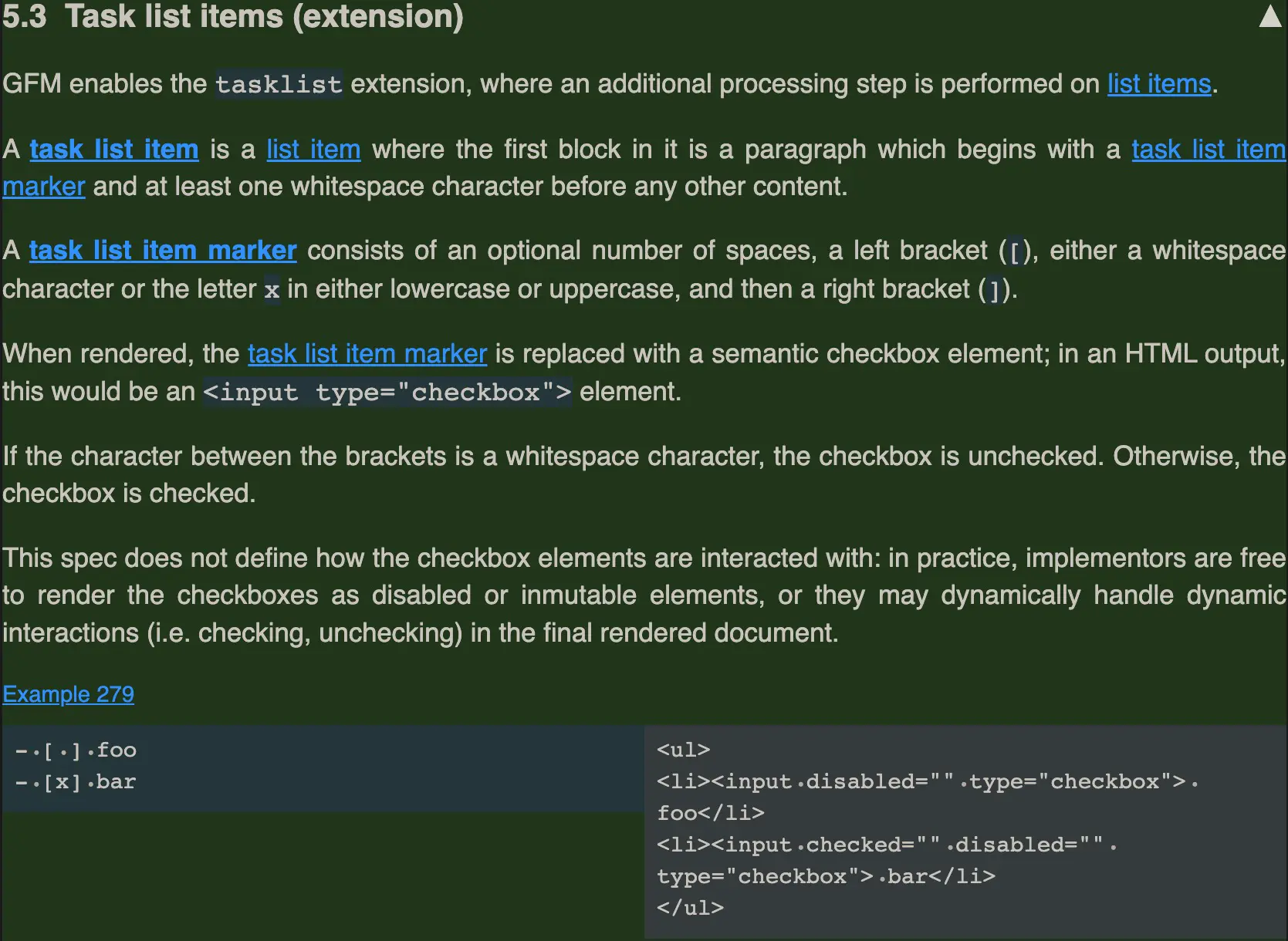

jwt(JSON Web Token)

-

是为了在网络应用环境间传递声明而执行的一种基于JSON的开放标准((RFC 7519).该token被设计为紧凑且安全的,特别适用于分布式站点的单点登录(SSO)场景。

-

服务器采用秘钥签名检验token内部数据是否正确,不再保存session

-

传统session方案,占用内存,不易扩展

sequenceDiagram

actor u as 用户

actor s as 服务器

u->>s: login登陆

s-->>u: form填写用户名密码

u->>s: Post用户名密码

s->>s: 数据库检查,生成并保存session

s-->>u: setcookie sessionID

u->>s: cookies带上sessionID

s->>s: 根据sessionID,获取session

s-->>u: 提供服务

- jwt方案,服务器私用secret,除过期时间之外,token不易作废

sequenceDiagram

actor u as 用户

actor s as 服务器

u->>s: login登陆

s-->>u: form填写用户名密码

u->>s: Post用户名密码

s->>s: 数据库检查,利用secret生成token

s-->>u: Authorization token

u->>s: Authorization token

s->>s: 根据secret,检验token

s-->>u: 提供服务

- jwt-token构成

flowchart LR

subgraph Header

h(json对象base64编码)

end

subgraph Payload

p(json对象base64编码)

end

subgraph Signature

s(加密计算后base64编码)

end

Header--用点号.连接-->Payload--用点号.连接-->Signature

- Header示例

{

"alg": "HS256",

"typ": "JWT"

}

- Payload示例

{

"sub": "1234567890",

"name": "John Doe",

"admin": true

}

- Signature

HMACSHA256(

base64UrlEncode(header) + "." +

base64UrlEncode(payload),

secret)

- 实例展示

eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJzdWIiOiIxMjM0NTY3ODkwIiwibmFtZSI6IkpvaG4gRG9lIiwiYWRtaW4iOnRydWV9.TJVA95OrM7E2cBab30RMHrHDcEfxjoYZgeFONFh7HgQ

系统容错 限流-熔断-降级

- 限流,当核心服务的处理能力不能应对外部请求的突增流量时,必须采取限流的措施。

- 熔断,非核心服务

sequenceDiagram

actor u as 用户

actor l as 断路器

actor s as 服务

u->>l: 请求

l->>s: 转发请求

s-->>l: 成功回包

l-->>u: 转发成功回包

u->>l: 请求

l->>s: 转发请求

s-->>l: 失败

l->>l: 累计失败,达到阀值

l-->>u: 转发失败

u->>l: 请求

l->>l: 检查服务恢复?

l-->>u: 回包失败

-

服务熔断是指调用方访问服务时通过断路器做代理进行访问,断路器会持续观察服务返回的成功、失败的状态,当失败超过设置的阈值时断路器打开,请求就不能真正地访问到服务了。

-

CLOSED:默认状态。断路器观察到请求失败比例没有达到阈值,断路器认为被代理服务状态良好。

-

OPEN:断路器观察到请求失败比例已经达到阈值,断路器认为被代理服务故障,打开开关,请求不再到达被代理的服务,而是快速失败。

-

HALF OPEN:断路器打开后,为了能自动恢复对被代理服务的访问,会切换到半开放状态,去尝试请求被代理服务以查看服务是否已经故障恢复。如果成功,会转成CLOSED状态,否则转到OPEN状态

-

降级-采用预设方案行动,针对非核心,非必要服务

webdav

- WebDAV (Web-based Distributed Authoring and Versioning) 一种基于 HTTP 1.1协议的通信协议。

- 它扩展了HTTP 1.1,在GET、POST、HEAD等几个HTTP标准方法以外添加了一些新的方法,

- 使应用程序可对Web Server直接读写,并支持写文件锁定(Locking)及解锁(Unlock),还可以支持文件的版本控制。

jsonnet

brew install jsonnet

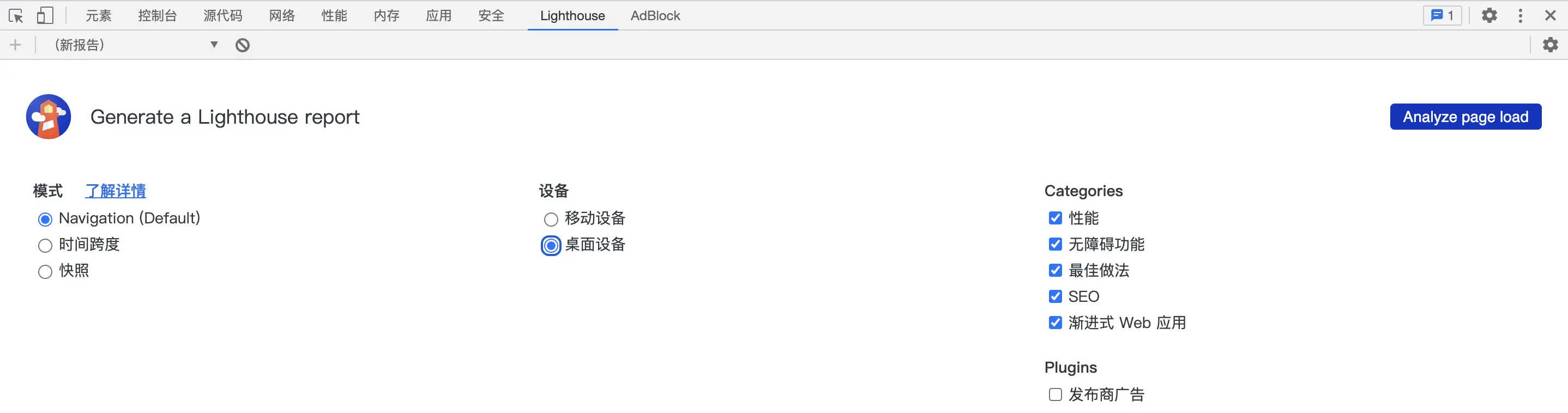

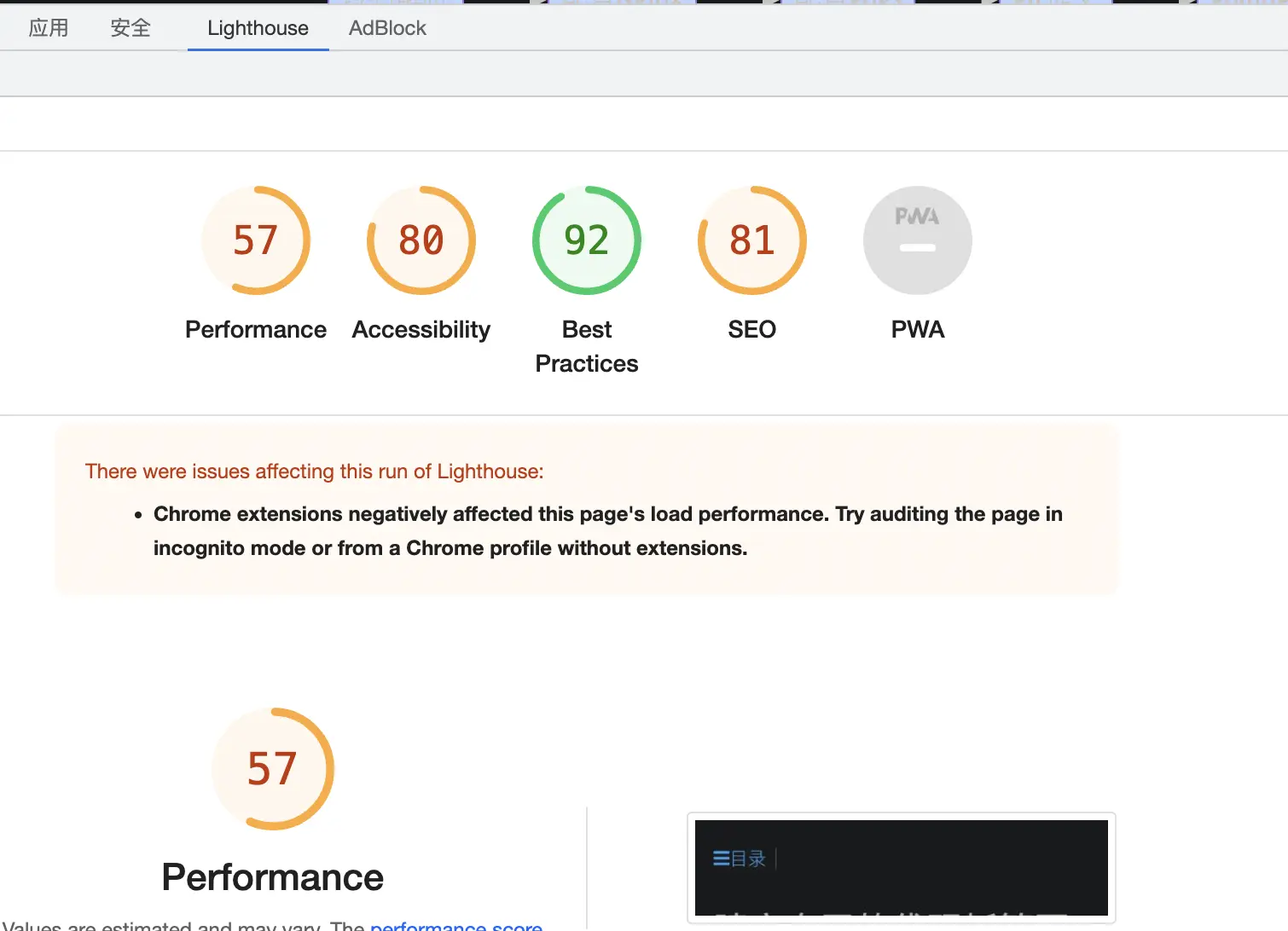

优化方向

-

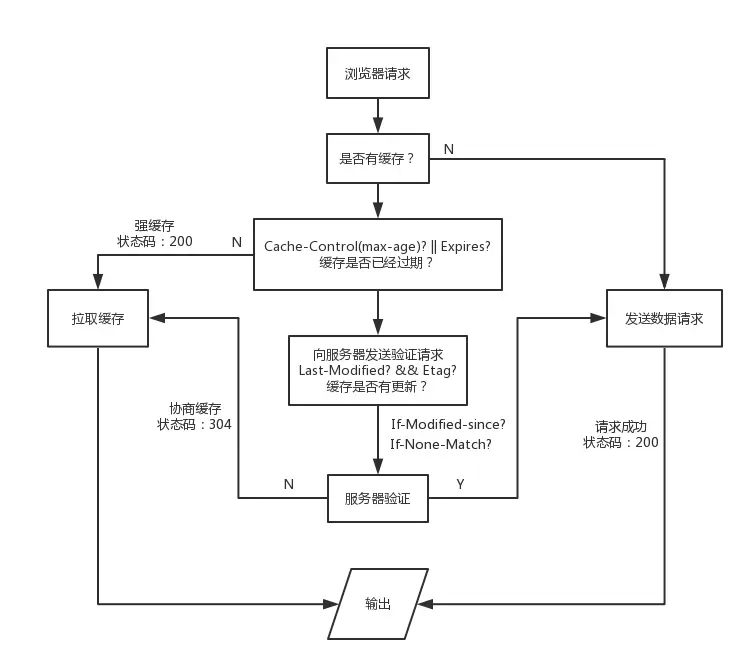

浏览器处理缓存,如下图所示

-

webpack打包

-

图片换格式WebP

-

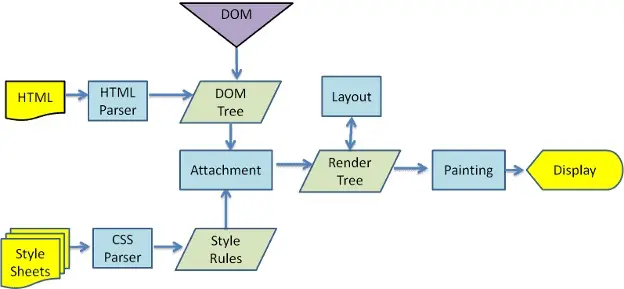

浏览器处理HTML

优秀网站

-

Confluence-团队文档,据说现在不能私有部署

国内cdn介绍

- BootCDN: www.bootcdn.cn

- 七牛云: www.staticfile.org

- 360: cdn.baomitu.com

- 字节跳动: cdn.bytedance.com

- 饿了么:github.elemecdn.com npm.elemecdn.com

- 知乎:unpkg.zhimg.com

mac

码农必备

1. iTerm2

-

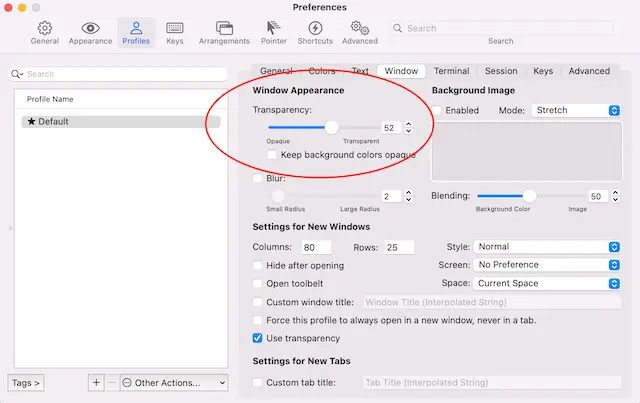

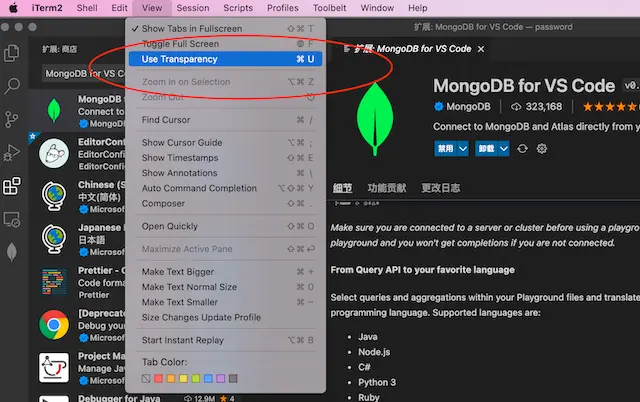

配置cmd+u切换窗口透明

-

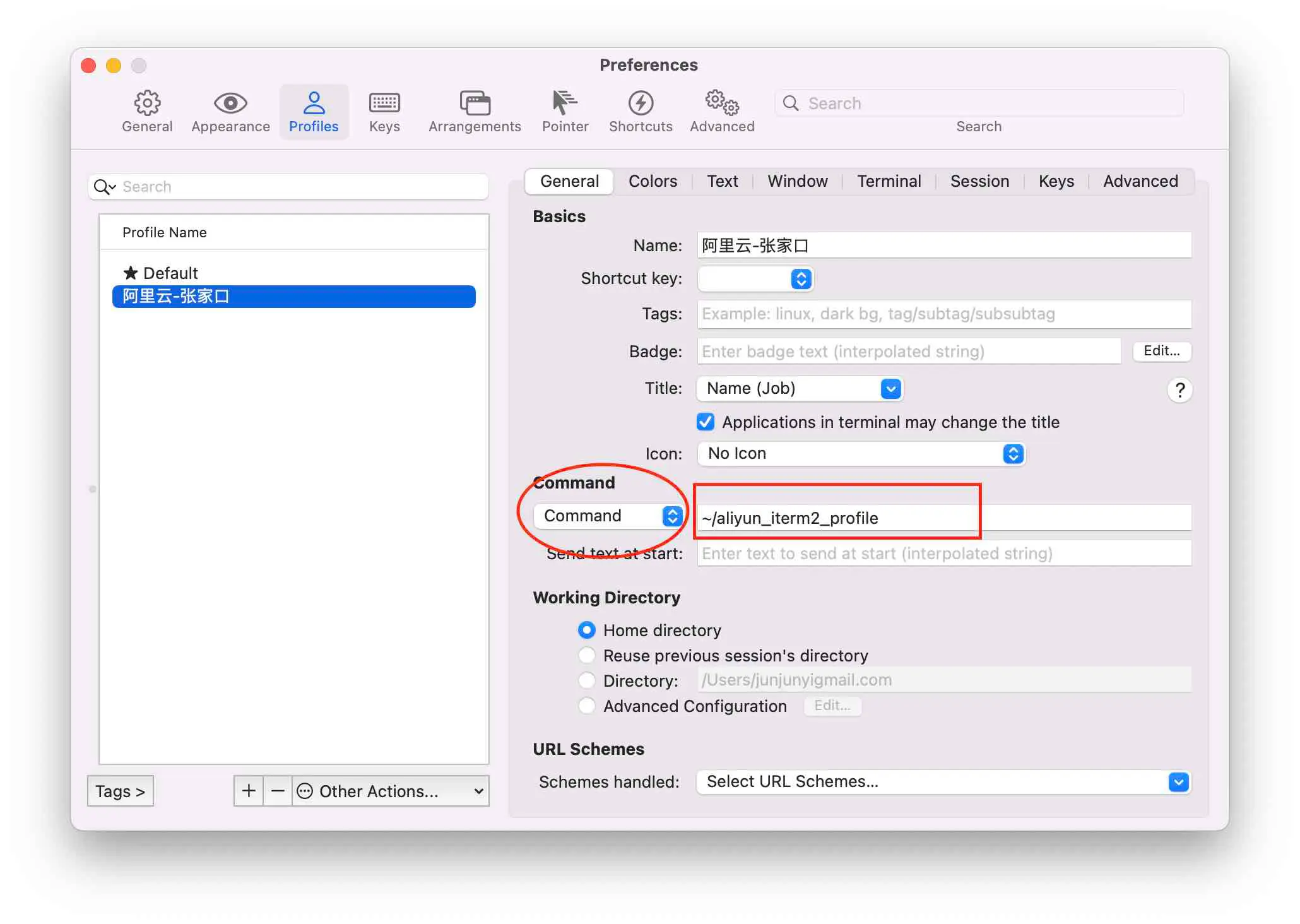

快速ssh

-

创建一个profile脚本

vim aliyun_iterm2_profile #填写模板内容,替换主机地址和密码,有可能第一次需要手动ssh root@xxxx,添加信任主机 #!/usr/bin/expect -f set user root set host ip set password pwd set timeout -1 spawn ssh $user@$host expect "*password:*" send "$password\r" interact expect eof #增加可执行权限 chmod a+x aliyun_iterm2_profile -

增加profile配置

command要从login shell->command,上图中红色圈圈

上图中红色方框填入第一步profile路径

-

选择执行profile

-

-

替代品wrap

- 安装时需要注册帐户,目前采用github授权,最好翻墙,否则会完成不了整个过程

2. brew

3.oh-my-zsh

-

安装命令

# 如果github访问不了,导致安装不了.则采用国内源安装 # /bin/zsh -c "$(curl -fsSL https://gitee.com/cunkai/HomebrewCN/raw/master/Homebrew.sh)" sh -c "$(curl -fsSL https://raw.github.com/ohmyzsh/ohmyzsh/master/tools/install.sh)" -

常用插件

plugins=( git docker extract dnf colored-man-pages command-not-found zsh-syntax-highlighting zsh-autosuggestions ) 历史记录采用年月日 HIST_STAMPS="yyyy-mm-dd" 在~/.zshrc配置文件里设置ZSH_THEME为你的主题名称 ZSH_THEME="robbyrussell" alias cd="z" alias ping="gping" alias ps="procs -tree" alias du="dust" alias df="duf" alias ls="exa -l --header --git" alias cat="bat" eval "$(mcfly init zsh)" eval "$(zoxide init zsh)"- zsh-syntax-highlighting

- zsh-autosuggestions

- extract 所有类型的文件解压一个命令x全搞定,再也不需要去记tar后面到底是哪几个参数了。

- command-not-found 当你输入一条不存在的命令时,会自动查询这条命令可以如何获得

- zoxide代替cd,可能不用启动z

- 提供一个 z 命令,在常用目录之间跳转。类似 autojump,但是不需要额外安装软件。

- gping图形化显示ping结果

- colored-man-pages 给你带颜色的 man 命令

- docker 自带插件,可以实现docker命令补全和自动提示。

- difft 自带语法比较,可以替代diff

# Set git configuration for the current repository. git config diff.external difft # Set git configuration for all repositories git config --global diff.external difft- 官方还提供了大量插件,大部分是针对某些功能的命令补全,如golang, python, pip, ruby, vagrant等。

# 显示最近10条历史命令 history [start] [end],正数从头,负数从尾 history -E -10- 禁止自动更新

打开ohmyzsh(zsh) 的配置文件: ~/.zshrc 找到DISABLE_AUTO_UPDATE一行,将行首的注释'#'去掉,则可禁用ohmyzsh 自动检查更新。

4. vscode

Visual Studio Code 有一个广泛的扩展市场,可以增加你的便利度。但在安装其中一个之前,最好先看看它是否还没有原生支持。随着时间的推移,包含改进和功能的每月发布更新,越来越多的 Visual Studio Code 扩展将不再需要。“有一堆扩展是 bulitin 的,你可以禁用所有你不需要的。进入扩展面板,搜索 @builtin”

-

优秀插件

-

tabnine 有免费的AI助手编码,必须强赞一下

-

CodeGeex 另一个自动生成代码 https://codegeex.cn/

-

shellman shellcheck shell-format(Alt+Shift+F) Code Runner

-

NGINX Configuration Language Support

-

Go for Visual Studio Code 支持一键生成单元测试

-

Python

-

MongoDB for VS Code

-

Redis For VS Code

-

MySQL

-

vscode-drawio 直接在vscode中画图

-

docker

-

toml

-

yaml

-

vscode-pdf

-

Markdown PDF

-

Markdown Preview Mermaid Support

-

vscode-proto3 在.vscode里面的settings.json设置protoc及相关路径

-

JumpProtobuf 在.proto文件跳转f12键

-

Git History

-

GitLens — Git supercharged

-

indent-rainbow

-

vscode-icons用icon标识不同文件

-

Better Comments用不同色彩展示注释

-

Error Lens加强错误显示

-

Project Dashboard把经常使用project固定到仪盘表中

-

CodeSnap 是一个代码截图插件,只需选中项目中相应的代码段,即可快速创建代码的截图。

-

tabnine-AI写代码帮助https://www.tabnine.com/

-

Copilot-AI写代码帮助https://github.com/features/copilot/,tabnine类似

-

Output Colorizer *.log文件彩色输出

-

vscode-database-client 高级使用需要收费 https://github.com/cweijan/vscode-database-client

-

swagger preview-可以设置端口,直接测试接口

-

Hex Editor 以16进制格式查看文件

-

Rainbow CSV

-

Rainbow Brackets

-

Excel Viewer

-

Prettify JSON

-

Path Autocomplete

-

SQL Formatter

-

Regex Previewer

-

Code Spelling checker

-

English word hint

-

Peacock 自定义标题栏及左侧的颜色,同时打开多个vscode有用

-

vscode-fileheader 插入文件头注释,并且自动更新时间及作者

-

-

自带markdown preview功能,cmd+shift+v

-

tab/shift+tab整体正/反缩进,cmd+click跳进,ctrl+-跳回

-

已知bug

-

vscode打开目录层次不对,应该直接打开工程目录,不能打开父目录,否则报下面错误

could not import github.com/gomodule/redigo/redis (cannot find package "github.com/gomodule/redigo/redis" in any of /usr/local/go/src/github.com/gomodule/redigo/redis (from $GOROOT) /Users/.../gopath/src/github.com/gomodule/redigo/redis (from $GOPATH)) -

自动保存可能会自动插入空格,在生成代码文件,需要注意,可能造成bug.

-

-

修改go test timeout超时

- 点击左下角齿轮->设置 打开用户设置

- 在搜索栏中输入 go test timeout

- 可以找到 go.testTimeout为30s

-

工作空间 workspace多个目录一起打开,组合

-

命令行直接调用

- 命令面板(shift+cmd+p)

- 输入shell command

- 选择Install ‘code’ command in PATH

- 命令行输入code .

-

代码片断

- 打开vscode,file–>preference(首选项)—>user snippets(用户代码片断),输入python回车,添加如下代码:

"Print with space lines": { "prefix": "ppp", "body": [ "print('\\n'*2, $1)", ], "description": "Print with space lines" }

然后在编写python程序 时候,连续按ppp就可以快捷输出打印变量。

5. fig大幅度提高效率

# 下载安装保存位置

~/.local/bin

- 需要填写邮箱用来同步设置,否则没有效果

6. webp converter批量转换webp格式,appstore免费

7. Atomgithub开源免费文本编辑器,已死掉了

- 优秀插件

- simplified-chinese-menu

- go-plus

- markdown-writer

- platformio-ide-terminal

- file-icons

- regex-railroad-diagram

8. sublimetext,闭源可免费使用文本编辑器

-

安装打开终端插件 terminus

-

cmd+shift+p 然后输入 install package 输入 terminus

-

配置key

{ "keys": ["ctrl+`"], "command": "toggle_terminus_panel", }, { "keys": ["ctrl+shift+`"], "command": "terminus_open", "args": { "cwd": "${file_path:${folder}}" } },

-

-

安装语法高亮nginx配置文件插件 sublime-nginx/Nginx Log Highlighter

- cmd+shift+p 然后输入 install package 输入 nginx

-

安装shell脚本语法高亮插件 Pretty Shell

- cmd+shift+p 然后输入 install package 输入 Pretty Shell

-

安装markdown插件 markdown Editing

- cmd+shift+p 然后输入 install package 输入 [markdown Editing]

-

Rainbow Brackets

-

Git

-

GitGutter 更进一步

-

GitSyntaxes

-

tabnine插件

-

AutoFileName

-

Pretty JSON

-

Pretty Protocol buf

-

Protocol Syntax Highlighting

-

FileIcons

-

SQL Formatter

-

advanced CSV

-

Rainbow CSV

-

JsFormat

-

HTMLBeautify

-

docker file lint/ docker high light

-

chinese localization––中文汉化

-

chinese words cutter-中文分词

-

主题及color主题是两种,可以分开选择

-

SideBar Enhancements

vim ~/.zshrc

# Set Sublime Text Alias

alias subl="'/Applications/Sublime Text.app/Contents/SharedSupport/bin/subl'"

# 使配置生效

source ~/.zshrc

# 打开sublime

subl

# 使用sublime打开当前目录

subl .

9. chrome,无google全家桶的chrome

brew install --cask eloston-chromium

10. marktext,开源免费的markdown编辑器

brew install --cask eloston-chromium

利用蓝牙传输文件

-

在“系统偏好设置“->“蓝牙”开启功能

-

等待发现蓝牙设备,连接设备,在设备上同意配对

-

mac向设备传输文件使用“蓝牙文件交换”(位于“应用程序”文件夹的“实用工具”文件夹中)

-

设备向mac传输文件,则mac设置蓝牙共享,“系统偏好设置”->“共享”

-

蓝牙传输超慢,建议采用局域网sftp,mac自带sftp服务

无法验证开发者

解决办法:在Finder中找到应用程序,并找到该程序,右键->打开

“xxx.app”已损坏,无法打开。 你应该将它移到废纸篓

- 终端执行,打开允许任意来源app

sudo spctl --master-disable

- 手动执行相信特定app

sudo xattr -rd com.apple.quarantine /Applications/xxx.app/

- 系统设置–>隐私性及安全–>调回只任信store及开发者,防止其他app误操作

开机启动

-

Login Items

- 在~/Library/Preferences/com.apple.loginitems.plist

- 在系统偏好设置的“用户与群组”下面进行设置,可以删除、添加、开启和关闭;

-

Launchd Daemon,launchd来负责启动

- ~/Library/LaunchAgents

- /Library/LaunchAgents

- /System/Library/LaunchAgents

- ~/Library/LaunchDaemons

- /Library/LaunchDaemons

- /System/Library/LaunchDaemons

-

StartupItems

- /System/Library/StartupItems

- /Library/StartupItems

技巧

- 在命令行打开访达当前目录

open 特定目录

open .

- 截屏 shift+cmd+5 非常不错,谁用知道

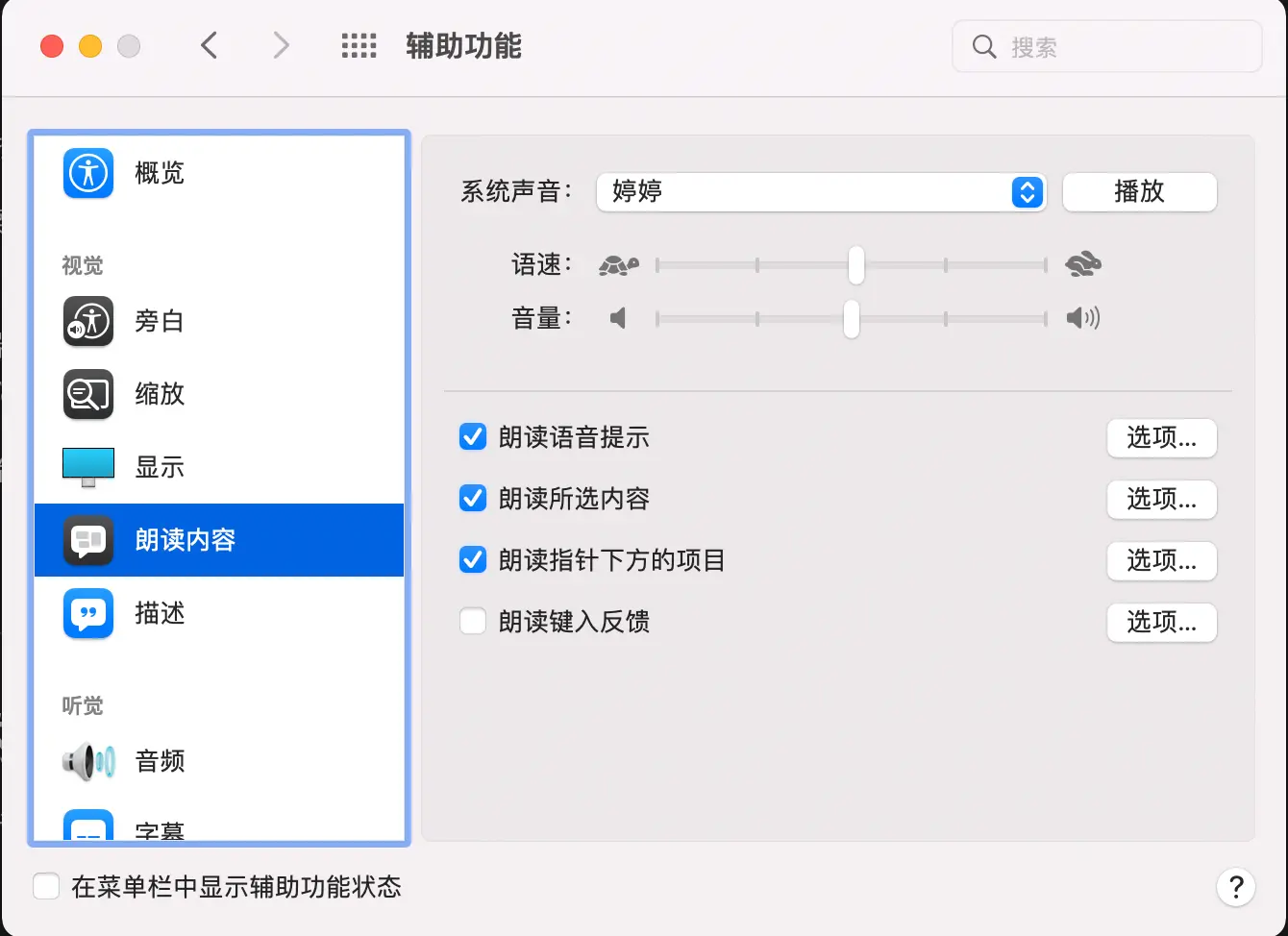

- 朗读-读出所选内容(option+ecs),如果没有效果,则可能系统声音选择不对,本机器上反应有点慢,要等几秒才能读。

- mac字体路径 /System/Library/Fonts,/Library/Fonts,ttf是mac和freetype共同推出的字体文件,ttc是ttf的集合文件(https://www.cnblogs.com/fortunely/p/16651504.html)

- 目前苹果有intel和M1芯片两种,软件下载安装时,注意Mac silicon/arm64/aarch指明适用M1芯片

- xcode默认只有英文界面,不支持中文界面

- iphone采用数据线连上mac,在新版的mac上没有iTunes,在访达偏好设置中有一个显示ios设备选项,否则无法显示出来!

- AppleID网络iCloud同步,前面打勾就会自动上传或下载同步iCloud空间中,

- iCloud云盘是iCloud空间一个目录,本地也有一个对应目录

- 照片也是iCloud空间一个目录,本地也有一个对应目录

- 其他华为,小米帐号iCloud空间都是类似的

- 查看端口

lsof -i tcp:8080

- 查看本机地址

# mac把Wi-Fi称为en0

ifconfig en0

-

修改hosts sudo vim /etc/hosts

-

深色模式,保护眼睛

-

删除Microsoft Auto Update,烦人的更新提示

cd /Library/Application Support/Microsoft/MAU2.0 sudo rm -rf Microsoft\ AutoUpdate.app -

树状显示目录tree

brew install tree tree -

十六进制显示文件

# xxd系统自带,-l只显示开头40字节 xxd -l 40 filename -

访达/系统按键

名称 作用 回车键 重命名文件夹或文件 command + o 打开文件 command + ↓ 打开文件 command + ↑ 进入当前目录的上一级目录 空格键 预览 -

imagemagick 图像处理神器

brew install imagemagick

# 注意参数位置density是修饰pdf,否则会采用默认72dpi

magick convert -density 300 enroll-sch.pdf -resize 1330x1900 -quality 100 ./photo/enroll-sch.jpg

- ssh免密登录远程

# 输入密码就能实现远程免密登陆,本质上pub文件内容加到远程机器~/.ssh/authorized_keys文件中

ssh-copy-id -i /root/.ssh/id_rsa.pub root@192.168.0.104

-

鼠标按windows滚动

- 打开Mac系统偏好设置

- 在系统偏好设置界面,点击“鼠标“

- 进入鼠标的设置窗口,单击“光标与点按“标签

- 在光标与点按设置面板,将“滚动方向:自然“的勾选去掉即可

- 然后在滑动鼠标,即和windows的滚轮一样了

-

替换按键ctrl+alt

-

mac电脑的默认字体-苹方字体,中文就是-苹方-简,有专门的“字体册“app管理

-

编程仅好字体 Menlo, Monaco, ‘Courier New’, monospace 12大小

-

socket: operation not permitted - socket 无权限监听问题,一次性给root权限

sudo chown root:admin xxx

sudo chmod +sx xxx

pip(3)error: externally-managed-environment解决办法,增加参数

pip install websocket

pip install --break-system-packages websocket

pip3 install -U uiautomator2 --break-system-packages

pip3 install -U uiautodev --break-system-packages

AI工具与工作流日常

在日常学习与工作中,习惯使用多种AI工具和自动化命令行工具来提升效率。以下是在不同场景下常用的几款工具。

1. 文心一言

- 用途:主要用于中文内容创作和多模态任务,例如撰写文章、生成文案、图像描述等。

- 特点:百度出品,中文理解能力强,支持图文生成。

- 使用场景:当我需要快速生成高质量的中文文本时,文心一言是我首选的工具之一。

2. 豆包

- 用途:作为多语言助手,豆包在翻译、跨语言沟通和日常问答中表现出色。

- 特点:字节跳动开发,支持多语言切换,界面简洁。

- 使用场景:在处理国际化内容或需要多语言支持时,豆包能提供快速响应。

3. 千问(Qwen)

- 用途:我日常使用千问进行代码生成、逻辑推理和多语言写作。

- 特点:由阿里巴巴开发,训练数据丰富,支持多种编程语言和复杂推理任务。

- 使用场景:在开发和写作中,千问帮助我快速生成代码片段、分析问题和撰写专业内容。

4. 月之暗面

- 用途:主要用于深度对话和推理任务。

- 特点:具备较强的上下文理解和推理能力,适合长时间对话。

- 使用场景:当我需要进行复杂的逻辑推理或长时间的对话交互时,月之暗面是理想选择。

5. iflow cli

- 用途:这是一个命令行自动化工具,用于简化工作流程。

- 特点:支持任务自动化、脚本执行和工作流管理。

- 使用场景:在日常开发和运维中,iflow cli帮助我自动化重复性任务,节省时间。

总结:这些工具各有所长,根据不同的任务需求灵活选择。文心一言和豆包适合语言和内容生成,千问和月之暗面在推理和对话上表现突出,而iflow cli则是自动化工作流的得力助手。

智能体=大模型+SKILL+MCP

如果把智能体(Agent)比作一个**“活生生的人”**,那么你的这个等式可以完美拆解为:

- 大模型 (LLM) = 大脑(思考与决策)

- SKILL = 本事(会开车、会做饭、会修电脑)

- MCP = 神经系统(连接大脑与手脚的通道)

1. 大模型 (LLM):大脑

这是智能体的**“认知核心”**。

- 它负责什么: 理解用户说的话(自然语言理解)、思考怎么解决问题(推理规划)、决定下一步该调用哪个技能(决策)。

- 没有大脑会怎样: 就像植物人,虽然有手有脚(有技能),但动不了。

2. SKILL:本事/手脚

这是智能体的**“能力单元”**。

- 它负责什么: 真正去“干活”。比如“发邮件”是一个 Skill,“画图”是一个 Skill,“查天气”也是一个 Skill。

- 没有 Skill 会怎样: 就像一个只会夸夸其谈的书呆子。你问它“帮我订张机票”,它只能说“好的,正在为您查询…”,但实际根本动不了手。Skill 是具体执行动作的实体。

3. MCP:神经系统/USB接口

这是智能体的**“连接标准”**。

- 它负责什么: 建立大模型和 Skill 之间的通信。它告诉大模型:“外面有这些 Skill 可以用”,并且负责把大模型的指令(“我要用这个 Skill”)翻译成 Skill 能听懂的代码格式(API 调用),再把 Skill 执行的结果传回给大模型。

- 没有 MCP 会怎样: 大脑想动脚,但神经断了,脚根本收不到信号。或者就像你有一个 Type-C 接口的手机(Skill),但充电器是老式圆孔的(不兼容),插不上,没法用。

🚀 举个例子:点外卖

假设用户的指令是:“饿了,帮我点一份麦当劳,送到工位。”

-

大脑(大模型) 开始思考:

- “用户饿了,需要食物。”

- “我需要调用‘点外卖’这个能力。”

- “但我还需要知道他的地址和手机号。”(可能会先调用“获取个人信息”的Skill)

-

神经系统(MCP) 开始工作:

- 大脑通过 MCP 协议喊话:“谁有‘点外卖’这个 Skill?”

- MCP 发现有一个“美团外卖”的 Skill 接在系统上。

- MCP 建立连接通道。

-

本事(SKILL) 开始执行:

- “点外卖 Skill” 接收到参数(麦当劳、地址)。

- 它自动运行代码,打开浏览器,登录账号,搜索店铺,下单支付。

-

反馈:

- Skill 把“下单成功”的消息通过 MCP 传回给大脑。

- 大脑对你说:“老板,饭点好了,预计20分钟后到。”

总结

公式 智能体 = 大模型 + SKILL + MCP 完美概括了现代 AI 智能体的架构:

- 大模型 负责 “想” (策略)

- SKILL 负责 “做” (执行)

- MCP 负责 “连” (通信)

有了这三样,AI 才从一个**“聊天机器人”(只能动嘴),进化成了一个“数字员工”**(能动手、能跑腿)。

最简单的智能体

用 Python 实现一个“最简单”的智能体,核心其实就是搭建一个**“大脑循环”。这个循环非常精简,只做一件事:规划 -> 决策(选动作) -> 执行 -> 输出。 用一个“懒人点餐助手”**为例。这个智能体有两个核心能力(技能):搜索(查餐厅)和 Finish(给出最终回答)。

import os

import json

import requests

# ============ 配置区 ============

# 替换为你的 API Key

API_KEY = "your-api-key-here"

BASE_URL = "https://api.deepseek.com" # DeepSeek 的接口地址

# ============ 工具定义 (你的 Skill 库) ============

# 这是智能体的“技能包”,告诉模型它能做什么

TOOLS = [

{

"type": "function",

"function": {

"name": "search_restaurant",

"description": "根据用户需求搜索附近的餐厅",

"parameters": {

"type": "object",

"properties": {

"query": {

"type": "string",

"description": "用户想吃的菜系或餐厅名,例如 '川菜'、'火锅'"

}

},

"required": ["query"]

}

}

},

{

"type": "function",

"function": {

"name": "final_response",

"description": "当信息收集完毕,用来给用户最终回复",

"parameters": {

"type": "object",

"properties": {

"final_message": {

"type": "string",

"description": "给用户的最终回复内容"

}

},

"required": ["final_message"]

}

}

}

]

# ============ 工具函数 (真正干活的代码) ============

def search_restaurant(query):

"""模拟搜索餐厅的函数"""

print(f"\n[工具调用] 正在搜索: {query}...")

# 这里可以接入真实的高德/美团API,这里用模拟数据

return f"为您找到以下餐厅:1. 老王川菜馆(评分4.8) 2. 麻辣江湖(评分4.6) 3. 川味一绝(评分4.5)"

def final_response(final_message):

"""输出最终结果"""

print(f"\n[结束] 智能体说: {final_message}")

return "任务完成"

# ============ 智能体核心循环 ============

def run_agent(user_input):

# 1. 初始化消息历史

messages = [{"role": "user", "content": user_input}]

print(f"[输入] 用户说: {user_input}")

while True:

try:

# 2. 调用大模型 (大脑)

response = requests.post(

f"{BASE_URL}/chat/completions",

headers={

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

},

json={

"model": "deepseek-chat", # 使用 DeepSeek 模型

"messages": messages,

"tools": TOOLS, # 告诉模型有哪些技能

"tool_choice": "auto" # 自动选择技能

}

)

# 3. 解析模型返回

resp_json = response.json()

message = resp_json.choices[0].message

# 4. 判断模型是否想调用工具

if message.tool_calls:

# --- 决策:模型选择了某个 Skill ---

tool_call = message.tool_calls[0]

tool_name = tool_call.function.name

tool_args = json.loads(tool_call.function.arguments)

print(f"[思考] 嗯...我需要调用 '{tool_name}' 这个技能来解决。")

# 把模型的回复加到历史里(记录它的思考)

messages.append(message)

# --- 执行:运行具体的 Skill 代码 ---

if tool_name == "search_restaurant":

tool_result = search_restaurant(tool_args["query"])

elif tool_name == "final_response":

final_response(tool_args["final_message"])

break # 结束循环

# --- 反馈:把工具执行的结果告诉模型 ---

messages.append({

"role": "tool",

"tool_call_id": tool_call.id,

"name": tool_name,

"content": tool_result

})

else:

# 模型直接给出了答案(没有调用工具)

print(f"[结束] 智能体说: {message.content}")

break

except Exception as e:

print(f"发生错误: {e}")

break

# ============ 运行测试 ============

if __name__ == "__main__":

# 测试:用户输入

run_agent("我想吃火锅,帮我推荐几家附近的。")

第三步:代码解析(智能体的四大要素)

运行这段代码,发现它其实就包含了智能体的所有核心要素:

-

大脑(LLM):

requests.post(...)这一部分就是调用大模型。- 它负责思考:是直接回答,还是去查餐厅?

-

技能(Skills/Tools):

TOOLS列表定义了智能体能做什么。search_restaurant是一个 Skill(查餐厅)。final_response是另一个 Skill(结束对话)。

-

规划与决策(The Loop):

while True循环就是智能体的“心跳”。- 它不断检查:“我需要调用工具吗?” -> “调用哪个?” -> “执行结果是什么?” -> “下一步怎么做?”。

-

执行(Function Call):

if tool_name == ...这一段就是真正执行代码的地方。

运行效果

当你运行代码时,输出大概是这样的:

[输入] 用户说: 我想吃火锅,帮我推荐几家附近的。

[思考] 嗯...我需要调用 'search_restaurant' 这个技能来解决。

[工具调用] 正在搜索: 火锅...

[思考] 嗯...我需要调用 'final_response' 这个技能来解决。

[结束] 智能体说: 为您找到以下餐厅:1. 老王川菜馆... (省略)

skill

开发一个 MCP Skill 其实就是编写一个能够响应 MCP 协议请求的程序

第一步:环境准备

你需要安装 MCP 的官方 Python 库。

# 创建项目目录

mkdir mcp-smart-home-skill

cd mcp-smart-home-skill

# 推荐使用虚拟环境

python -m venv venv

source venv/bin/activate # Windows: venv\Scripts\activate

# 安装核心库

pip install mcp

第二步:编写 Skill 代码

创建一个 Skill,让它具备“获取天气”和“控制灯光”的能力。

-

创建文件:新建一个文件

smart_home_skill.py。 -

编写代码:

from mcp.server.fastmcp import FastMCP

from mcp.types import TextContent, ImageContent

import requests

import json

# 初始化 MCP Server (也就是你的 Skill)

mcp = FastMCP("SmartHome Skill")

# ==========================================

# Skill 1: 获取天气 (外部 API 调用)

# ==========================================

@mcp.tool()

def get_weather(location: str) -> TextContent:

"""

获取指定城市的天气情况。

注意:这里使用的是模拟数据,实际使用需接入高德/和风等真实API。

"""

# 这里是模拟逻辑,实际开发请替换为真实的 API 调用

# 示例:调用高德地图天气API

# url = f"https://restapi.amap.com/v3/weather/weatherInfo?city={location}&key=你的KEY"

weather_data = {

"city": location,

"weather": "晴",

"temperature": "25°C",

"wind": "微风"

}

result_text = f"【{location}天气】天气:{weather_data['weather']},气温:{weather_data['temperature']},风力:{weather_data['wind']}"

return TextContent(type="text", text=result_text)

# ==========================================

# Skill 2: 控制智能灯 (模拟)

# ==========================================

# 假设我们有一个简单的状态存储

light_status = {"客厅": "关", "卧室": "关"}

@mcp.tool()

def control_light(room: str, action: str) -> TextContent:

"""

控制指定房间的灯光开关。

"""

if room not in light_status:

return TextContent(type="text", text=f"错误:不支持{room}的灯光控制")

# 执行控制逻辑(这里可以替换为发送 MQTT 指令)

if action in ["开", "打开", "on"]:

light_status[room] = "开"

response = f"✅ 已为您打开{room}的灯"

elif action in ["关", "关闭", "off"]:

light_status[room] = "关"

response = f"✅ 已为您关闭{room}的灯"

else:

response = f"❌ 指令错误,不支持的操作:{action}"

# 打印状态用于调试

print(f"灯光状态更新: {light_status}")

return TextContent(type="text", text=response)

# ==========================================

# Skill 3: 查询设备状态

# ==========================================

@mcp.tool()

def get_device_status() -> TextContent:

"""

获取当前所有智能设备的状态。

"""

status_str = "🏠 当前设备状态:\n"

for room, status in light_status.items():

status_str += f" {room}灯:{status}\n"

return TextContent(type="text", text=status_str)

# ==========================================

# 启动入口

# ==========================================

if __name__ == "__main__":

# 运行 MCP Server,等待客户端(如 Cursor)连接

mcp.run(transport='stdio')

第三步:代码解析(Skill 的核心结构)

-

Server 初始化:

mcp = FastMCP("SmartHome Skill"):这行代码定义了你的 Skill 名字。AI 会通过这个名字来识别它能找谁帮忙。 -

Tool 定义(核心能力): 使用

@mcp.tool()装饰器来标记一个函数。每一个被装饰的函数就是一个 Skill。- 函数名:建议使用英文,代表 Skill 的唯一标识。

- 函数文档字符串 (Docstring):极其重要。AI 不读代码,只读注释。它决定了 AI 什么时候会调用这个 Skill。

- 参数:定义好参数类型(str, int),AI 会自动帮你从自然语言中提取参数。

-

返回值格式: MCP 协议要求返回特定的格式(如

TextContent或ImageContent),这样客户端才能正确解析并展示给用户。

第四步:在 Cursor 中配置并测试

-

启动服务: 在终端运行:

python smart_home_skill.py保持这个终端窗口打开。

-

配置 Cursor: 打开 Cursor 设置 -> MCP Servers -> Add Server。

- Name:

SmartHome Skill - Command:

python - Arguments:

/path/to/your/smart_home_skill.py(替换为你的实际路径)

- Name:

-

测试对话: 在 Cursor 聊天框中输入:

“打开客厅的灯,然后查一下北京的天气。”

预期效果: AI 会自动拆解任务,先调用

control_lightSkill,再调用get_weatherSkill,最后把结果整合回复给你。

进阶:Skill 的工程化

如果Skill 变得很复杂(比如包含多个文件、配置文件、甚至前端界面),你可以参考以下结构:

my-mcp-skill/

├── main.py # 入口文件 (启动 Server)

├── skills/ # 技能包

│ ├── __init__.py

│ ├── weather.py # 天气技能模块

│ ├── light.py # 灯光技能模块

│ └── database.py # 数据库查询技能

├── config.py # 配置文件 (API Keys)

├── pyproject.toml # 打包配置

└── README.md

总结

开发一个 MCP Skill 的本质就是:

- 写函数:想让 AI 做的事情写成 Python 函数。

- 写注释:告诉 AI 这个函数是干什么的、什么时候用。

- 加装饰器:加上

@mcp.tool(),把它暴露给 AI。 - 跑起来:配置好客户端,让 AI 来调用它。

mcp

MCP(Model Context Protocol,模型上下文协议)是由Anthropic公司于2024年11月推出的开放标准协议,旨在为AI模型与外部工具、数据源之间建立标准化、安全、高效的交互框架,彻底解决传统AI应用中“数据孤岛“和“工具碎片化“的痛点问题。

一、MCP的核心定位与价值

MCP本质上是AI领域的“USB-C接口标准“,它让AI应用能够像使用通用电源插头一样,轻松连接各种外部系统,无需为每个工具单独开发适配代码。在MCP出现前,AI与外部数据的连接如同“拼布娃娃“般杂乱无章:

- 硬编码逻辑:每个工具需单独适配

- Prompt链脆弱:依赖特定提示词组合

- 厂商锁定:不同平台需重复开发插件

这导致了臭名昭著的M×N集成问题:假设有M个AI应用和N个工具,理论上需开发M×N种定制化集成方案。而MCP通过引入标准中间层,将开发成本从M×N降至M+N,效率提升高达90%以上。

二、MCP的架构设计与核心组件

MCP采用客户端-服务器架构,包含四个关键角色:

-

MCP Host(宿主):运行AI模型的宿主环境,如Claude Desktop、Cursor IDE或Windsurf Editor等应用

-

MCP Client(客户端):内置于Host中的通信模块,负责与MCP Server建立连接、发送请求并处理响应,是主机端与服务器之间的“通信中介“

-

MCP Server(服务器):轻量级服务端程序,提供具体功能的服务端程序,如GitHub MCP Server、Slack MCP Server、本地文件系统Server等

-

Resources/Tools(资源/工具):实际被访问的数据或服务,如Git仓库、Gmail邮箱、本地数据库等

三、MCP的三大核心能力

MCP Server提供三类标准化能力,让AI模型能够安全、高效地与外部世界交互:

-

Tools(工具):可执行函数,用于执行特定任务

- 示例:数据库查询工具、邮件发送工具、API调用工具

- 特点:通常由AI模型选择触发,涉及文件I/O或网络调用等副作用

-

Resources(资源):只读数据源,供模型读取上下文

- 示例:本地文件、API响应内容、数据库记录

- 特点:为模型提供丰富的上下文信息,增强模型理解能力

-

Prompts(提示):预定义的对话模板

- 示例:生成SQL语句的模板、报告格式规范

- 特点:引导LLM完成特定任务,标准化输入输出

四、MCP的通信机制与技术实现

MCP基于JSON-RPC 2.0协议实现通信,支持两种主要传输方式:

-

本地通信:通过**stdio(标准输入/输出)**传输消息

- 适用场景:本地工具调用(如文件系统、本地数据库)

- 特点:轻量、同步、子进程通信

-

远程通信:基于**SSE(Server-Sent Events)**的HTTP长连接

- 适用场景:远程服务(如Slack、GitHub API)

- 特点:异步、事件驱动、支持长连接

消息格式示例:

{

"method": "call_tool",

"params": {

"tool_name": "sql_query",

"args": {

"query": "SELECT * FROM users"

}

}

}

五、MCP的核心优势

-

简化开发:开发者无需适配各种私有协议,只需连接MCP Server即可

-

提高扩展性:AI应用可通过随时“插拔“新的MCP Server来扩展功能

-

促进生态共享:通过MCP Server的共享,新的AI应用可快速获得各种工具

-

安全可控:敏感操作需用户显式授权,API密钥等凭证由MCP服务器本地管理

-

动态发现:AI可实时发现并集成新工具,无需预定义代码

六、MCP与传统API/Function Calling的对比

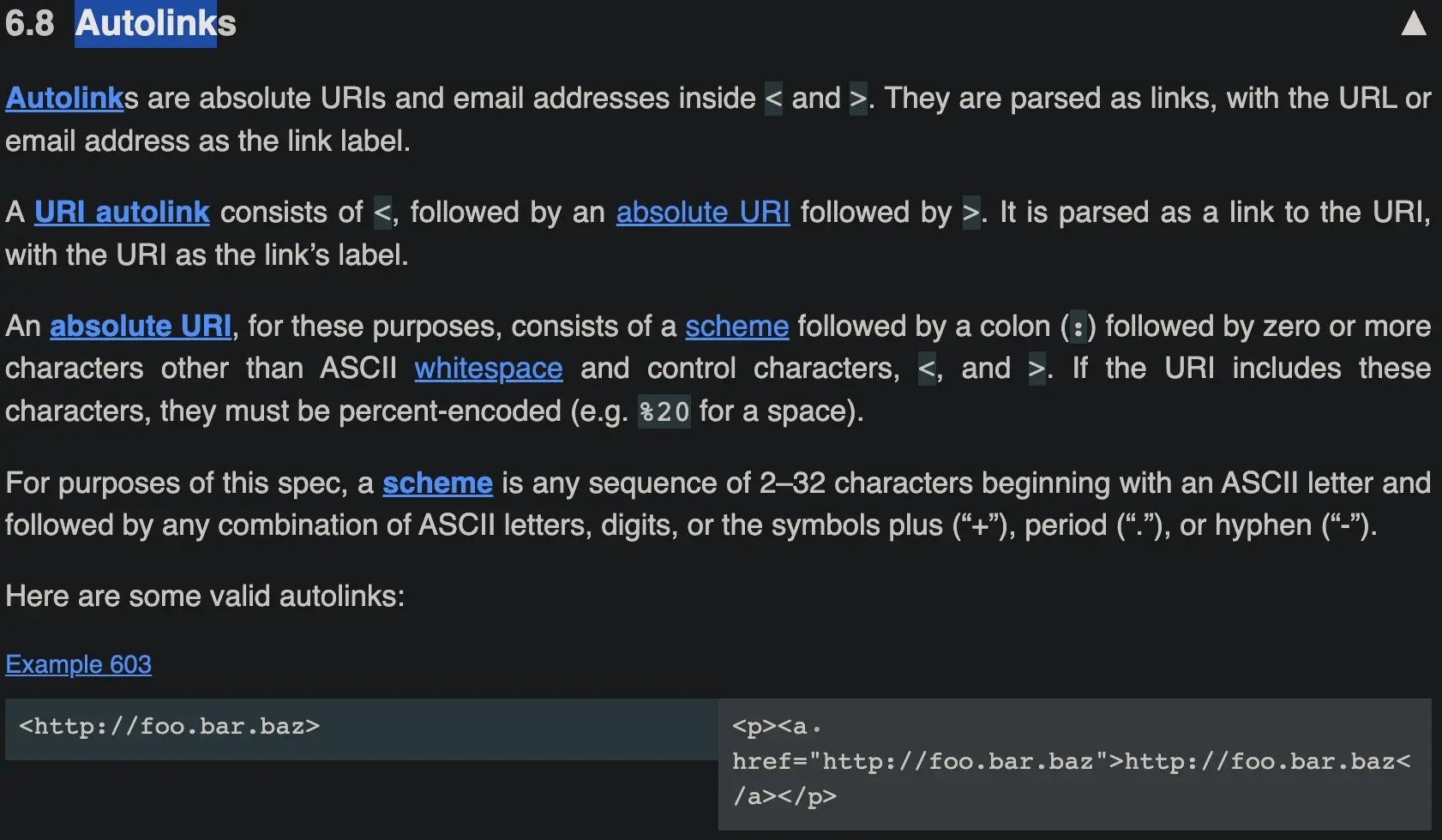

| 对比维度 | 传统API/Function Calling | MCP |

|---|---|---|

| 协议标准 | 私有协议(各模型自定规则) | 开放协议(JSON-RPC 2.0) |

| 工具发现 | 静态预定义 | 动态获取(initialize请求) |

| 调用方式 | 同进程函数或API | STDIO/SSE/同进程 |

| 扩展成本 | 高(新增工具需重新调试模型) | 低(工具热插拔,模型无需改动) |

| 适用场景 | 简单任务(单次函数调用) | 复杂流程(多工具协同+数据交互) |

| 生态协作 | 工具与大模型强绑定 | 工具开发者与Agent开发者解耦 |

七、MCP的典型应用场景

-

数据库直连:MCP最革命性的应用场景之一

- 传统RAG依赖向量检索,存在精度低、切片局部性强等问题

- MCP通过结构化查询能力,实现自然语言转SQL,显著提升答案可靠性

- 示例:用户提问“商品表中价格最高的车型是什么?“,MCP自动生成并执行SQL查询

-

智能客服系统:

- 集成CRM系统与订单数据库,自动处理工单

- 效率提升3倍,错误率下降70%

-

自动化运维:

- 通过MCP连接监控系统,自动发现并修复异常

- 某车企实践显示,设备故障预测准确率提升至92%,停机时间减少65%

-

多Agent协作:

- 在复杂任务中,多个Agent通过MCP协同工作

- 例如:财务分析师调取实时市场数据进行公司估值

八、MCP的安全机制

MCP内置多层次安全机制,确保数据交互安全:

-

权限控制:敏感操作(如删除文件、发送消息)需用户显式授权

-

凭证管理:API密钥等凭证由MCP服务器本地管理,不暴露给LLM或Host

-

运行模式区分:

- 本地模式:MCP Client和Server位于同一安全域,无授权但作用范围受限

- 远程模式:需授权,应遵循OAuth规范

-

操作透明化:所有请求以JSON-RPC格式记录,关键步骤需人工授权

九、MCP的未来发展趋势

-

多模态扩展:向图像、音频领域延伸,支持医疗影像分析、实时语音交互

-

行业标准化:有望成为AI与物理世界交互的事实标准(如车联网V2X、智能家居)

-

开源生态壮大:GitHub已有超1500个MCP Server,覆盖支付、设计、运维等领域

-

远程连接支持:MCP项目组正在积极推进Remote MCP Connections的实现,拓展应用范围

十、MCP与SKILL的协同关系

MCP与SKILL是AI智能体能力扩展的“左膀右臂“:

- MCP:提供“访问外部资源“的通道,解决“触达“问题

- SKILL:提供“如何执行任务“的方法论,解决“使用“问题

例如,在财务分析场景中:

- MCP连接标普资本智商(S&P Capital IQ)获取实时数据

- SKILL应用估值模型并格式化输出结果

这种“SKILLS定义流程+MCP连接资源“的协同模式,让AI从“能理解“真正走向“会执行“,成为构建专业级AI智能体的核心架构。

MCP协议正在重塑AI与物理世界的连接方式,如同给“AI武将“配备神兵利器,让开发者能够将非技术人员直接操作数据库、将复杂查询响应时间从小时级压缩至秒级、将运维成本降低50%以上。掌握这一技术的开发者,将率先登上AI 2.0时代的浪潮之巅。

最简单的mcp server

from mcp.server.fastmcp import FastMCP

from mcp.types import TextContent

# 1. 初始化服务器

# -------------------------

# 给你的服务器起个名字,这个名字会显示在客户端里

mcp = FastMCP("Reverse Text Server")

# 2. 定义工具 (Tool)

# -------------------------

# 使用 @mcp.tool() 装饰器来注册一个工具

# AI 会读取函数的注释来决定什么时候调用它

@mcp.tool()

def reverse_text(input_text: str) -> TextContent:

"""

将输入的字符串字符顺序完全反转。

例如:输入 "abc",输出 "cba"。

"""

reversed_str = input_text[::-1] # 核心逻辑:反转字符串

return TextContent(type="text", text=reversed_str)

# 3. 运行服务器

# -------------------------

# 这是程序的入口点

if __name__ == "__main__":

# 使用标准输入输出(STDIO)进行通信

# 这是最简单的模式,适合本地调试

mcp.run(transport='stdio')

lstm

在人工神经网络中,理解LSTM单元(尤其是神经元和记忆细胞之间的关系)需要明确几个层级的概念

-

核心构建单元:LSTM单元/模块

- LSTM网络的基本构建块称为一个 LSTM单元 或 LSTM模块。

- 这个单元负责处理一个时间步的输入,并产生该时间步的输出和传递给下一个时间步的隐藏状态。

- 一个LSTM单元整体可以被视为LSTM网络中的一个“神经元节点”, 与传统神经网络中的神经元节点相对应。它接收输入(当前输入

x_t和上一个隐藏状态h_{t-1}),经过内部复杂的计算,产生输出(当前隐藏状态h_t和可选的本层输出y_t)。

-

LSTM单元的内部结构:记忆细胞与门控机制 一个LSTM单元内部包含几个关键组件,共同协作以实现其长短期记忆能力:

-

记忆细胞:

- 这是LSTM单元最核心的部分,负责存储和传递长期的时序信息。

- 可以把它想象成一个“传送带”或“笔记本”,其状态

C_t在时间步之间相对稳定地传递下去。 C_t的值在时间步之间主要通过线性操作(加法)更新,这大大减轻了梯度消失问题,使得网络能够学习跨越长时间步的依赖关系。- 作用: 它是LSTM能够记住长期信息的物理载体。

-

门控机制:

- LSTM单元包含三个关键的门,它们都是向量(每个元素在0到1之间),控制信息如何流入、保留和流出记忆细胞。每个门本身由一个小型神经网络(通常是Sigmoid激活函数)实现:

- 遗忘门: 决定从上一个记忆细胞状态

C_{t-1}中丢弃哪些信息。输出f_t。 - 输入门: 决定当前候选值

\tilde{C}_t中的哪些新信息将被写入记忆细胞。输出i_t。 - 输出门: 决定基于当前更新后的记忆细胞状态

C_t,输出哪些信息到隐藏状态h_t。输出o_t。

- 遗忘门: 决定从上一个记忆细胞状态

- 作用: 门是调控信息流的开关。它们学习在何时、让多少信息通过,从而保护记忆细胞免受无关信息的干扰,并控制何时将记忆细胞中的信息读出来影响当前输出。

- LSTM单元包含三个关键的门,它们都是向量(每个元素在0到1之间),控制信息如何流入、保留和流出记忆细胞。每个门本身由一个小型神经网络(通常是Sigmoid激活函数)实现:

-

候选记忆细胞值:

- 一个临时的、基于当前输入

x_t和前一个隐藏状态h_{t-1}计算出的新值\tilde{C}_t(通常使用Tanh激活函数)。 - 作用: 它代表了在当前时间步,网络考虑要写入记忆细胞的新信息。输入门最终决定这些候选值中有多少实际被写入。

- 一个临时的、基于当前输入

-

隐藏状态:

- 这是LSTM单元对外的输出之一(

h_t),通常也作为单元自身的状态传递给下一个时间步。 - 它是由输出门

o_t对当前记忆细胞状态C_t(经过Tanh缩放)进行门控得到的:h_t = o_t * tanh(C_t)。 - 作用:

h_t包含了LSTM单元基于当前输入、之前所有历史和当前记忆状态选择要输出的信息。它是下游计算(如预测、传递给下一层)的主要依据。

- 这是LSTM单元对外的输出之一(

-

-

神经元、记忆细胞与LSTM单元的关系:一个清晰的总结

-

层级1:整个LSTM层

- 由多个 LSTM单元/模块 并行组成(类似于一层中有多个神经元)。

- 每个单元处理输入序列中的一个特征维度(或向量元素),并维护自己独立的记忆细胞和门控状态。

-

层级2:单个LSTM单元

- 这是LSTM网络中的基本计算节点,可被视为一个“超级神经元”。

- 它内部包含:

- 一个核心的记忆细胞:用于长期信息存储。

- 三个门控结构:用于调节信息流。

- 一个候选值生成器。

- 一个隐藏状态生成器。

- 记忆细胞是这个“超级神经元”(LSTM单元)内部的一个关键组成部分,专门负责记忆功能。 它不是独立的神经元,而是构成LSTM单元核心功能的元件之一。

-

-

关键区别:传统神经元 vs. LSTM单元 vs. 记忆细胞

概念 描述 与传统神经元类比 在LSTM层级中的位置 传统神经元 接收输入加权和,通过激活函数非线性变换,产生单个输出。 基本单位 N/A LSTM单元 一个复杂的处理单元,包含记忆细胞、门控机制等组件。处理序列数据。 ≈ 一个超级神经元 网络层的基本构建节点 记忆细胞 LSTM单元内部的核心组件,负责存储和传递长期状态 ( C_t)。不是独立的神经元 LSTM单元内部的关键子组件 门控结构 LSTM单元内部的组件(遗忘门、输入门、输出门),由小型神经网络实现。 不是独立的神经元 LSTM单元内部的关键子组件 隐藏状态 LSTM单元的输出 ( h_t),基于记忆细胞和输出门计算得到。≈ 神经元的输出 LSTM单元的输出/状态 -

形象比喻

- 想象一个决策室(LSTM单元)。

- 房间里有一个核心记事板(记忆细胞

C_t),上面记录着长期重要的信息。 - 有三个审查员(门控机制):

- 一个负责擦除记事板上过时或无关的信息(遗忘门

f_t)。 - 一个负责审核新收到的信息草稿(候选值

\tilde{C}_t),决定哪些值得写到记事板上(输入门i_t)。 - 一个负责决定记事板上的哪些信息可以对外公布(输出门

o_t)。

- 一个负责擦除记事板上过时或无关的信息(遗忘门

- 新信息草稿(候选值

\tilde{C}_t)由另一个助手基于当前收到的消息和之前公布的摘要草拟。 - 最终对外发布的摘要(隐藏状态

h_t)是审查员(输出门)允许公布的、来自记事板(记忆细胞)的部分信息。

结论:

在LSTM网络中:

- 基本功能节点是LSTM单元。 一个LSTM单元整体上扮演着类似传统神经网络中一个“神经元”的角色。

- 记忆细胞是LSTM单元内部的核心组件。 它不是独立的神经元,而是构成LSTM单元实现其核心功能(长时记忆)的关键部分。它存储着跨越时间步的状态

C_t。 - 门控结构也是LSTM单元内部的组件。 它们同样不是独立的神经元,而是由小型神经网络实现的调控机制,负责学习如何保护、更新和读取记忆细胞中的信息。

- 隐藏状态

h_t是LSTM单元的主要输出。 它代表了单元在当前时间步根据输入和历史“选择”要传递出去的信息。

因此,简单地说:记忆细胞是LSTM单元(这个“超级神经元”)内部专门负责存储长期信息的关键部件。 没有记忆细胞,LSTM就失去了其解决长期依赖问题的核心能力;没有门控机制,记忆细胞就无法被有效保护和管理;没有LSTM单元这个整体结构,这些组件就无法协同工作处理序列数据。

在人工神经网络中,LSTM(长短期记忆网络)、神经元和记忆细胞的关系可以通过以下层次结构理解:

1. 神经元(Neuron)

- 基础单元:神经元是神经网络的基本计算单元,模拟生物神经元的行为。

- 功能:接收输入信号,通过加权求和和非线性激活函数(如Sigmoid、ReLU)产生输出。

- 传统RNN中的神经元:在简单循环神经网络(RNN)中,神经元通过循环连接传递隐藏状态,但长期依赖问题限制了其记忆能力。

2. LSTM:对神经元的改进

- LSTM单元:LSTM是一种特殊的RNN架构,其核心是LSTM单元(可视为一种“增强型神经元”)。

- 解决长期依赖问题:传统RNN神经元在反向传播时梯度易消失或爆炸,LSTM通过引入门控机制和记忆细胞(Memory Cell)解决这一问题。

3. 记忆细胞(Memory Cell)

- 核心组件:记忆细胞是LSTM单元的核心,负责存储长期状态信息。

- 状态更新:通过三个门控机制(输入门、遗忘门、输出门)动态调整记忆内容:

- 遗忘门:决定保留多少历史信息(控制记忆细胞的“遗忘”)。

- 输入门:决定新信息是否加入记忆细胞(控制信息的“写入”)。

- 输出门:决定记忆细胞对当前输出的影响(控制信息的“读取”)。

- 状态传递:记忆细胞的状态((c_t))在时间步间传递,形成长期依赖的“记忆链”。

三者关系总结

-

LSTM单元 = 神经元 + 记忆细胞 + 门控机制

LSTM通过改造传统神经元结构,将记忆细胞和门控逻辑嵌入其中,使其具备长期记忆能力。 -

记忆细胞是LSTM神经元的“长期记忆载体”

传统神经元的隐藏状态((h_t))仅短期传递,而LSTM的记忆细胞((c_t))通过门控机制实现长期状态保持。 -

门控机制由神经网络实现

输入门、遗忘门、输出门本身是神经网络层(如Sigmoid函数),其权重通过训练学习何时保留或遗忘信息。

类比理解

-

传统RNN神经元:像一张便签纸,每次覆盖写入新内容(短期记忆)。

-

LSTM单元:像一个带锁的保险箱,记忆细胞是保险箱内的“核心文档”,门控机制是三把钥匙:

- 遗忘门(删除旧内容)

- 输入门(添加新内容)

- 输出门(决定是否展示内容)

通过这种设计,LSTM在处理序列数据(如语言、时间序列)时,能够更有效地捕捉长期依赖关系。

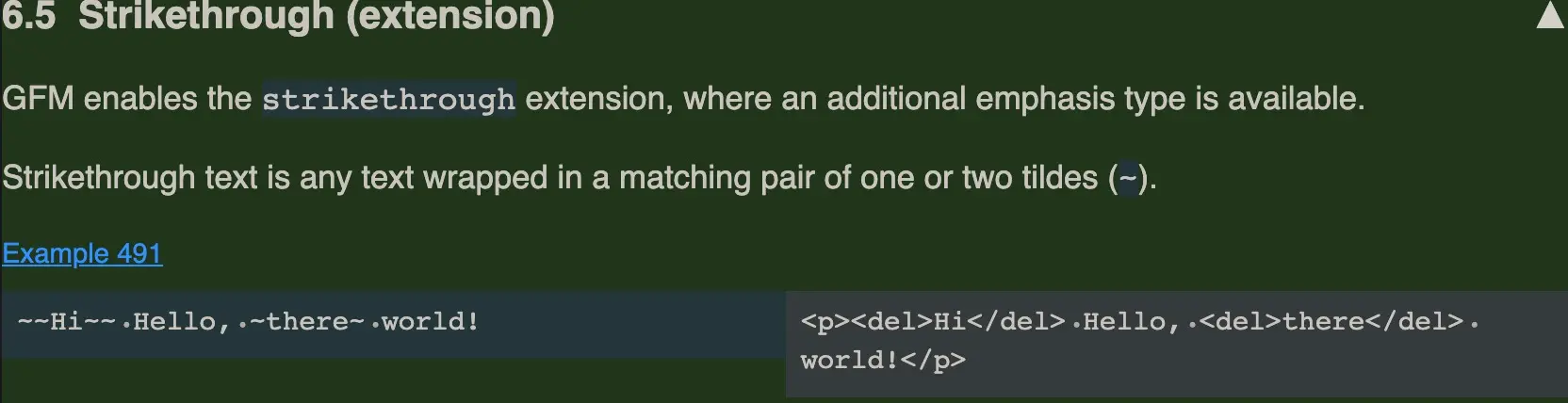

conv2d

在卷积神经网络(CNN)中,图像通道数是一个关键概念,它决定了卷积层如何处理输入数据。以下是关于通道数在卷积层中处理方式的详细解释:

1. 图像通道的基本概念

- 通道数:表示图像中每个像素的组成维度。

- 常见场景:

- 灰度图像:单通道(通道数=1),每个像素是一个0-255的数值。

- 彩色图像:三通道(通道数=3),每个像素由RGB三个值表示。

- 多光谱图像:可能有更多通道(如卫星图像的10+通道)。

2. 卷积层如何处理多通道输入?

卷积层通过以下步骤处理多通道输入:

步骤1:每个卷积核包含多个通道

- 对于输入图像的每个通道,卷积核都有一个对应的子核。

- 例如:输入为3通道图像,卷积核大小为3×3,则每个卷积核实际包含 3个3×3的子核,总尺寸为 3×3×3。

步骤2:各通道并行卷积后求和

- 每个子核对对应通道进行卷积运算,生成中间特征图。

- 将所有中间特征图逐元素相加,得到一个单通道的输出特征图。

步骤3:多个卷积核生成多个输出通道

- 卷积层中的每个卷积核独立执行上述操作,最终生成的输出通道数等于卷积核的数量。

示例:

输入:32×32×3的RGB图像

卷积层参数:filters=16, kernel_size=(3,3)

处理过程:

- 每个卷积核尺寸为 3×3×3(3个子核,对应3个输入通道)。

- 每个卷积核生成1个单通道的特征图。

- 16个卷积核共生成 16个通道 的输出特征图,尺寸为30×30×16(假设padding=“valid”)。

3. 数学表达式与计算示例

对于输入图像 $X \in \mathbb{R}^{H \times W \times C_{\text{in}}}$ 和卷积核 $K \in \mathbb{R}^{k \times k \times C_{\text{in}}}$,输出特征图 $Y \in \mathbb{R}^{H’ \times W’}$ 的计算过程为:

$$ Y_{i,j} = \sum_{c=1}^{C_{\text{in}}} \sum_{m=1}^{k} \sum_{n=1}^{k} K_{m,n,c} \cdot X_{i+m,j+n,c} + b $$

其中:

- $Y_{i,j}$ 是输出特征图的第 $(i,j)$ 个位置的值。

- $K_{m,n,c}$ 是卷积核在第 $c$ 个通道的 $(m,n)$ 位置的值。

- $b$ 是偏置项。

计算示例:

输入通道数 $C_{\text{in}}=3$,卷积核大小 $k=3$,输出通道数 $C_{\text{out}}=16$,则:

- 每个卷积核的参数数量:$3 \times 3 \times 3 + 1 = 28$(+1为偏置)。

- 整个卷积层的参数数量:$28 \times 16 = 448$。

4. Keras代码示例

from tensorflow.keras import layers, models

# 输入:32×32×3的RGB图像

model = models.Sequential()

model.add(layers.Conv2D(

filters=16, # 16个卷积核 → 输出16个通道

kernel_size=(3, 3), # 卷积核大小3×3

activation='relu',

input_shape=(32, 32, 3) # 输入通道数=3

))

# 查看模型结构

model.summary()

输出分析:

Layer (type) Output Shape Param #

=================================================================

conv2d (Conv2D) (None, 30, 30, 16) 448

=================================================================

- 输出形状

(30, 30, 16):每个卷积核生成30×30的特征图,16个卷积核共16个通道。 - 参数数量448:由 $(3 \times 3 \times 3 + 1) \times 16$ 计算得出。

5. 关键要点总结

-

卷积核深度 = 输入通道数:

每个卷积核必须包含与输入通道数相同的子核,以处理多通道数据。 -

输出通道数 = 卷积核数量:

卷积层通过多个卷积核提取不同特征,输出通道数由filters参数决定。 -

通道间信息融合:

通过对各通道的卷积结果求和,卷积层隐式融合了不同通道的信息(例如RGB通道的颜色与纹理特征)。 -

参数效率:

相比全连接层,卷积层通过参数共享大幅减少参数量,适合处理高维图像数据。

常见问题解答

(1) 输入通道数与输出通道数有什么关系?

- 输入通道数决定每个卷积核的深度(子核数量)。

- 输出通道数由卷积核数量独立控制,与输入通道数无关。

(2) 如何处理单通道图像(如灰度图)?

- 输入通道数设为1,卷积核尺寸为 $k \times k \times 1$。

- 例如:

input_shape=(28, 28, 1),卷积核参数为kernel_size=(3, 3)。

(3) 通道数与特征表达能力的关系?

- 更多输出通道(卷积核)可以提取更丰富的特征,但会增加计算量和过拟合风险。

- 通常随着网络加深,通道数逐渐增加(如从32→64→128),以捕获更抽象的特征。

在Keras(TensorFlow的高级API)里,Conv2D 是二维卷积层,主要用于处理具有网格结构的输入数据,像图像数据就是常见的应用场景。它借助卷积操作来提取输入数据的特征,在计算机视觉领域应用十分广泛。下面为你详细剖析 Conv2D 的核心参数和工作机制:

核心参数解读

keras.layers.Conv2D(

filters, # 卷积核数量,决定输出特征图的通道数

kernel_size, # 卷积核大小,例如(3, 3)或5

strides=(1, 1), # 卷积步长

padding="valid", # 填充方式,"valid"(不填充)或"same"(填充使输出尺寸与输入相同)

data_format=None, # 数据格式,"channels_last"(默认)或"channels_first"

dilation_rate=(1, 1), # 空洞卷积扩张率

activation=None, # 激活函数,如"relu"

use_bias=True, # 是否使用偏置项

kernel_initializer="glorot_uniform", # 卷积核权重初始化方法

bias_initializer="zeros", # 偏置项初始化方法

kernel_regularizer=None, # 卷积核权重正则化

bias_regularizer=None, # 偏置项正则化

activity_regularizer=None,# 输出的正则化函数

kernel_constraint=None, # 对卷积核权重的约束

bias_constraint=None # 对偏置项的约束

)

工作机制详解

- 卷积操作: 卷积核在输入数据上进行滑动,对每个局部区域进行逐元素相乘再求和的运算,从而生成特征图。每一个卷积核都会提取一种特定的特征。

- 参数共享: 同一个卷积核在整个输入数据上应用,这使得模型具有平移不变性,同时也大大减少了模型的参数量。

- 多通道处理: 如果输入数据具有多个通道(例如RGB图像有3个通道),卷积核会对所有通道的局部区域进行卷积操作,然后将结果相加。

输出尺寸计算

输出特征图的尺寸由以下因素决定:

- 输入尺寸:

(H, W, C) - 卷积核大小:

(kh, kw) - 步长:

(sh, sw) - 填充方式:

padding

计算公式如下:

H_out = (H + 2*pad_h - kh) // sh + 1

W_out = (W + 2*pad_w - kw) // sw + 1

- 当

padding="same"时,会自动计算填充值,使得输出尺寸与输入尺寸相同。 - 当

padding="valid"时,不进行填充,可能会导致输出尺寸小于输入尺寸。

典型应用场景

- 图像分类:例如在VGG、ResNet等网络中。

- 目标检测:如Faster R-CNN、YOLO等模型会用到。

- 语义分割:像U-Net、DeepLab等网络。

- 特征提取:用于提取图像的纹理、边缘等特征。

示例代码

下面是一个简单的使用 Conv2D 构建小型卷积神经网络的示例:

from tensorflow.keras import layers, models

model = models.Sequential()

# 添加一个卷积层,32个卷积核,每个卷积核大小为3x3,使用ReLU激活函数

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)))

# 添加最大池化层,池化窗口大小为2x2

model.add(layers.MaxPooling2D((2, 2)))

# 再添加一个卷积层,64个卷积核,每个卷积核大小为3x3,使用ReLU激活函数

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

# 添加最大池化层,池化窗口大小为2x2

model.add(layers.MaxPooling2D((2, 2)))

# 再添加一个卷积层,64个卷积核,每个卷积核大小为3x3,使用ReLU激活函数

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

# 将多维数据展平为一维向量

model.add(layers.Flatten())

# 添加全连接层,64个神经元,使用ReLU激活函数

model.add(layers.Dense(64, activation='relu'))

# 添加输出层,10个神经元,使用softmax激活函数,用于多分类问题

model.add(layers.Dense(10, activation='softmax'))

# 打印模型结构

model.summary()

注意要点

- 数据格式:

- 在TensorFlow中,默认的数据格式是

channels_last,即输入数据的形状为(batch_size, height, width, channels)。 - 若要使用

channels_first格式,输入数据的形状则为(batch_size, channels, height, width),并且需要在模型中进行相应设置。

- 在TensorFlow中,默认的数据格式是

- 卷积核大小:

- 常用的卷积核大小有3×3、5×5等,其中3×3的卷积核最为常用,因为它既能捕获局部特征,又能减少参数量。

- 激活函数:

- 在卷积层之后,通常会使用ReLU激活函数来引入非线性特性,这样可以增强模型的表达能力。

通过合理调整 Conv2D 的参数,你能够构建出适用于不同任务的高性能卷积神经网络。

dense

在Keras中,Dense 层(全连接层)是神经网络的基础组件,用于实现神经元之间的全连接。每个神经元接收上一层所有神经元的输出作为输入,并通过加权求和与激活函数产生输出。这种层广泛应用于各类深度学习模型,尤其是在模型的分类或回归部分。

核心参数解析

keras.layers.Dense(

units, # 神经元数量,决定输出维度

activation=None, # 激活函数,如"relu"、"softmax"

use_bias=True, # 是否使用偏置项

kernel_initializer="glorot_uniform", # 权重初始化方法

bias_initializer="zeros", # 偏置初始化方法

kernel_regularizer=None, # 权重正则化

bias_regularizer=None, # 偏置正则化

activity_regularizer=None,# 输出的正则化函数

kernel_constraint=None, # 对权重的约束

bias_constraint=None # 对偏置的约束

)

工作机制详解

-

线性变换: 对于输入

x,Dense层执行线性变换y = W·x + b,其中:W是权重矩阵(形状为(input_dim, units))b是偏置向量(形状为(units,))·表示矩阵乘法

-

激活函数: 线性变换后可应用激活函数引入非线性:

y = activation(W·x + b)常用激活函数包括:

relu:修正线性单元,max(0, x)sigmoid:将输出压缩到[0, 1]softmax:多分类问题中常用,输出概率分布

-

参数量计算: 总参数量 =

(输入维度 × 输出维度) + 输出维度(偏置项)

典型应用场景

- 图像分类:在卷积神经网络的末尾,将特征图展平后连接多个

Dense层进行分类。 - 回归分析:直接预测连续值,如房价预测。

- 特征组合:对高维特征进行非线性变换,提取更抽象的表示。

示例代码

以下是 Dense 层在不同场景的典型用法:

1. 简单神经网络(MNIST分类)

from tensorflow.keras import layers, models

model = models.Sequential()

model.add(layers.Flatten(input_shape=(28, 28))) # 将28×28图像展平为784维向量

model.add(layers.Dense(128, activation='relu')) # 128个神经元的隐藏层

model.add(layers.Dropout(0.2)) # 防止过拟合

model.add(layers.Dense(10, activation='softmax')) # 10个类别的输出层

model.summary()

2. 多层感知机(MLP)回归

from tensorflow.keras import layers, models

model = models.Sequential()

model.add(layers.Dense(64, activation='relu', input_dim=100)) # 输入维度为100

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(1)) # 无激活函数,用于回归问题

model.compile(optimizer='adam', loss='mse')

3. 与卷积层结合(CIFAR-10分类)

from tensorflow.keras import layers, models

model = models.Sequential()

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Flatten())

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(10, activation='softmax')) # 10个类别

注意要点

-

输入形状:

- 输入应为二维张量

(batch_size, input_dim) - 若输入为多维数据(如卷积层输出),需先通过

Flatten或GlobalAveragePooling2D进行展平

- 输入应为二维张量

-

激活函数选择:

- 二分类问题:输出层使用

Dense(1, activation='sigmoid') - 多分类问题:输出层使用

Dense(n_classes, activation='softmax') - 回归问题:输出层不使用激活函数或使用

linear

- 二分类问题:输出层使用

-

防止过拟合:

- 可在

Dense层后添加Dropout层 - 使用正则化参数(如

kernel_regularizer='l2')

- 可在

-

初始化策略:

- ReLU激活函数:推荐使用

he_normal初始化 - Sigmoid/tanh激活函数:推荐使用

glorot_uniform(默认)

- ReLU激活函数:推荐使用

通过合理设计 Dense 层的结构和参数,你可以构建出适用于不同任务的神经网络模型。

在Keras中,Dense层(全连接层)和Conv2D层(二维卷积层)是两种核心层类型,分别适用于不同的数据结构和任务场景。以下是它们的主要区别:

1. 连接方式与参数共享

| Dense层 | Conv2D层 |

|---|---|

| 全连接:每个输出神经元与所有输入神经元相连 | 局部连接:每个输出神经元仅与输入的局部区域相连 |

| 无参数共享:每个连接有独立的权重参数 | 参数共享:同一卷积核在整个输入上滑动使用 |

参数量 = 输入维度 × 输出维度 + 输出维度 | 参数量 = 卷积核大小 × 输入通道数 × 输出通道数 + 输出通道数 |

示例:

- 输入为28×28图像(784维),Dense层输出128维:参数量 = 784×128+128 = 100,480

- 输入为32×32×3图像,Conv2D使用3×3卷积核、32个输出通道:参数量 = 3×3×3×32+32 = 896

2. 数据结构与空间关系

| Dense层 | Conv2D层 |

|---|---|

| 输入/输出均为一维向量(忽略数据的空间结构) | 输入/输出为多维张量(保留空间结构,如H×W×C) |

| 适用于无空间关系的数据(如文本、表格) | 适用于有网格结构的数据(如图像、音频) |

| 对输入的空间位置敏感(位置变化会影响结果) | 具有平移不变性(同一特征可在不同位置被检测) |

3. 特征提取能力

| Dense层 | Conv2D层 |

|---|---|

| 通过全连接捕获全局特征关系 | 通过局部卷积捕获局部模式(如边缘、纹理) |

| 需手动设计特征工程(如展平图像) | 自动学习层次化特征(从低级到高级) |

| 易过拟合(参数量大) | 抗过拟合能力强(参数共享+局部连接) |

4. 典型应用场景

| Dense层 | Conv2D层 |

|---|---|

| 分类器(如Softmax层) | 特征提取(如图像卷积网络) |

| 回归任务 | 图像/视频处理 |

| 模型的最后几层(整合全局信息) | 模型的前几层(提取局部特征) |

5. 代码对比

Dense层示例

from tensorflow.keras import layers

model = Sequential()

model.add(layers.Flatten(input_shape=(28, 28))) # 展平图像为一维向量

model.add(layers.Dense(128, activation='relu')) # 全连接层

Conv2D层示例

from tensorflow.keras import layers

model = Sequential()

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1))) # 保留空间结构

6. 何时选择哪种层?

-

使用Dense层:

- 输入数据无明显空间结构(如文本、数值特征)。

- 需要整合全局信息(如分类前的特征融合)。

- 模型参数量可控(小数据集)。

-

使用Conv2D层:

- 处理图像、音频等网格结构数据。

- 需要提取局部特征或保持空间关系。

- 参数量需严格控制(大数据集、高分辨率输入)。

总结

| 维度 | Dense层 | Conv2D层 |

|---|---|---|

| 连接方式 | 全连接 | 局部连接+参数共享 |

| 数据结构 | 一维向量 | 多维张量(保留空间) |

| 特征类型 | 全局特征 | 局部特征 |

| 参数量 | 高(易过拟合) | 低(抗过拟合) |

| 典型场景 | 分类器、回归 | 图像/视频处理 |

在实际应用中,两者常结合使用(如CNN中先用Conv2D提取特征,再用Dense层分类)。

pool

在Keras中,MaxPooling2D 是一种二维最大池化层,常用于卷积神经网络(CNN)中对特征图进行下采样。它通过在局部区域内提取最大值来减少数据维度,同时保留重要特征。以下是对 MaxPooling2D 的详细介绍:

核心功能与作用

- 降维:减少特征图的空间尺寸(高度和宽度),降低计算复杂度。

- 特征提取:通过保留最大值,突出最显著的特征(如边缘、纹理)。

- 平移不变性:对输入的微小平移具有鲁棒性,增强模型的泛化能力。

- 防止过拟合:减少参数数量,降低模型对噪声的敏感性。

核心参数

keras.layers.MaxPooling2D(

pool_size=(2, 2), # 池化窗口大小,通常为(2, 2)

strides=None, # 步长,默认等于pool_size

padding="valid", # 填充方式,"valid"(不填充)或"same"(保持输入尺寸)

data_format=None # 数据格式,"channels_last"(默认)或"channels_first"

)

工作机制详解

-

池化窗口滑动:

池化窗口(如2×2)在输入特征图上按指定步长滑动,每次覆盖一个局部区域。 -

最大值提取:

对每个局部区域内的所有值取最大值,作为输出特征图的对应位置的值。 -

输出尺寸计算:

假设输入尺寸为(H, W, C),池化窗口为(p, q),步长为(s_h, s_w),则输出尺寸为:H_out = (H - p) // s_h + 1 W_out = (W - q) // s_w + 1当

padding="same"时,会自动填充使输出尺寸与输入相同。 -

通道数不变:

池化操作不改变特征图的通道数(C),仅对空间维度进行下采样。

典型应用场景

- 图像分类:在卷积层后使用,减少特征图尺寸,如VGG、ResNet。

- 目标检测:提取局部区域的显著特征,如YOLO、Faster R-CNN。

- 语义分割:通过下采样和上采样结合,捕获多尺度特征,如U-Net。

示例代码

1. 基本用法

from tensorflow.keras import layers, models

model = models.Sequential()

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)))

# 添加最大池化层,池化窗口2×2

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

# 再次下采样

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Flatten())

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(10, activation='softmax'))

model.summary()

2. 输出尺寸计算示例

# 输入:32×32×3的图像

# 第一个卷积层:32个3×3卷积核,padding="valid"

# 输出尺寸:(32-3)/1+1 = 30 → (30, 30, 32)

# 第一个池化层:2×2池化窗口,默认步长=2

# 输出尺寸:30/2 = 15 → (15, 15, 32)

# 第二个卷积层:64个3×3卷积核

# 输出尺寸:(15-3)/1+1 = 13 → (13, 13, 64)

# 第二个池化层:2×2池化窗口

# 输出尺寸:13//2 +1 = 7 → (7, 7, 64)

与其他池化方法的对比

| 池化类型 | 核心操作 | 特点与应用场景 |

|---|---|---|

| MaxPooling2D | 取局部区域最大值 | 保留显著特征,最常用 |

| AveragePooling2D | 取局部区域平均值 | 平滑特征,适用于强调整体信息的场景 |

| GlobalMaxPooling2D | 对每个通道全局取最大值 | 大幅降维,常用于分类任务 |

| GlobalAveragePooling2D | 对每个通道全局取平均 | 减少参数量,防止过拟合,如ResNet |

注意要点

-

数据格式:

- 默认

data_format="channels_last",输入形状为(batch_size, height, width, channels)。 - 若使用

channels_first,输入形状为(batch_size, channels, height, width)。

- 默认

-

步长与窗口大小:

- 步长通常设置为与池化窗口大小相同(如

strides=(2, 2)),避免重叠计算。

- 步长通常设置为与池化窗口大小相同(如

-

替代方案:

- 若需保留更多空间信息,可使用

Strided Convolution(卷积步长>1)替代池化。

- 若需保留更多空间信息,可使用

总结

MaxPooling2D 是CNN中不可或缺的组件,通过提取局部最大值实现特征选择和降维,在保持模型性能的同时显著减少计算量。合理使用池化层可以有效提升模型的泛化能力和训练效率。

在深度学习中,池化层(Pooling Layer) 是卷积神经网络(CNN)的关键组件,主要用于对特征图进行下采样(降维)。它通过在局部区域上执行聚合操作,减少数据量的同时保留重要特征。以下是其核心概念、作用和常见类型的详细解释:

1. 核心概念

池化层的工作原理是:

- 滑动窗口:在输入特征图上按固定步长滑动一个窗口(如2×2像素)。

- 聚合操作:对每个窗口内的所有值应用一个固定函数(如最大值、平均值),生成输出值。

- 降低维度:输出特征图的空间尺寸(高、宽)通常会减小,而通道数保持不变。

示例:

输入为4×4的特征图,使用2×2窗口和步长2进行最大池化:

输入特征图:

[

[1, 2, 3, 4],

[5, 6, 7, 8],

[9, 10, 11, 12],

[13, 14, 15, 16]

]

池化过程(2×2窗口):

[1, 2] → max=6 [3, 4] → max=8

[5, 6] [7, 8]

[9, 10] → max=14 [11, 12] → max=16

[13, 14] [15, 16]

输出特征图:

[

[6, 8],

[14, 16]

]

2. 主要作用

-

减少参数数量:

降低后续层的计算复杂度,例如:- 输入100×100×64的特征图,经2×2池化后变为50×50×64,参数减少75%。

-

提取显著特征:

通过保留最大值(或平均值),突出最重要的特征(如边缘、纹理)。 -

增强平移不变性:

对输入的微小位移不敏感,提高模型的鲁棒性。例如,图像中的物体位置稍有变化,池化后的特征保持不变。 -

防止过拟合:

减少模型对细节的依赖,泛化能力更强。

3. 常见池化类型

(1) 最大池化(Max Pooling)

-

操作:取窗口内的最大值。

-

特点:保留最显著特征,抑制噪声,最常用。

-

Keras实现:

from tensorflow.keras.layers import MaxPooling2D model.add(MaxPooling2D(pool_size=(2, 2), strides=2))

(2) 平均池化(Average Pooling)

-

操作:取窗口内的平均值。

-

特点:保留整体特征,避免局部极值影响,适用于强调背景信息的任务(如语义分割)。

-

Keras实现:

from tensorflow.keras.layers import AveragePooling2D model.add(AveragePooling2D(pool_size=(2, 2), strides=2))

(3) 全局池化(Global Pooling)

-

操作:对每个通道的全部值取最大值或平均值。

-

特点:将特征图压缩为一维向量,大幅减少参数量。常用于分类任务的最后一层。

-

Keras实现:

from tensorflow.keras.layers import GlobalMaxPooling2D, GlobalAveragePooling2D model.add(GlobalMaxPooling2D()) # 全局最大池化 model.add(GlobalAveragePooling2D()) # 全局平均池化

4. 参数与计算

(1) 核心参数

- 池化窗口大小(pool_size):通常为2×2或3×3。

- 步长(strides):窗口每次滑动的距离,默认等于窗口大小。

- 填充(padding):通常为“valid“(不填充),保持特征图边缘信息。

(2) 输出尺寸计算

假设输入尺寸为 H × W × C,池化窗口为 p × p,步长为 s,则输出尺寸为:

H_out = (H - p) // s + 1

W_out = (W - p) // s + 1

C_out = C # 通道数不变

例如:

- 输入:28×28×64

- 池化:2×2窗口,步长2

- 输出:14×14×64

5. 应用场景

- 图像分类:如VGG、ResNet中使用最大池化降维。

- 目标检测:如YOLO、Faster R-CNN中提取区域特征。

- 语义分割:结合上采样恢复空间分辨率,如U-Net。

- 语音处理:对音频特征图进行降维。

6. 与卷积层的对比

| 维度 | 卷积层(Conv2D) | 池化层(MaxPooling2D) |

|---|---|---|

| 参数 | 有可学习的权重和偏置 | 无参数,仅固定操作 |

| 特征提取 | 通过卷积核学习局部特征 | 提取/聚合已有特征 |

| 尺寸变化 | 可通过padding控制输出尺寸 | 通常缩小尺寸(如减半) |

| 非线性 | 需通过激活函数引入非线性 | 纯线性操作 |

| 作用 | 提取有意义的特征 | 降维、增强鲁棒性 |

7. 替代方案

- 步长卷积(Strided Convolution):通过卷积层的大步长(如strides=2)直接降维,替代池化层。

- 空洞卷积(Dilated Convolution):在不增加参数的情况下扩大感受野,保留更多细节。

总结

池化层通过下采样和特征聚合,在减少计算量的同时增强模型的鲁棒性,是CNN中不可或缺的组件。最大池化因其简单高效而被广泛使用,而平均池化和全局池化则适用于特定场景。合理设计池化策略是构建高性能深度学习模型的关键。

docker

官网

-

The easiest and recommended way to get Docker Compose is to install Docker Desktop. Docker Desktop includes Docker Compose along with Docker Engine and Docker CLI which are Compose prerequisites.

-

linux服务器单独安装docker,就需要单独安装docker-compose.

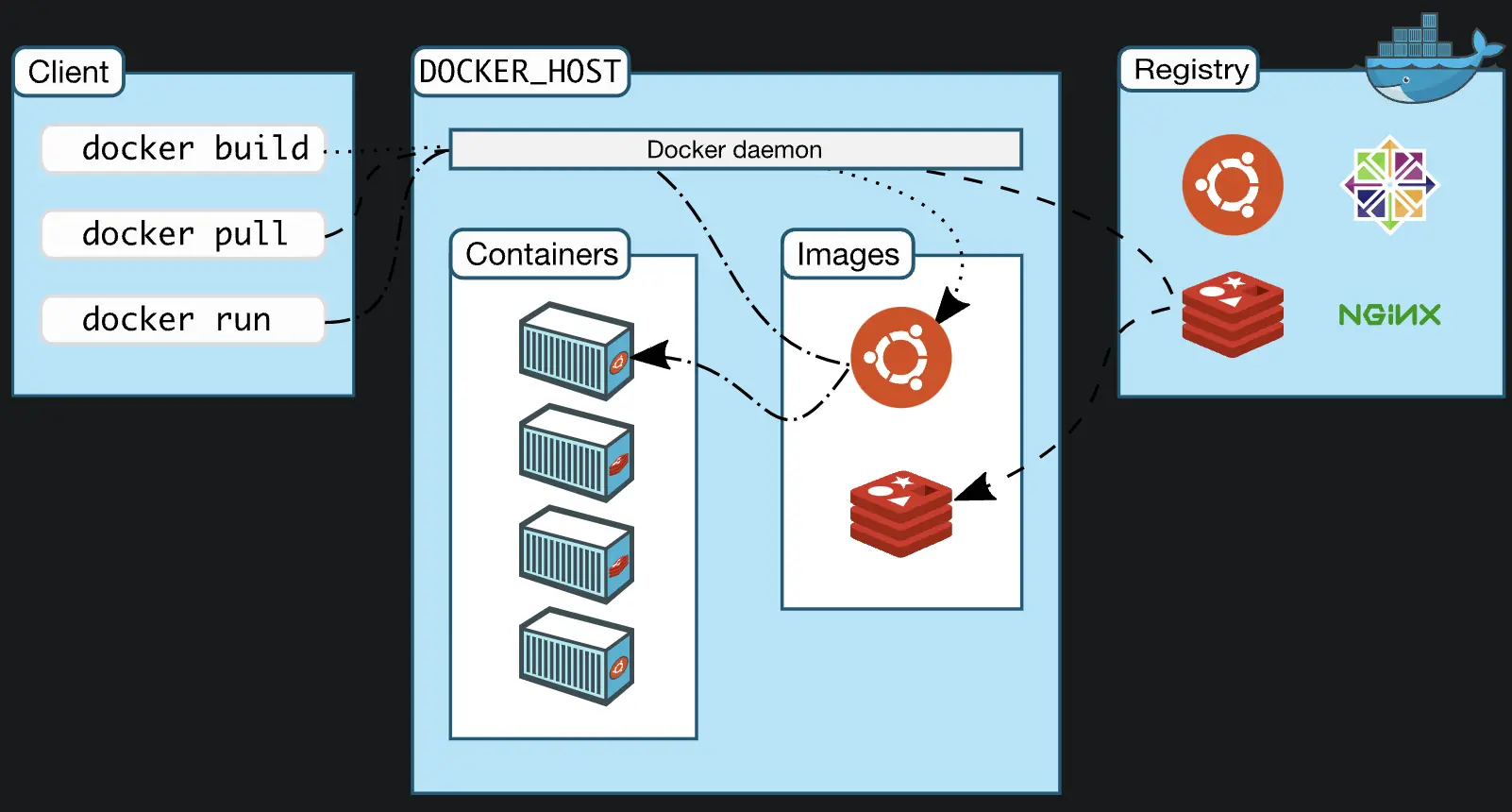

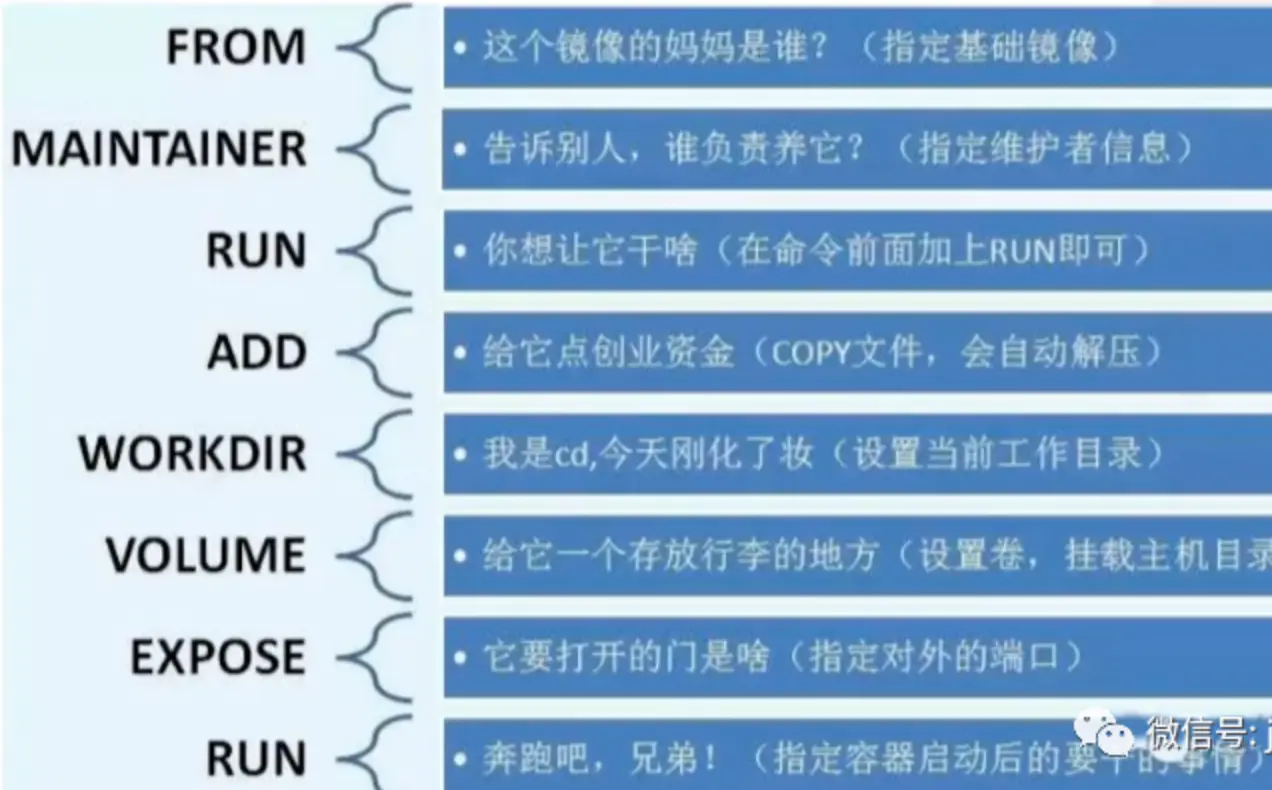

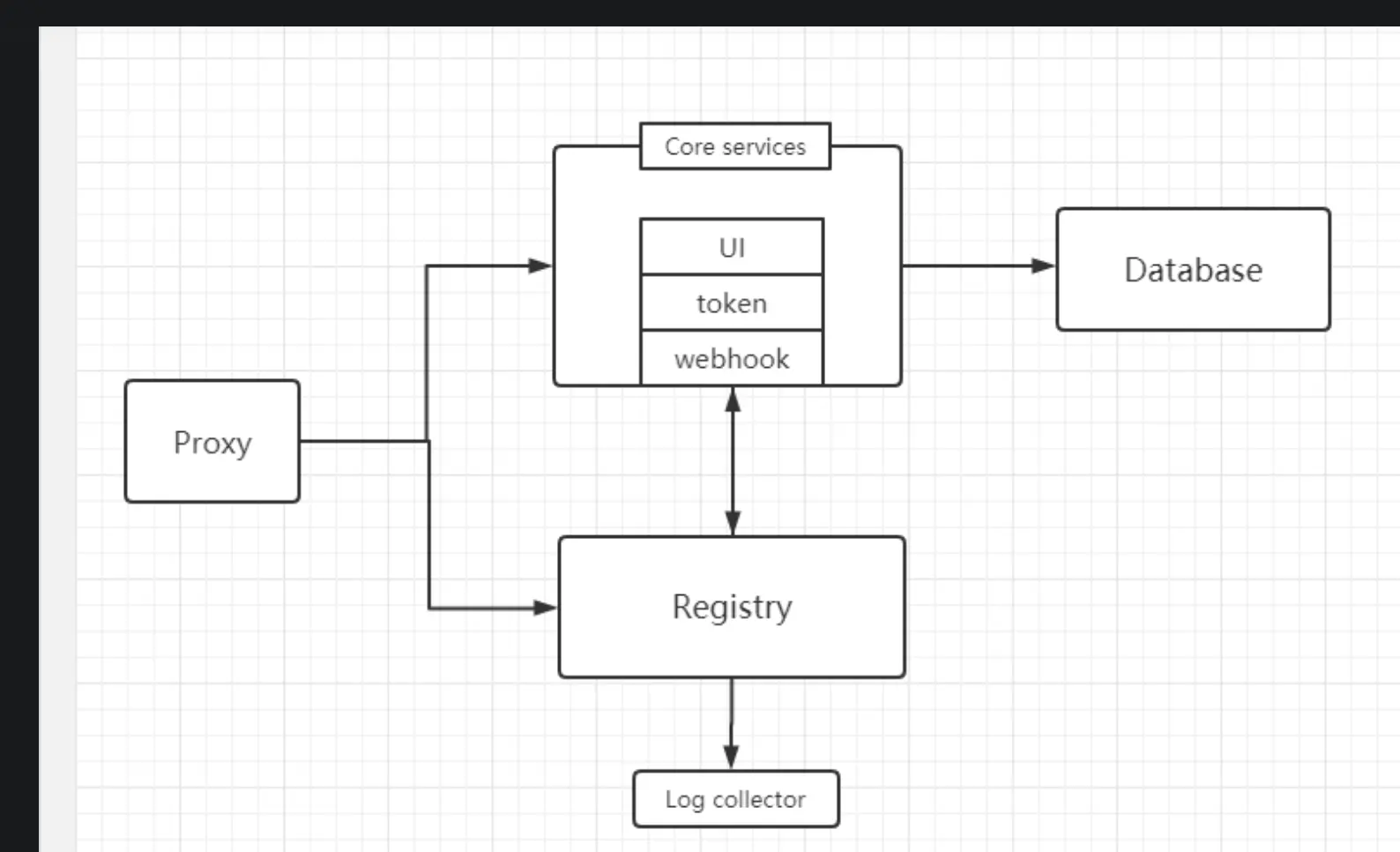

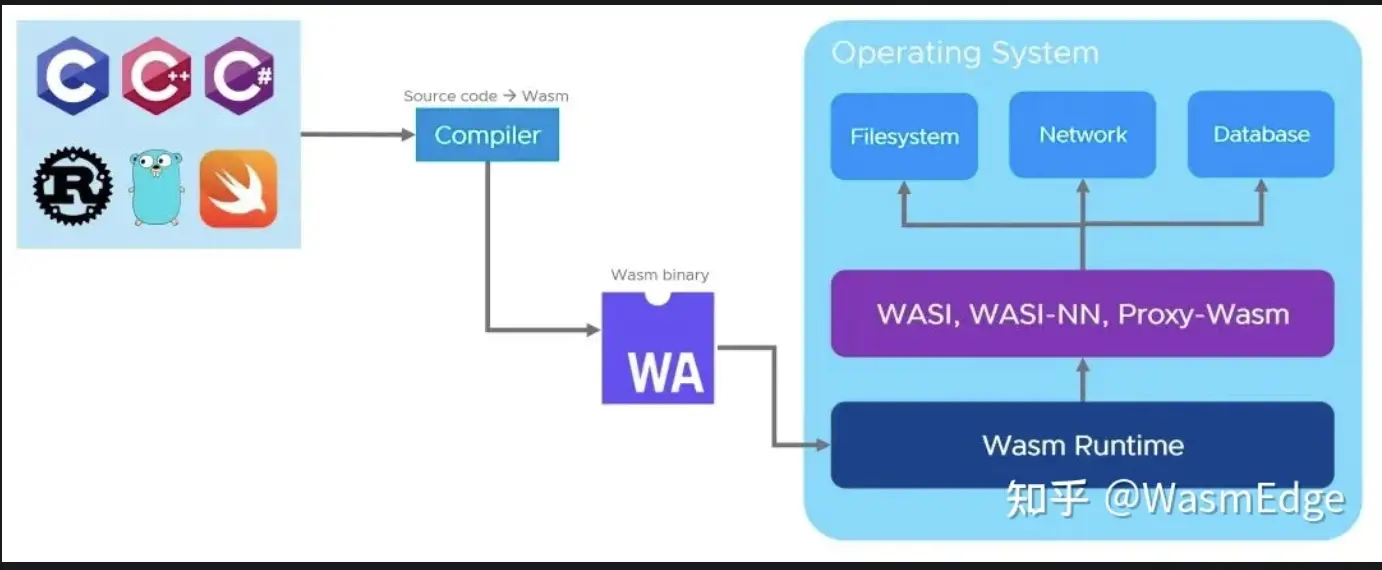

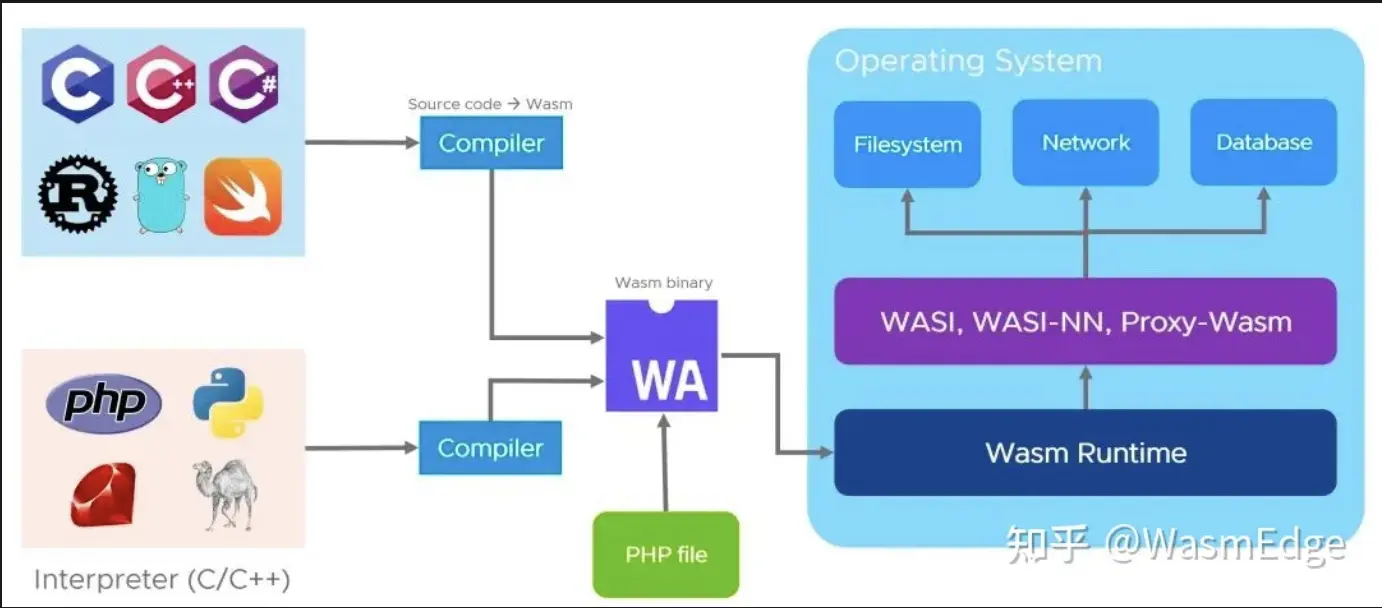

dockerfile示意图

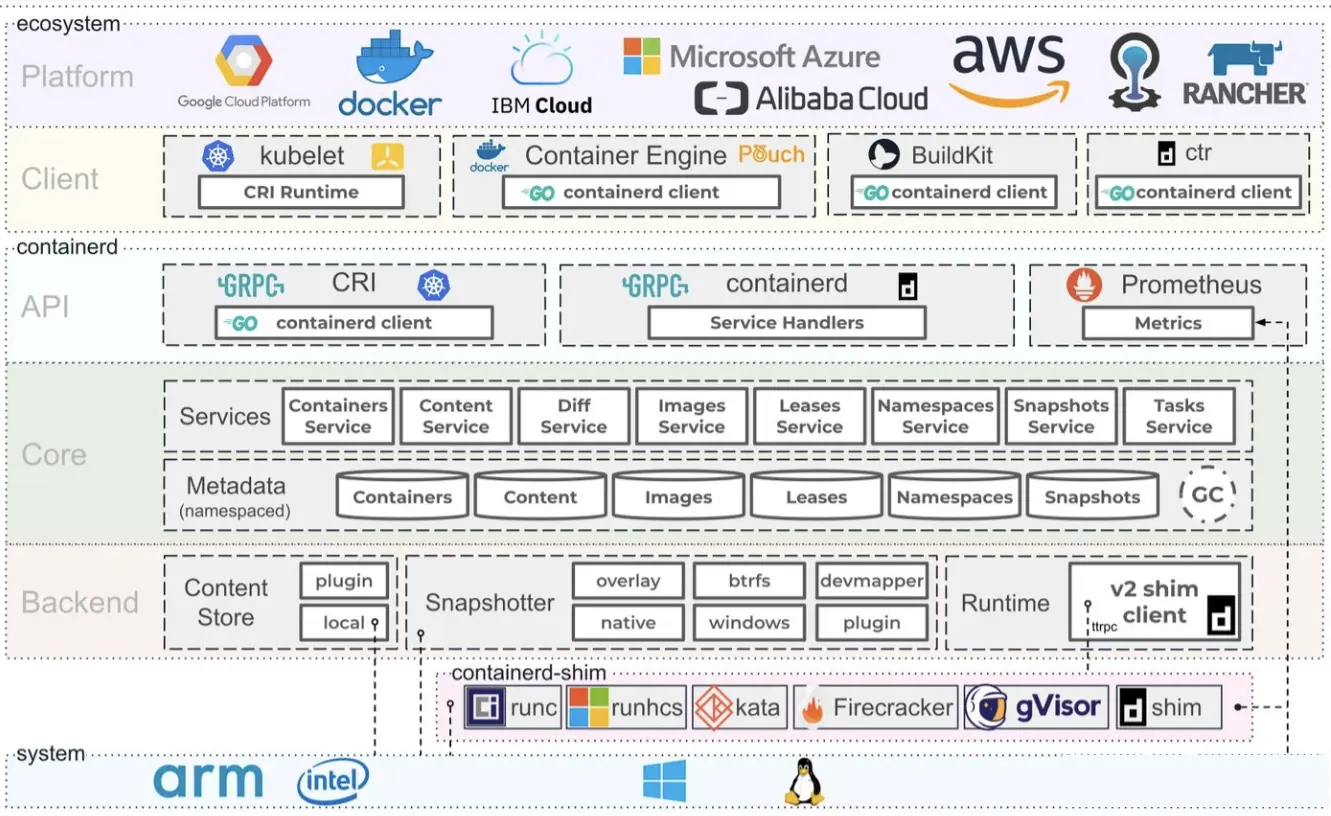

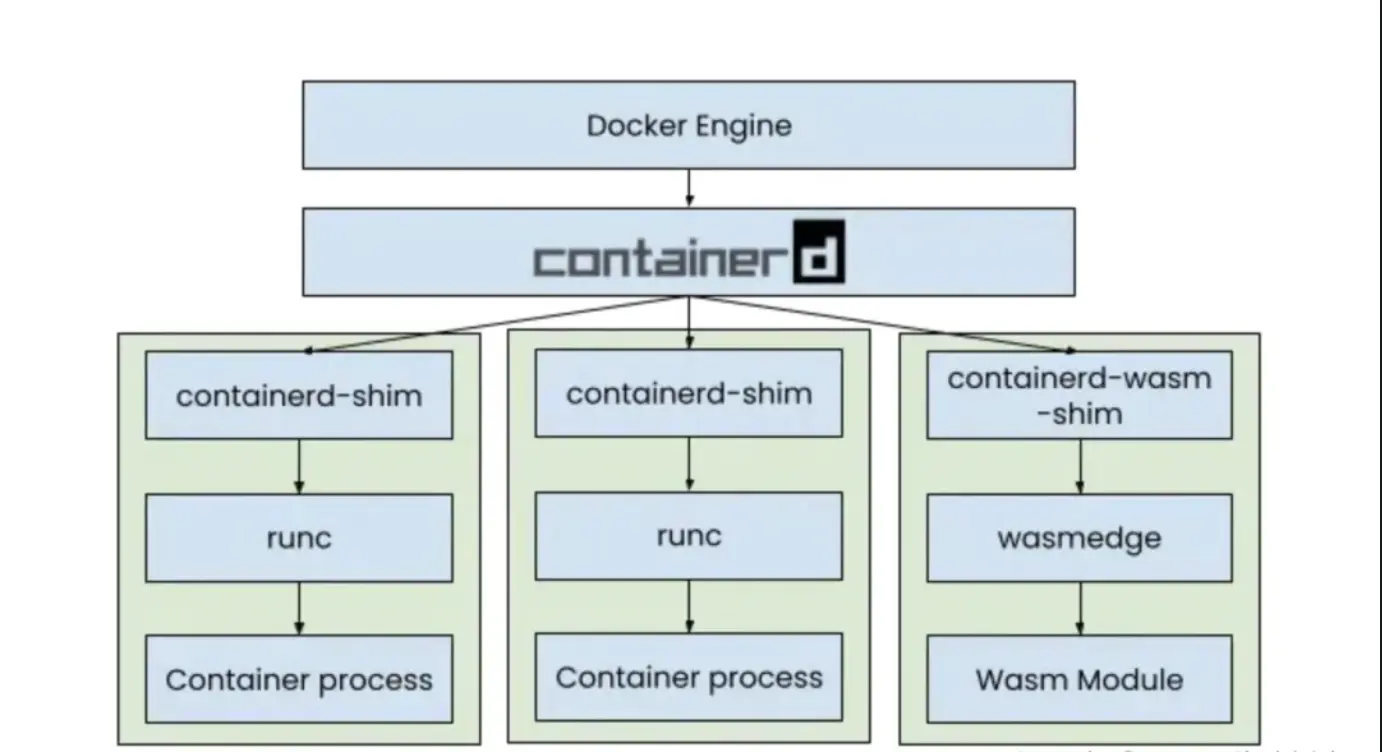

containerd示意图

podman集合-开源替代品

阿里云

# 安装docker引擎

yum install docker

# 开机启动

service docker start

# repos地址

vim /etc/docker/daemon.json

{ "registry-mirrors": "https://registry.docker-cn.com", "live-restore": true }

docker run -d -p 8090:80 docker/getting-started

# 容器日志物理目录

/var/lib/docker/containers/ID/ID-json.log

# 设置共享内存

docker --shm-size 256m

# 安装 elasticsearch

docker pull docker.elastic.co/elasticsearch/elasticsearch:7.5.2

# 启动 openjdk 内存空间有要求

docker run -p 9200:9200 -p 9300:9300 -e "discovery.type=single-node" docker.elastic.co/elasticsearch/elasticsearch:7.5.2

# 在linux至少8G,容易跑起来

# 需要继续 docker kibana rancher

# brancher 集群-多个项目,项目-多个命令空间

# rancher 主界面->右下角有个English,点击选择中文

# 单节点安装,重置密码

docker exec -ti <container_id> reset-password

# 必须带上-v $HOME/rancher:/var/lib/rancher/,否则跑不起来

# 导致https://192.168.8.108:8091,https://127.0.0.1:8091(不能访问)

# rancher启动慢,需要等待片刻就能浏览器访问

# docker logs -f rancher查看容器启动日志

docker run -d --restart=unless-stopped -p 8090:80 -p 8091:443 --privileged -v $HOME/rancher:/var/lib/rancher/ rancher/rancher:latest

rEWlGtFhS52EsKIa

https://127.0.0.1:8091

常用命令

所有images都压缩在Docker.qcow2里

#下载安装gerrit

docker pull gerritcodereview/gerrit

#运行gerrit

docker run -ti -p 8080:8080 -p 29418:29418 gerritcodereview/gerrit

#docker 安装(周编译,较新但可能bug)

docker pull jenkinsci/jenkins

chown -R 1000:1000 /root/jenkins_home

docker run -d -p 8080:8080 --restart=always -v /root/jenkins_home:/var/jenkins_home --name jenkins jenkins/jenkins

# 帮助文档

https://www.w3cschool.cn/jenkins/jenkins-e7bo28ol.html

Blue Ocean值得安装

nohup mdbook serve >~/mdbook.nohup 2>&1 &

docker run --name some-mysql -v /my/own/datadir:/var/lib/mysql -e MYSQL_ROOT_PASSWORD=my-secret-pw -d mysql:tag

#安装gitlab,机器性能要好,否则卡死

docker pull gitlab/gitlab-ce

#gerrit是google开源的代码review工具

docker pull gerritcodereview/gerrit

docker run -ti -p 8080:8080 -p 29418:29418 gerritcodereview/gerrit

# http://localhost:8080

#SonarQube检测代码质量平台

docker pull sonarqube

# Create a tag TARGET_IMAGE that refers to SOURCE_IMAGE

docker tag SOURCE_IMAGE[:TAG] TARGET_IMAGE[:TAG]

# 查看image的产生过程,可以得到dockerfile

docker history --no-trunc alpine

container容器管理

#默认显示运行的容器

docker ps

#显示所有容器

docker ps -a

# attach模式, 类似运行于前台的进程,会占据本地的STDIN和STDOUT

docker run nginx

# 进入容器

docker exec --it containerID/containerName /bash

docker exec --it containerID/containerName redis-cli

# detach模式,可以用docker container attach id改为attach模式,类似于后台运行

docker run -d nginx

# 与容器的交互

docker run -it id(container id) command 当command运行结束之后,container的状态也变成了exited的状态

docker exec -it id command 当command运行结束之后,container的状态保持running状态不变

docker stop $(docker ps -q)

#已经停止的,正在运行的不能删除

docker rm $(docker ps -a -q)

image管理

# 注意images

docker images --help

Usage: docker images [OPTIONS] [REPOSITORY[:TAG]]

List images

Options:

-a, --all Show all images (default hides intermediate images)

--digests Show digests

-f, --filter filter Filter output based on conditions provided

--format string Pretty-print images using a Go template

--no-trunc Donot truncate output

-q, --quiet Only show image IDs

# 删除image为none

docker images|grep none|awk '{print $3 }'|xargs docker rmi

# 注意image

docker image --help

Usage: docker image COMMAND

Manage images

Commands:

build Build an image from a Dockerfile

history Show the history of an image

import Import the contents from a tarball to create a filesystem image

inspect Display detailed information on one or more images

load Load an image from a tar archive or STDIN

ls List images

prune Remove unused images

pull Pull an image or a repository from a registry

push Push an image or a repository to a registry

rm Remove one or more images

save Save one or more images to a tar archive (streamed to STDOUT by default)

tag Create a tag TARGET_IMAGE that refers to SOURCE_IMAGE

volume管理

docker volume --help

Usage: docker volume COMMAND

Manage volumes

Commands:

create Create a volume

inspect Display detailed information on one or more volumes

ls List volumes

prune Remove all unused local volumes

rm Remove one or more volumes

其实VOLUME指令只是起到了声明了容器中的目录作为匿名卷,但是并没有将匿名卷绑定到宿主机指定目录的功能。 当我们生成镜像的Dockerfile中以Volume声明了匿名卷,并且我们以这个镜像run了一个容器的时候,docker会在安装目录下的指定目录下面生成一个目录来绑定容器的匿名卷(这个指定目录不同版本的docker会有所不同),我当前的目录为:/var/lib/docker/volumes/{容器ID}。 volume只是指定了一个目录,用以在用户忘记启动时指定-v参数也可以保证容器的正常运行。 那么如果用户指定了-v,自然而然就不需要volume指定的位置了

network管理

Usage: docker network COMMAND

Manage networks

Commands:

connect Connect a container to a network

create Create a network

disconnect Disconnect a container from a network

inspect Display detailed information on one or more networks

ls List networks

prune Remove all unused networks

rm Remove one or more networks

Run 'docker network COMMAND --help' for more information on a command

其他命令

Management Commands:

builder Manage builds

buildx* Docker Buildx (Docker Inc., v0.8.1)

compose* Docker Compose (Docker Inc., v2.3.3)

config Manage Docker configs

container Manage containers

context Manage contexts

image Manage images

manifest Manage Docker image manifests and manifest lists

network Manage networks

node Manage Swarm nodes

plugin Manage plugins

scan* Docker Scan (Docker Inc., v0.17.0)

secret Manage Docker secrets

service Manage services

stack Manage Docker stacks

swarm Manage Swarm

system Manage Docker

trust Manage trust on Docker images

volume Manage volumes

私有部署dockerhub

# 利用docker公司提供的工具

docker pull registry

# -v 主机目录:容器目录,registry存储仓库中镜像到/var/lib/registry

docker run -d -p 5000:5000 --restart=always -v /opt/dockerhub:/var/lib/registry registry

# 从dockerhub拉取nginx最新版

docker pull nginx

# 打上特定hub的标签

docker tag nginx localhost:5000/nginx

# 推送nginx到目标hub中去

docker push localhost:5000/nginx

# http://主机ip:5000/v2/_catalog 查看信息

# 增加配置,docker默认走https,但是registry默认走http /etc/docker/daemon.json

"insecure-registries":[

"主机:5000"

]

jenkins 另一个开源替代品gocd

-

忘记密码-admin密码未更改情况

- cat ~/.jenkins/secrets/initialAdminPassword 就是初始化密码

- 访问jenkins页面,输入管理员admin,及刚才的密码;

- 进入后可更改其他管理员密码;

-

brew 启动不了

# Bootstrap failed: 5: Input/output error

# Error: Failure while executing; `/bin/launchctl bootstrap gui/503 /Users/zzi/Library/LaunchAgents/homebrew.mxcl.jenkins-lts.plist` exited with 5.

# 试试

brew services restart jenkins-lts

- SSH remote hosts配置中Pty一定不能勾选,否则nohup需要sleep才有效

- 证书是统一管理各种,包括ssh,gitlab等等.

- Multijob插件用来批量构建工程,过时了,改用’parallel’ step along with ‘BlueOcean’ can basical

- Multiple SCMs用来处理多个git/svn仓库构建一个项目

遇到问题

- Docker拉取镜像时出现Error response from daemon: Get https://registry-1.docker.io/v2/: net/http: TLS handshake timeout问题

"registry-mirrors": ["https://bytkgxyr.mirror.aliyuncs.com","https://registry.docker-cn.com","http://hub-mirror.c.163.com"]

golang示例

docker新版本引入多阶段,主要用来优化不同阶段要求不同,例如编译时需要编译工具,但运行时不需要的.运行时只要引入编译产物就可以了.

# syntax=docker/dockerfile:1

## Build

FROM golang:1.16-buster AS build

# 使用 WORKDIR 指令可以来指定工作目录(或者称为当前目录),以后各层的当前目录就被改为指定的目录,如该目录不存在, WORKDIR 会帮你建立目录

WORKDIR /app

# 从构建上下文中复制文件到容器

COPY go.mod ./

COPY go.sum ./

RUN go mod download

COPY *.go ./

RUN go build -o /docker-gs-ping

## Deploy

FROM gcr.io/distroless/base-debian10

WORKDIR /

COPY --from=build /docker-gs-ping /docker-gs-ping

EXPOSE 8080

USER nonroot:nonroot

# 如果设定了ENTRYPOINT,则cmd,和run后面参数都作为entrypoint参数,

# 否则按run后面参数作用cmd运行

# 没有entrypoint,cmd都不存在,则按cmd运行

ENTRYPOINT ["/docker-gs-ping"]

docker build -t docker-gs-ping:multistage -f Dockerfile.multistage .

python示例

# syntax=docker/dockerfile:1

FROM python:3.8-slim-buster

WORKDIR /app

COPY requirements.txt requirements.txt

RUN pip3 install -r requirements.txt

COPY . .

CMD [ "python3", "-m" , "flask", "run", "--host=0.0.0.0"]

docker tag python-docker:latest python-docker:v1.0.0

minikube-单机版精简k8s

你可以使用 kubectl 命令行工具来启用 Dashboard 访问 kubectl 会使得 Dashboard 可以通过 http://localhost:8001/api/v1/namespaces/kubernetes-dashboard/services/http:kubernetes-dashboard:/proxy/ 访问。

kubectl proxy

docker

docker-compose.yml

# 多个services之间自动创建network,并且用web,redis当作别名,加入同个network

# 并且会默认创建volume共享

docker compose up

version: '3'

services:

web:

#冒号之后一定要空格,否则提示错误

build: .

ports: ["3000:3000"]

redis:

image: "redis:7.0-alpine3.17"

dockerfile

FROM python:3.10-alpine

WORKDIR /app

COPY requirements.txt requirements.txt

COPY main.py main.py

RUN pip3 install -r requirements.txt

CMD ["python3", "main.py"]

main.py

from typing import Union

from fastapi import FastAPI

from pydantic import BaseModel

# async def app(scope, receive, send):

app = FastAPI()

class Item(BaseModel):

name: str

price: float

is_offer: Union[bool, None] = None

@app.get("/")

def read_root():

return {"Hello": "World"}

@app.get("/items/{item_id}")

async def read_item(item_id: int, q: Union[str, None] = None):

return {"item_id": item_id, "q": q}

@app.put("/items/{item_id}")

def update_item(item_id: int, item: Item):

return {"item_id": item_id, "item": item}

import redis

client = redis.Redis(host='redis', port=6379, db=0)

@app.get("/hit")

def hit():

val = client.incrby('hit')

return {"hit": val}

if __name__ == "__main__":

import uvicorn

uvicorn.run("main:app", host='0.0.0.0', port=3000)

requirements.txt

fastapi

redis

uvicorn[standard]

nginx

Nginx-中国开源社区

HTTP-V3-Module

brotli-替代gzip压缩算法,更快更省时>

caddy-nginx替代品

可视化配置展示-nginxconfig

动态配置+内置应用支持-nginxunit

动态配置-traefik

openssl爆出各种重大问题,大厂都自已搞了一个分支

源码安装剖析

flowchart LR A(下载) --> B(配置) B --> C(编译) C --> D(安装) D --> E(运行) E --> F(进阶) F --> G(后记)

1.下载

wget https://nginx.org/download/nginx-1.21.6.tar.gz

tar -zxvf nginx-1.21.6.tar.gz

cd nginx-1.21.6

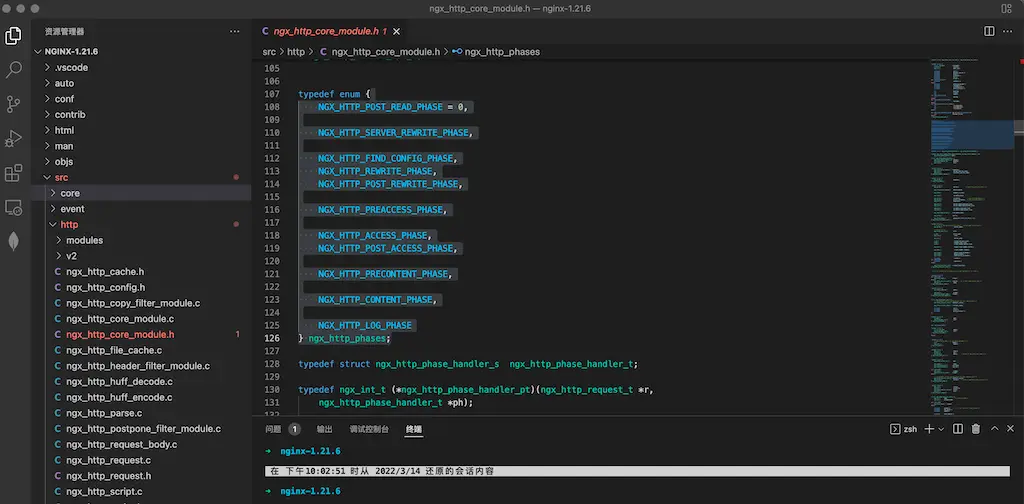

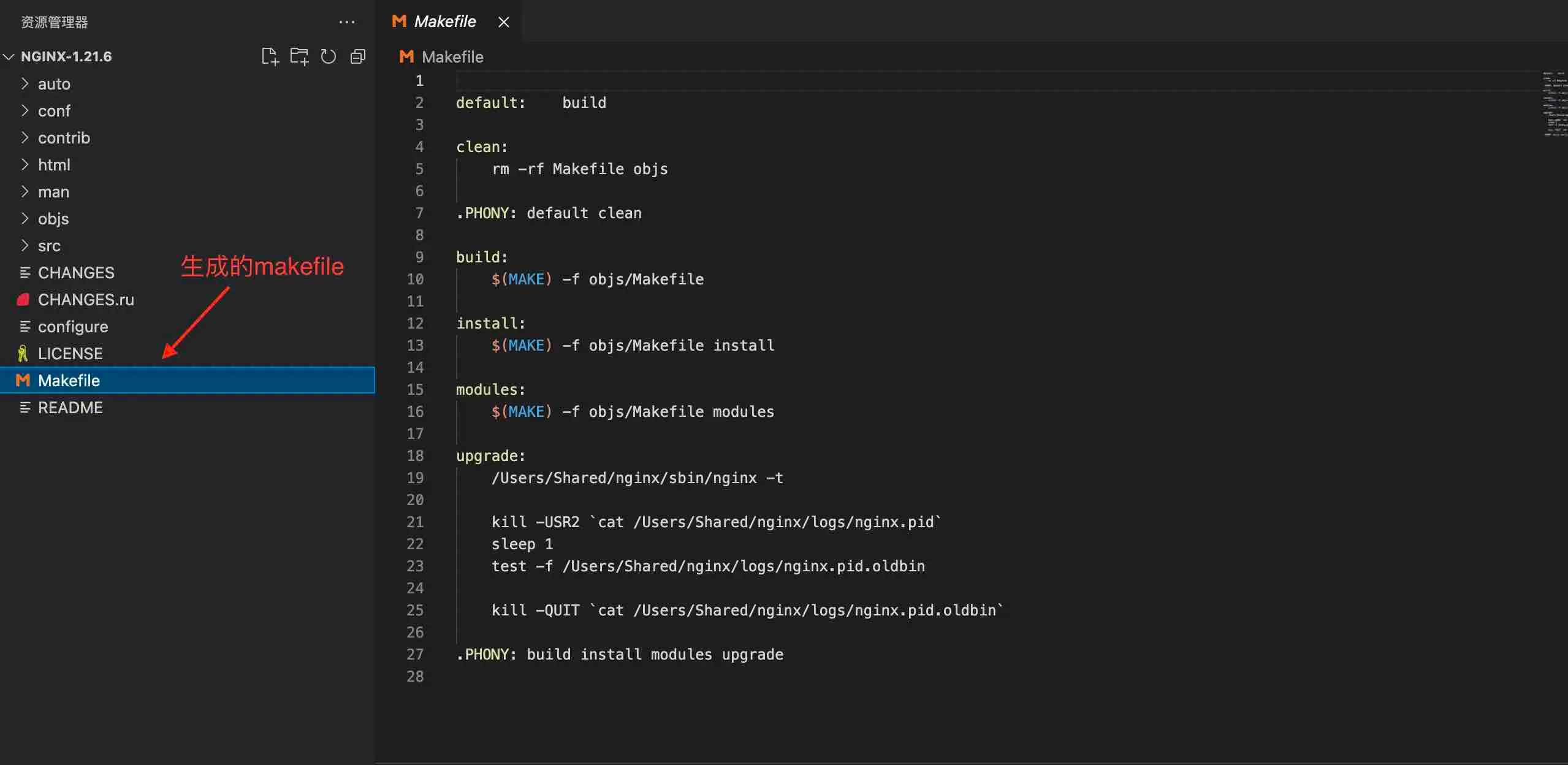

源代码目录,如下图所示:

2. 配置

# prefix参数指定默认路径(安装,配置文件,日志目录, 临时目录等等)

# with-debug参数增加调试日志,正式运行强烈建议不要此参数

./configure --prefix=/Users/Shared/nginx --with-debug

# 更多参数及详细说明见 ./configure --help

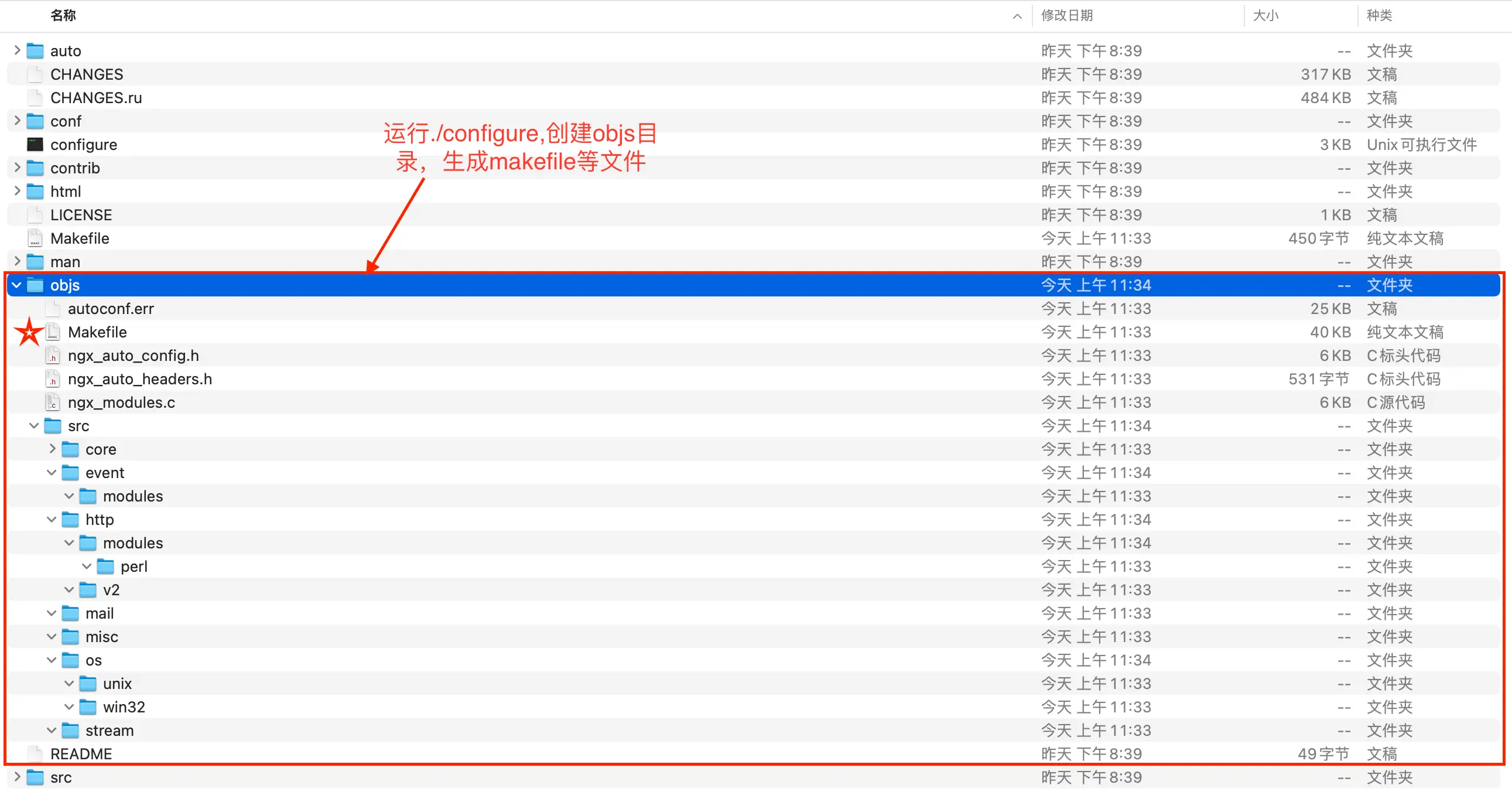

- 生成makefile文件,如下图所示:

- 生成objs子目录,如下图所示

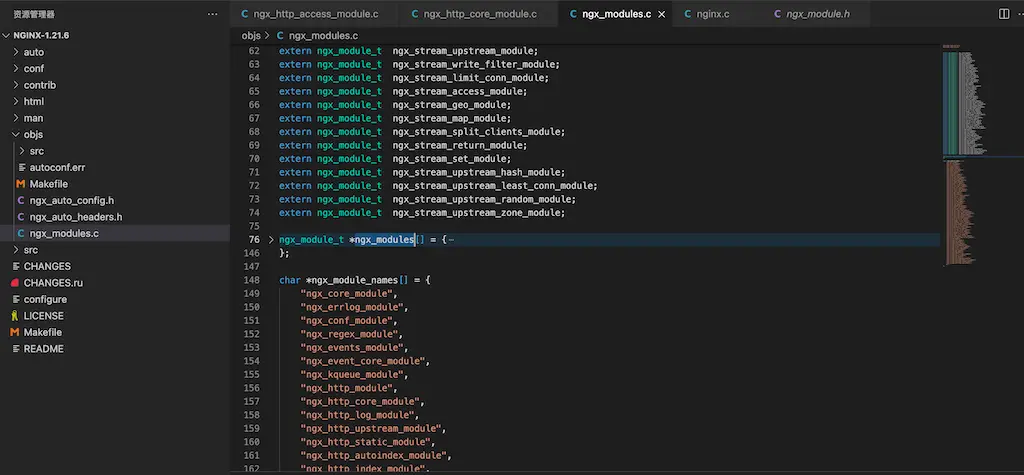

- 生成ngx_modules.c文件,如下图所示:

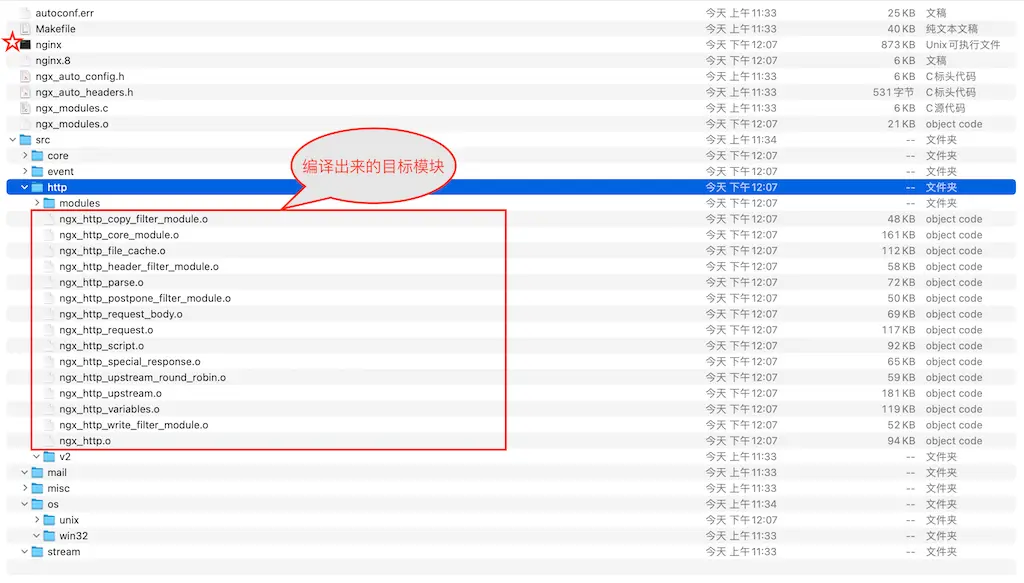

3. 编译

# 实际上执行上一步生成的objs/makefile

make

- 生成启用模块目标文件,如下图所示:

4. 安装

# 实际上执行上一步生成的objs/makefile

make install

- 安装执行代码,如下所示:

install: build

test -d '$(DESTDIR)/Users/Shared/nginx' || mkdir -p '$(DESTDIR)/Users/Shared/nginx'

test -d '$(DESTDIR)/Users/Shared/nginx/sbin' \

|| mkdir -p '$(DESTDIR)/Users/Shared/nginx/sbin'

test ! -f '$(DESTDIR)/Users/Shared/nginx/sbin/nginx' \

|| mv '$(DESTDIR)/Users/Shared/nginx/sbin/nginx' \

'$(DESTDIR)/Users/Shared/nginx/sbin/nginx.old'

cp objs/nginx '$(DESTDIR)/Users/Shared/nginx/sbin/nginx'

test -d '$(DESTDIR)/Users/Shared/nginx/conf' \

|| mkdir -p '$(DESTDIR)/Users/Shared/nginx/conf'

....

test -d '$(DESTDIR)/Users/Shared/nginx/logs' \

|| mkdir -p '$(DESTDIR)/Users/Shared/nginx/logs'

- 安装目录,如下图所示:

5.运行

# /Users/Shared/nginx为configure中prefix参数指定

cd /Users/Shared/nginx/sbin

# -t 表示检查配置文件是否正确

./nginx -t

./nginx

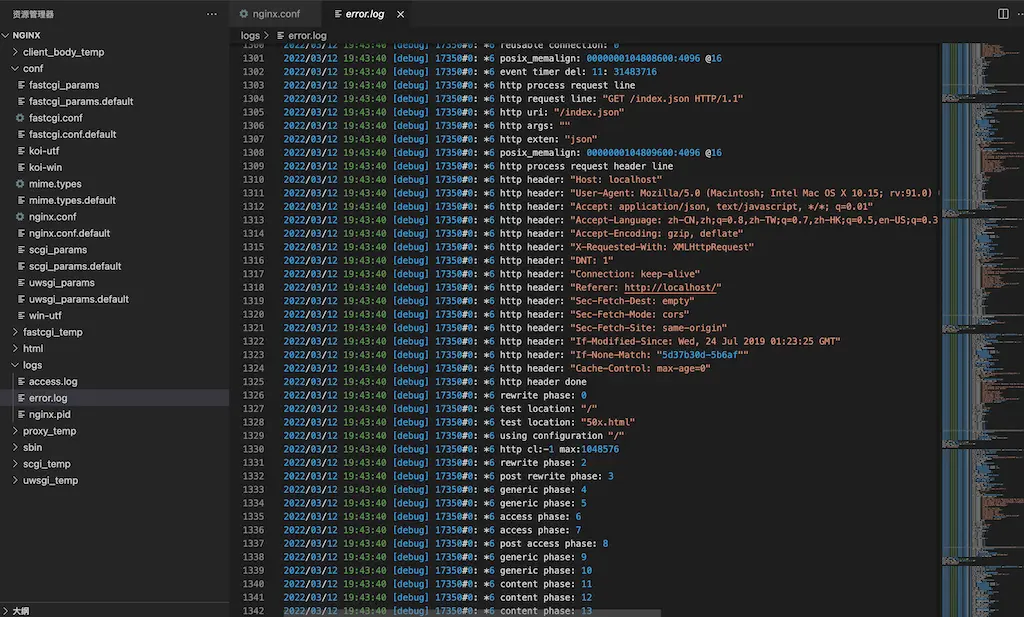

- 日志目录,如下图所示:

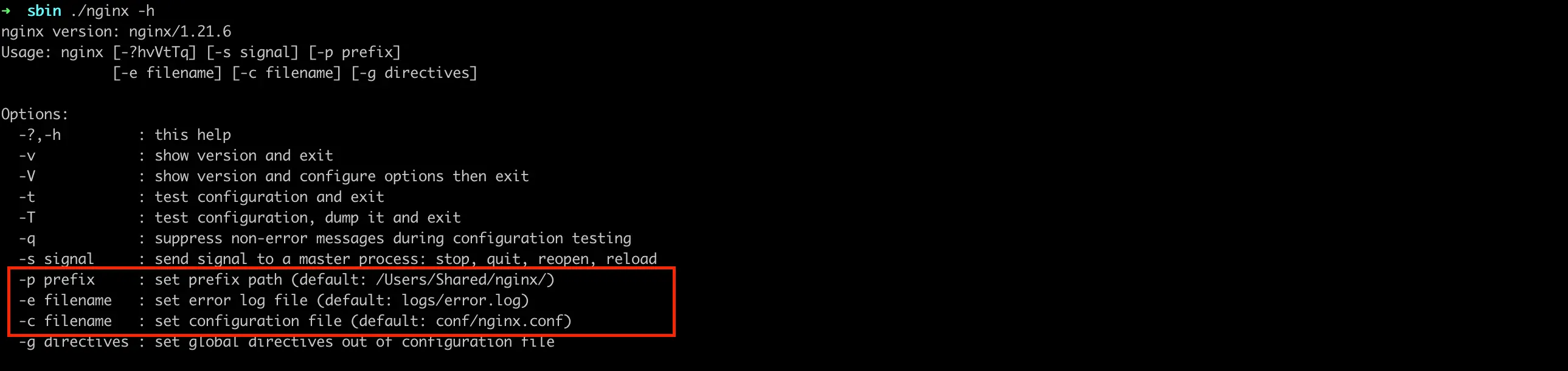

- 查看帮助,如下图所示:

./nginx -h

- 查看调试日志,如下图所示:

http {

...

server {

listen 80;

server_name localhost;

# 编译时需要带上--with-debug

# 如果仅看http过程,则指定等级为debug_http

error_log logs/error.log debug;

location / {

root html;

index index.html index.htm;

}

}

...

}

6. 进阶

1. 安装第三方模块及禁/启用自带模块

# ../nginx-party-module/echo-nginx-module是echo-nginx-module模块源代码目录

./configure \

--prefix=/Users/Shared/nginx \

--without-http_empty_gif_module \

--with-stream \

--add-module=../nginx-party-module/echo-nginx-module

- –without参数禁用自带模块

- –with参数启用自带模块

- –add-module参数安装第三方模块

2. 编译安装

make && make install

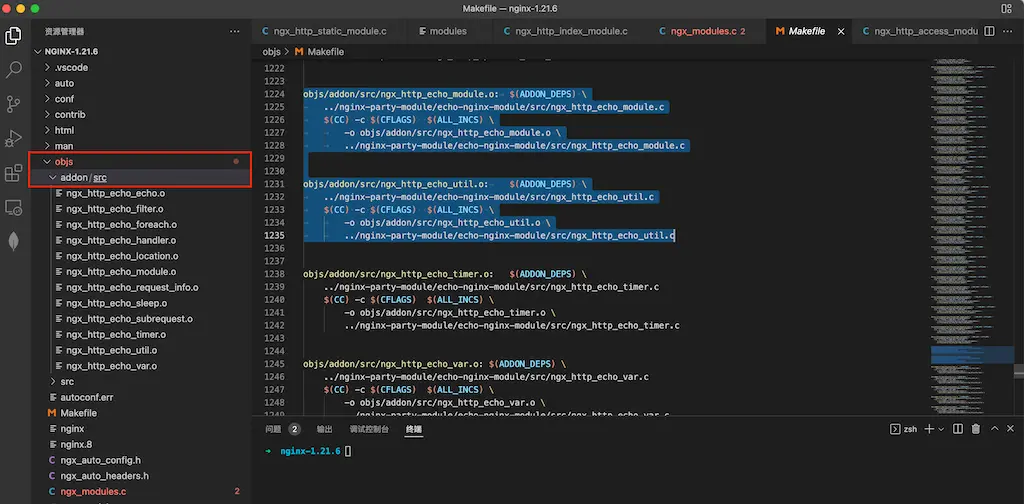

- make时在objs目录产生一个addon子目录,保存echo-nginx-module模块相关文件,如下图所示:

3. 编辑nginx.conf,运行

cd /Users/Shared/nginx/conf

vim nginx.conf

....

# echo-nginx-module模块详细见项目网址

location /hello {

echo "hello, world!";

}

...

cd ../sbin

./nginx

4. 测试

curl http://localhost/hello

hello,world!

5. 原理分析

-

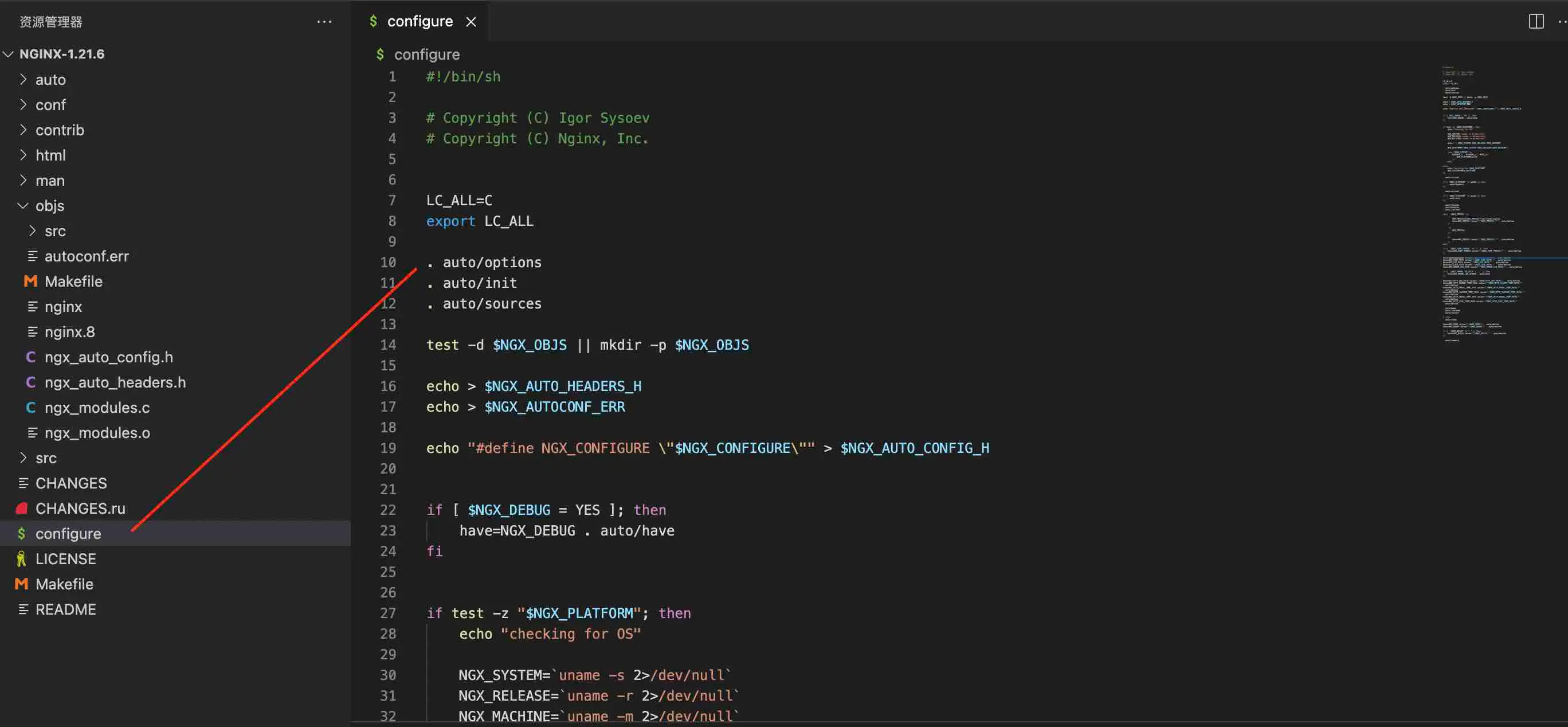

configure脚本先引用auto目录下的options脚本,如下图所示:

-

options脚本设参数默认值,如下图所示:

-

configure脚本再引用auto目录下的modules脚本,如下图所示:

-

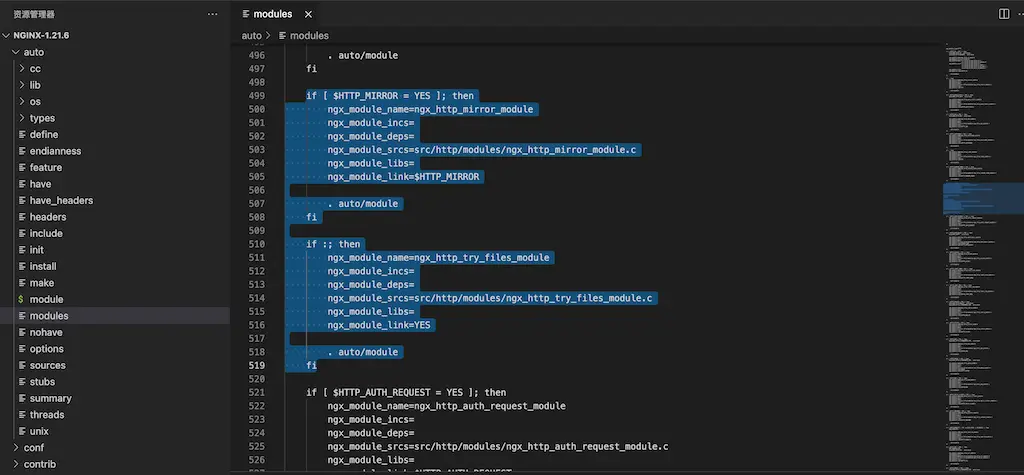

modules脚本如果参数为yes则引入编译,如下图所示:

-

objs目录的ngx_modules.c文件就会增加引入的模块名,如下所示:

...

ngx_module_t *ngx_modules[] = {

&ngx_core_module,

&ngx_errlog_module,

&ngx_conf_module,

&ngx_regex_module,

&ngx_events_module,

&ngx_event_core_module,

&ngx_kqueue_module,

&ngx_http_module,

...

&ngx_stream_upstream_zone_module,

NULL

};

...

-

ngx_modules.h的声明引用ngx_modules.c中ngx_modules,如下图所示:

-

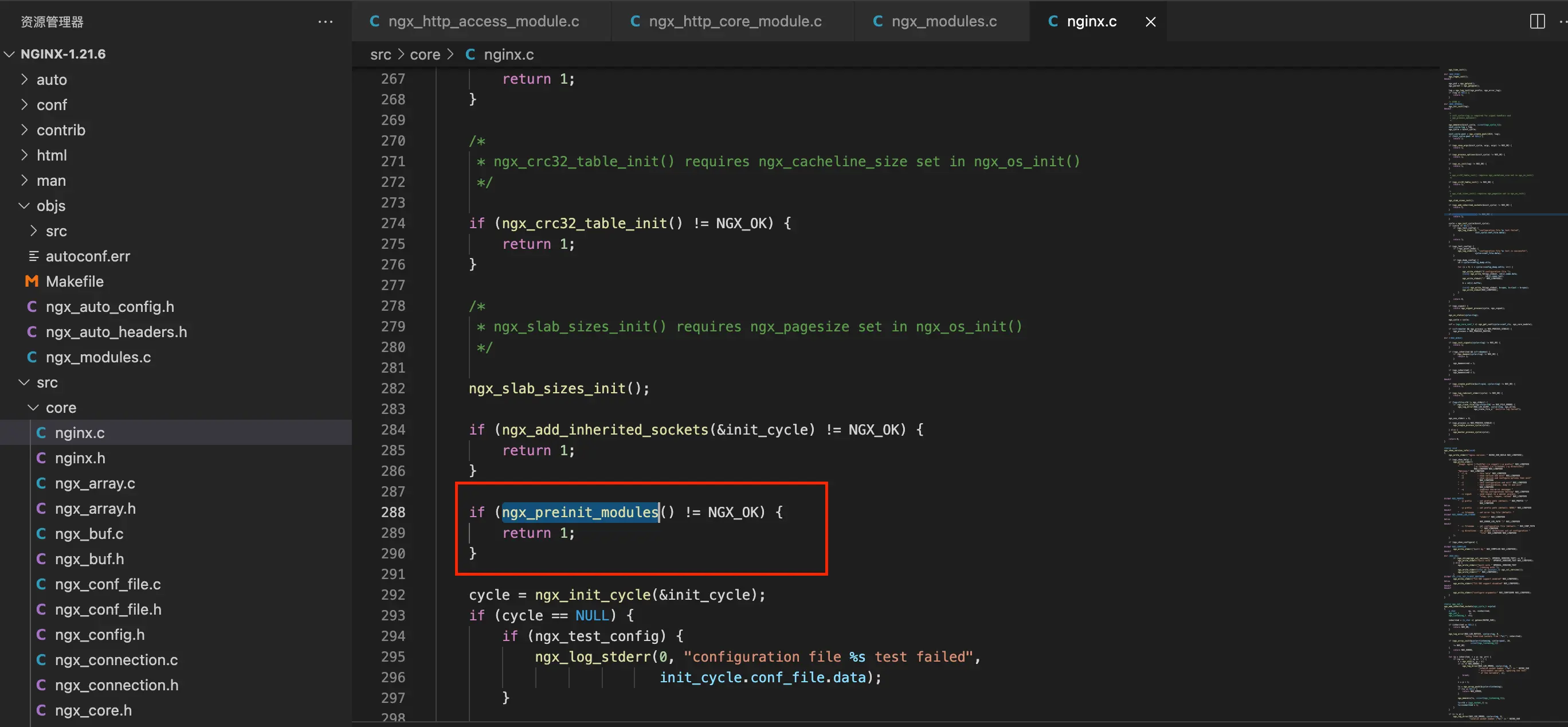

nginx.c的main函数调用nginx_module.c中ngx_preinit_modules函数,如下图所示:

-

nginx_module.c中ngx_preinit_modules函数使用ngx_modules.c中ngx_modules,如下所示:

ngx_int_t

ngx_preinit_modules(void)

{

ngx_uint_t i;

/*

ngx_modules变量为ngx_modules.c中定义

*/

for (i = 0; ngx_modules[i]; i++) {

ngx_modules[i]->index = i;

ngx_modules[i]->name = ngx_module_names[i];

}

ngx_modules_n = i;

ngx_max_module = ngx_modules_n + NGX_MAX_DYNAMIC_MODULES;

return NGX_OK;

}

- 动态配置和静态编译执行在此完美结合起来

7. 后记

-

这里有很多优秀的nginx第三方模块,可供下载使用

-

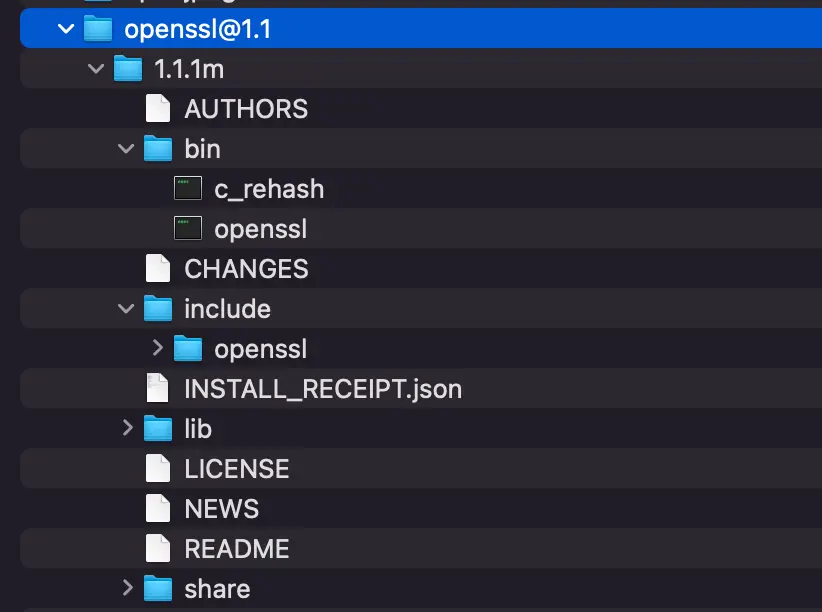

安装ssl

./configure --prefix=/Users/Shared/nginx \

--add-module=../nginx-party-module/ngx_http_redis-module \

--with-http_v2_module \

--with-http_ssl_module \

--with-openssl=/opt/homebrew/Cellar/openssl@1.1/1.1.1m\

--with-debug

- http_v2_module不一定需要ssl,浏览器一般强制需要

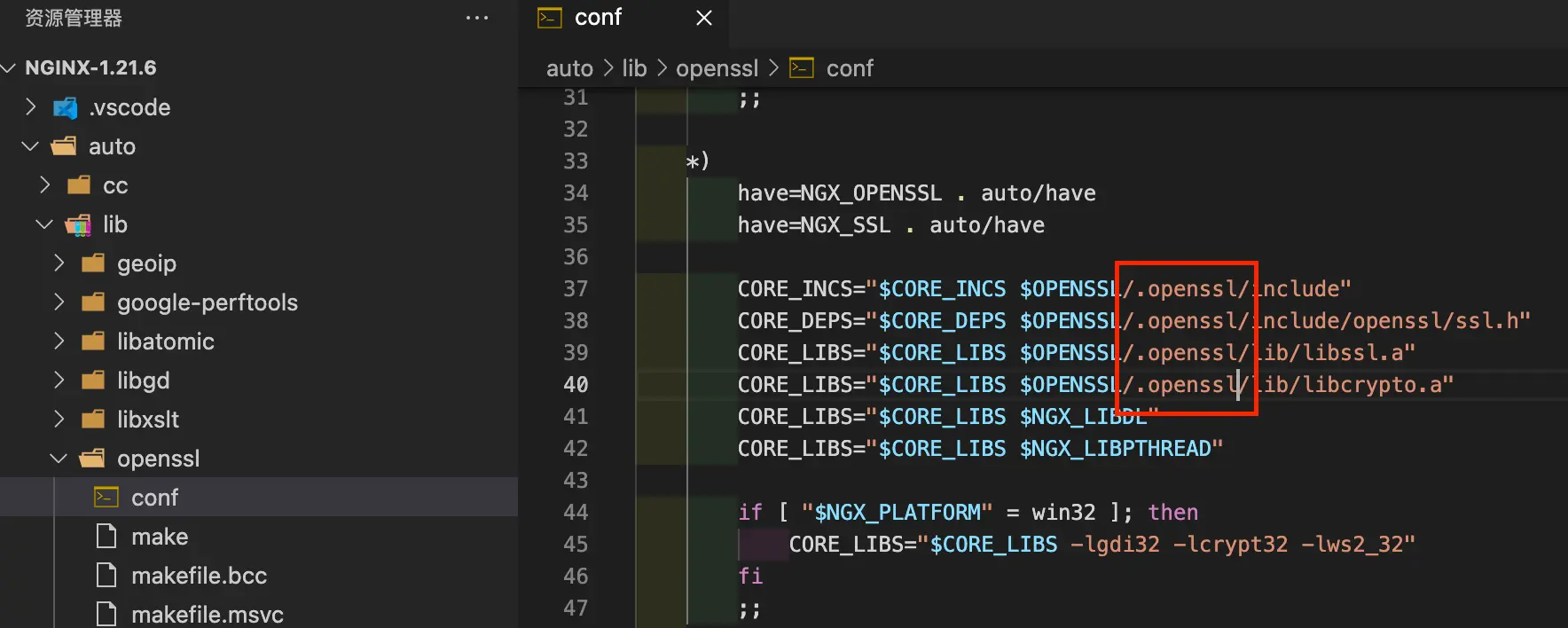

- http_ssl_module需要ssl目录,在linux一般指ssl-devel,需要include/lib目录

- 如果make仍然出错,移除掉路径中.openssl/,默认和系统中路径不同,多了一级.openssl/

HTTP模块

核心模块阶段

flowchart TD

subgraph POST_READ

realip(realip)

end

subgraph SERVER_REWRITE

rewrite(rewrite)

end

subgraph FIND_CONFIG

NULL(NULL)

end

subgraph REWRITE

rewrite2(rewrite)

end

subgraph POST_REWRITE

NULL2(NULL)

end

subgraph PREACCESS

direction LR

degradation(degradation) --> limit_conn(limit_conn)

limit_conn --> limit_req(limit_req)

limit_req --> realip2(realip)

end

subgraph ACCESS

direction LR

access(access) --> auth(auth)

end

subgraph POST_ACCESS

NULL3(NULL)

end

subgraph PRECONTENT

direction LR

mirror(mirror) --> try_files(try_files)

end

subgraph CONTENT

direction LR

static(static) --> gzip_static(gzip_static)

gzip_static --> dav(dav)

dav --> autoindex(autoindex)

autoindex --> index(ndex)

index --> random_index(random_index)

end

subgraph LOG

log(log)

end

POST_READ --> SERVER_REWRITE

SERVER_REWRITE --> FIND_CONFIG

FIND_CONFIG --> REWRITE

REWRITE --> POST_REWRITE

POST_REWRITE --> PREACCESS

PREACCESS --> ACCESS

ACCESS --> POST_ACCESS

POST_ACCESS --> PRECONTENT

PRECONTENT --> CONTENT

CONTENT --> LOG

POST_REWRITE阶段如果有rewrite,则会跳回到FIND_CONFIG阶段

源代码中定义,如下图所示:

FastCGI模块

sequenceDiagram

actor n as nginx进程

actor c as CGI进程

n->>c: begin_request处理开始

n->>c: params请求参数

n->>+c: stdin请求数据内容

c->>c:请求处理

c-->>-n: stdout处理结果

c-->>n: end_request处理结束

static模块

把请求url中path映射本地路径,读取本地文件返回客户端

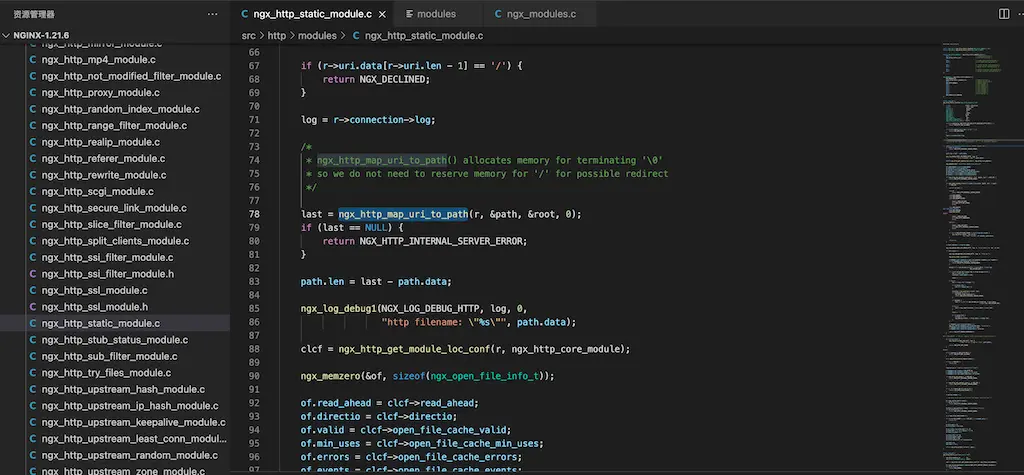

核心源代码,如下图所示:

index模块

引入配置参数index,如下图所示:

请求url为目录时,把配置参数index值附加在url上,然后内部转跳

static ngx_int_t

ngx_http_index_handler(ngx_http_request_t *r)

{

...

if (index[i].name.data[0] == '/') {

return ngx_http_internal_redirect(r, &index[i].name, &r->args);

}

...

ngx_log_debug1(NGX_LOG_DEBUG_HTTP, r->connection->log, 0,

"open index \"%V\"", &path);

...

return ngx_http_internal_redirect(r, &uri, &r->args);

}

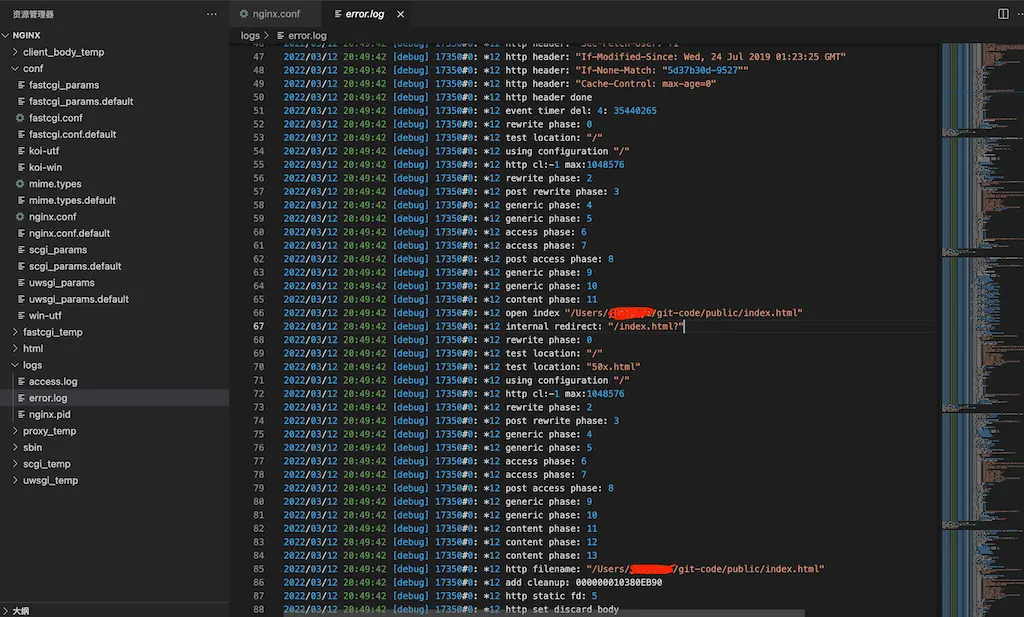

转跳调试日志,如下图所示:

常用技巧

配置片段

-

http转向https

rewrite ^(.*) https://$server_name$1 permanent; rewrite ^(.*) https://$host$1 permanent;- 两种写法,各有适合场合

- $server_name, 由nginx配置决定

- $host,由请求路径决定

-

正向代理

server { listen 80; location / { proxy_pass http://$host$request_uri; } }- 配合日志,可以用来调试

- 可以过滤掉特定请求

- 可以检查http请求是否被拦截

-

解决无法加载样式表

# 否则无法加载样式表 include /etc/nginx/mime.types; default_type application/octet-stream; -

支持http2

-

自定义安装带上v2,ssl

./configure --prefix=/Users/Shared/nginx \ --with-http_v2_module \ --with-http_ssl_module \ --with-openssl=/opt/homebrew/Cellar/openssl@1.1/1.1.1m\ --with-debug -

配置增加上http2

... server { # 默认情况http2都走ssl,所以在ssl加上http2 listen 443 ssl http2; ... } ...

-

-

支持http3

-

自定义安装带上v3,ssl,brotli

./auto/configure --with-http_v3_module \ --with-stream_quic_module \ --with-http_ssl_module \ --with-http_v2_module \ --add-module=../ngx_brotli \ --with-cc-opt="-I../libressl/build/include" \ --with-ld-opt="-L../libressl/build/lib" -

配置增加上http3

... http { brotli on; brotli_comp_level 6; brotli_types text/plain text/css application/json application/x-javascript text/xml application/xml application/xml+rss text/javascript application/javascript image/svg+xml; server { # 默认情况http2都走ssl,所以在ssl加上http2 listen 443 ssl http2; listen 443 http3 reuseport; # UDP listener for QUIC+HTTP/3,在主域名表示reuseport,否则会提示冲突 ssl_protocols TLSv1.3; # QUIC requires TLS 1.3 # 一定要添加头部,否则无法开启 add_header alt-svc 'h3=":443"; ma=86400;quic=":443"; ma=2592000; v="46,43", h3-Q050=":443"; ma=2592000, h3-Q049=":443"; ma=2592000, h3-Q048=":443"; ma=2592000,h3-Q046=":443"; ma=2592000, h3-Q043=":443"; ma=2592000, h3-23=":443"; ma=2592000'; ... } ... } ...

-

-

四层代理-stream

-

自定义安装带上stream

./configure --prefix=/Users/Shared/nginx \ --with-stream \ --with-debug make && make install -

配置增加上stream

... stream { server { listen 8411; proxy_timeout 3s; proxy_pass xxx:8411; } } ...

-

-

gzip-压缩支持

... http { # 打开gzip指令,否则后面不会生效 gzip on; # 回包头部增加content-encoding: gzip gzip_vary on; # 压缩类型 gzip_types text/plain text/css application/json application/x-javascript text/xml application/xml application/xml+rss text/javascript application/javascript image/svg+xml; } ... -

location / { #可以多次映像/复制,从而起到放大流量功能 #产生一个http subrequest "/mirror?",跳转到相应location #所以mirror结果(包括超时,服务器关闭,50x,40x等等),不影响这个本身速度及结果 #但是占用内存,消费conn连接池之类还是要的 #mirror /mirror; #mirror /mirror; mirror /mirror; #允许丢掉body #mirror_request_body off; proxy_pass http://backend; } location = /mirror { # 判断请求方法,不是GET返回403,用其他类似手段缩小流量规模 # if ($request_method != GET) { # return 403; # } internal; #这里的回包是忽略 proxy_pass http://test_backend$request_uri; #允许丢掉body #proxy_pass_request_body off; #proxy_set_header Content-Length ""; proxy_set_header X-Original-URI $request_uri; } -

利用日志调试

server { ... #降低错误日志等级,例如notice,如果编译带有--with-debug,则可以debug,debug_http error_log logs/error.log info; #不同路径不同access日志文件,确认哪个loc使用 location /hello { ... access_log logs/hello_access.log; ... } location /world { ... access_log logs/world_access.log; ... } ... } -

root与alias区别

# 请求/abc/123 ==> /var/www/app/static/abc/123

location /abc {

# In case of the root directive, full path is appended to the root including the location part

# 请求的path附加上root指定path,组合本地路径

root /var/www/app/static;

autoindex off;

}

# 请求/abc/123 ==> /var/www/app/static/123

location /abc {

# only the portion of the path NOT including the location part is appended to the alias.

# 请求的path移除掉location的path,再附加上alias指定path,组合本地路径

alias /var/www/app/static;

autoindex off;

}

常用模块

-

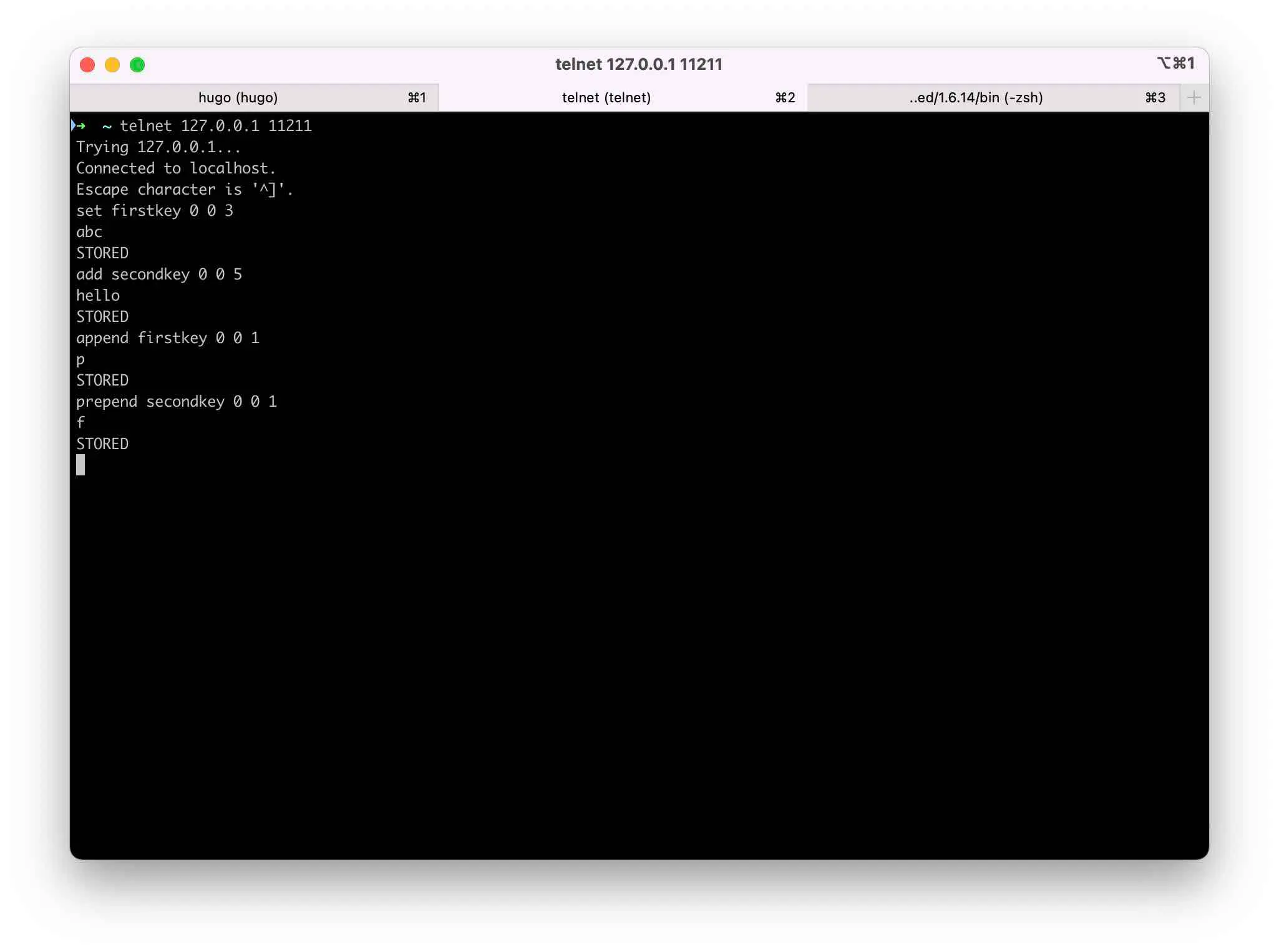

http_memcached模块

... location /memcached { set $memcached_key "$uri"; memcached_pass 127.0.0.1:11211; #指示返回为html,方便浏览器直接显示 default_type text/html; error_page 404 502 504 = @notexit; } location @notexit { #echo为第三方模块引入指令,方便调试 echo "noexit$uri"; } ...

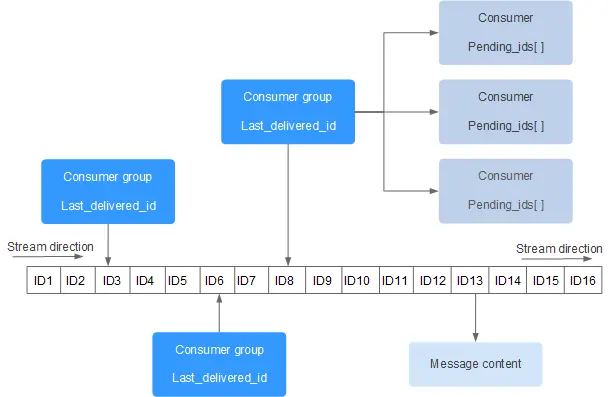

sequenceDiagram actor u as user actor n as nginx actor m as memcached u->>n: http请求/memcached n->>m: get命令key值为$uri(/memcached) m->>n: 存在则返回值,否则返回空 n->>u: 成功获取,则直接返回,否则转跳notexit

-

ngx_http_redis第三方模块,类似http_memcached

./configure --prefix=/Users/Shared/nginx \ --add-module=../nginx-party-module/ngx_http_redis-module \ ... --with-debug make && make install... location /redis { set $redis_key "$uri"; redis_pass 127.0.0.1:6379; #指示返回为html,方便浏览器直接显示 default_type text/html; error_page 404 502 504 = @notexit; } location @notexit { #echo为第三方模块引入指令,方便调试 echo "noexit$uri"; } ...

sequenceDiagram actor u as user actor n as nginx actor m as redis u->>n: http请求/redis n->>m: get命令key值为$uri(/redis) m->>n: 存在则返回值,否则返回空 n->>u: 成功获取,则直接返回,否则转跳notexit

-

redis2-nginx-module第三方模块,更强大更多操作

./configure --prefix=/Users/Shared/nginx \ --add-module=../nginx-party-module/redis2-nginx-module \ --with-debug make make install... location = /foo { set $value '<html><H1>From Nginx Redis</H1></html>'; redis2_query set one $value; redis2_pass 127.0.0.1:6379; } location = /get { redis2_query get one; redis2_pass 127.0.0.1:6379; } ...

sequenceDiagram actor u as user actor n as nginx actor r as redis u->>n: http请求/get n->>r: get命令key值为one r->>n: 标准命令处理 n->>u: 返回原始键值

常见问题

-

server_names_hash问题

[emerg] could not build server_names_hash, you should increase server_names_hash_bucket_size: 32 -

解决办法

# 如果不够,继续增加,大小必须是32*n server_names_hash_bucket_size 64; -

invalid request问题

# asscess.log 有这种提示 "PRI * HTTP/2.0" 400 157 "-" "-" # error.log 有这种提示 client sent invalid request while reading client request line -

解决办法-客户端没有采用ssl,tls,但访问nginx配置需要ssl

-

php-fpm出现Primary script unknown问题

-

尝试修改nginx配置

# FastCGI sent in stderr: "Primary script unknown" while reading response header from upstream, # fastcgi_param SCRIPT_FILENAME /scripts$fastcgi_script_name; fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name; -

如果仍然不行,则打开php-fpm.conf日志配置

access.log = /var/log/php-fpm.$pool.access.log -

再打开nginx日志配置

# http log_format scripts '$document_root$fastcgi_script_name > $request'; # server access_log /usr/local/nginx/scripts.log scripts; -

重启nginx,和php-fpm 查看日志,一般是路径不对和权限不对

-

-

php-fpm出现无法连接数库,可能是编译参数不对

./configure --enable-fpm --prefix=/usr/local/php --with-mysqli=mysqlnd --with-pdo-mysql=mysqlnd -

不知道当前nginx所用配置文件

# 获取nginx进程号 ps -ef | grep nginx # 获取nginx路径 cd /proc/pid ls -a # 执行相应路径的语法测试,输出就能看到路径 nginx -t -

不知道当前nginx的编译参数

# 获取nginx进程号 ps -ef | grep nginx # 获取nginx路径 cd /proc/pid ls -a # 执行相应路径的语法测试,输出就能看到路径 nginx -V

rtmp

下载安装rtmp模块

编译

/configure --prefix=/Users/Shared/nginx \

--add-module=../nginx-party-module/nginx-rtmp-module \

--with-http_ssl_module \

--with-openssl=/opt/homebrew/Cellar/openssl@1.1/1.1.1m\

--with-debug

make

make install

修改配置

rtmp {

server {

listen 1935;

application vod {

play /Users/xxx/iCloud-archive/video;

}

}

}

访问

#vlc打开串流地址

rtmp://host/vod/xxx.mp4

附录

-

RTMP、RTSP、HTTP协议理论上都可以用来做视频直播或点播,直播一般用RTMP,RTSP,点播用 HTTP

-

RTMP协议

- 是流媒体协议。

- RTMP协议是 Adobe 的私有协议,未完全公开。

- RTMP协议一般传输的是 flv,f4v 格式流。

- RTMP一般在 TCP 1个通道上传输命令和数据。

-

RTSP协议

- 是流媒体协议。

- RTSP协议是共有协议,并有专门机构做维护

- RTSP协议一般传输的是 ts、mp4 格式的流。

- RTSP传输一般需要 2-3 个通道,命令和数据通道分离。

-

HTTP协议

- 不是是流媒体协议。

- HTTP协议是共有协议,并有专门机构做维护

- HTTP协议没有特定的传输流

- HTTP传输一般需要 2-3 个通道,命令和数据通道分离

golang

官网

-

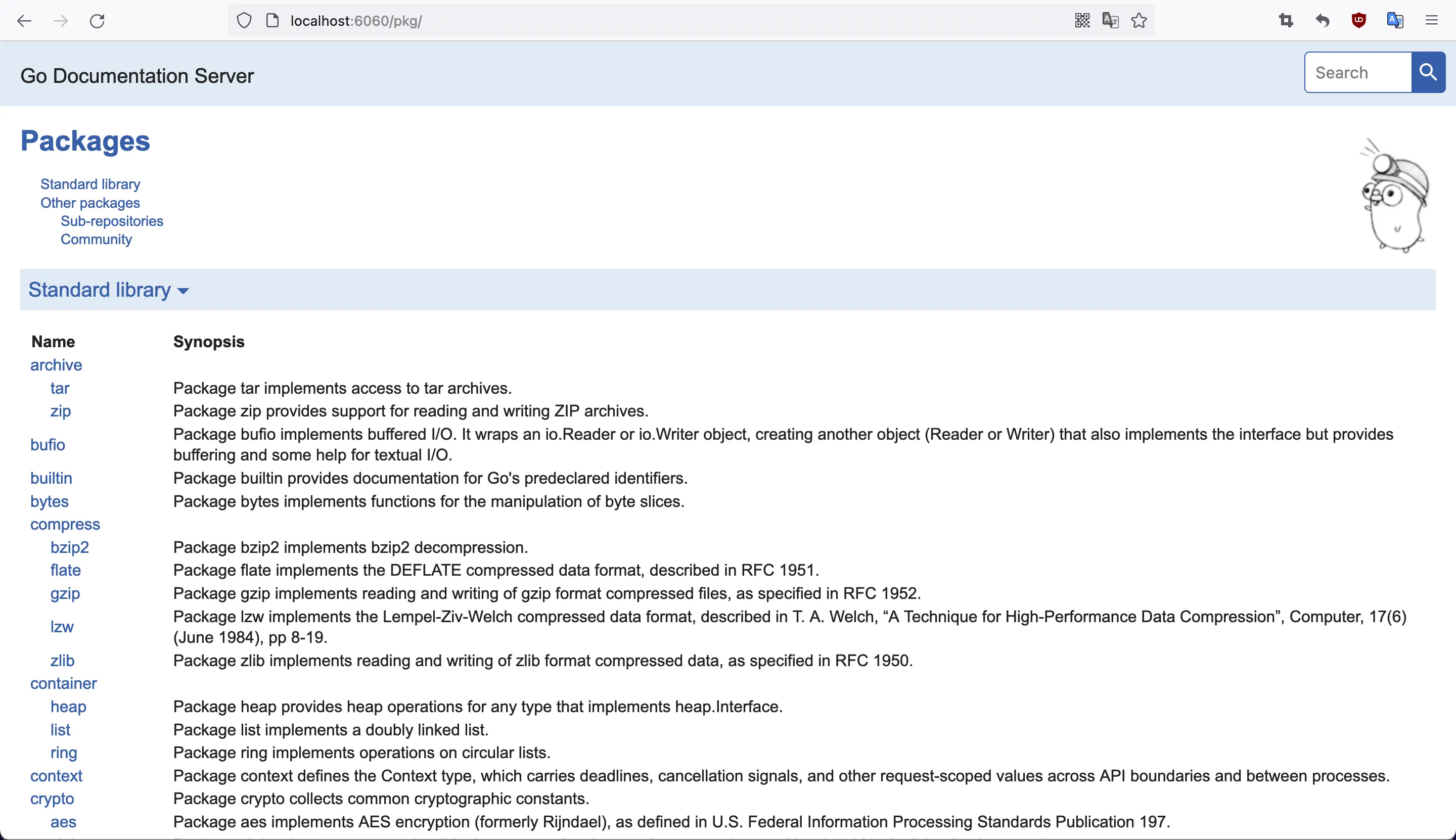

Go Search Extension浏览器扩展, 地址栏输入go+空格启用

-

golang.org国内经常访问不了

-

通过go bulid -tags 实现编译控制

-

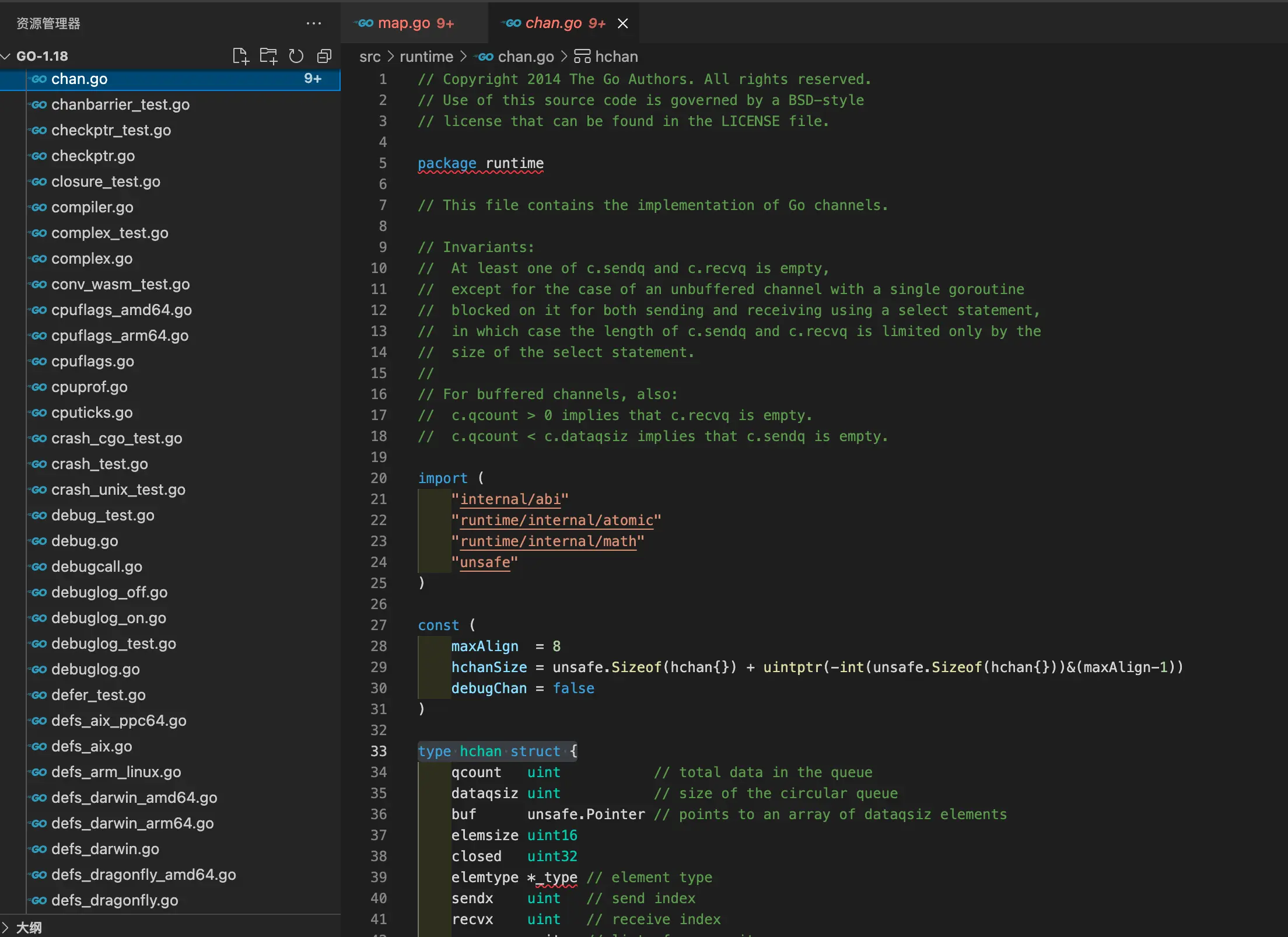

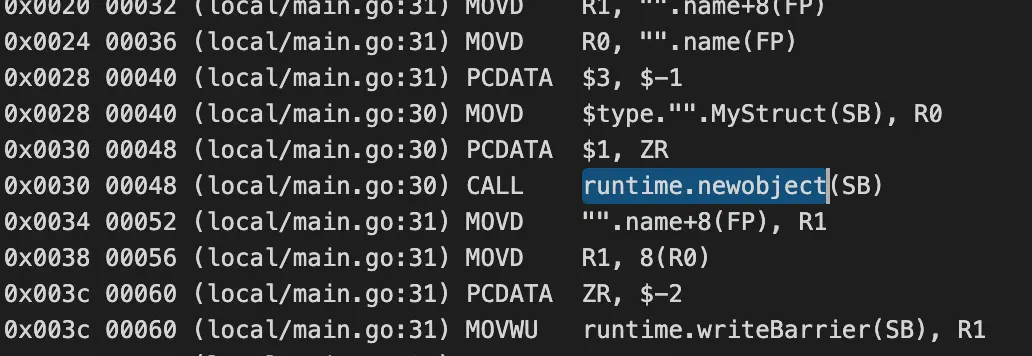

内置数据类型定义在runtime包,如下图所示

-

吐槽一下

- 破坏注释不影响代码的传统,这类//go:注释,有特别含义,会影响代码作用,使用者非常容易误解

- 强制mod方式管理第三方模块

- 用代码库+版本解决依赖

- 带来重大著名库大量重复存在,GOPATH成垃圾桶

- 带来更多名词,增加心智负担,精力分散在语言之外过多

- 严重偏向开源开发模式,对闭源开发不友好

-

Go 生态系统中有着许多中国 Gopher 们无法获取的模块,因此设置 CDN 加速代理就很有必要了,以下是几个速度不错的提供者:

-

go env -w GOPROXY=xxx,direct

-

七牛:Goproxy 中国 (https://goproxy.cn)

-

阿里: (mirrors.aliyun.com/goproxy/)

-

官方: 全球 CDN 加速 (https://goproxy.io/)

-

其他:jfrog 维护 (https://gocenter.io)

环境变量

# 安装到默认目录

rm -rf /usr/local/go && tar -C /usr/local -xzf go1.19.linux-amd64.tar.gz

# 导出环境变量

export PATH=$PATH:/usr/local/go/bin

# 查看安装成功否

go version

#列出环境变量

go env

#GOPATH环境变量,如果没有手动设置,默认为$HOME/go

GOPATH=$HOME/go

#模块缓存是 go 命令存储下载模块文件的目录,默认是$GOPATH/pkg/mod.

GOMODCACHE

#清除mod cache,pkg目录里面全没了

go clean --modcache

#Build Cache意思就是会把编译过程的中间结果cache下来,从而实现增量编译。

#Test cache,在内容没有变化的情况下,对于同样的参数的测试,会直接使用cache的测试结果

#cache默认的存储路径是操作系统所确定的用户缓存目录,但是可以通过GOCACHE环境变量修改

GOCACHE

#清除build cache

go clean -cache

#清除test cache

go clean -testcache

#GOPROXY(公共)修改为国内代理

#全球代理https://proxy.golang.com.cn(https://goproxy.io/)

#阿里云 https://mirrors.aliyun.com/goproxy/

#七牛云 https://goproxy.cn

#direct表示直接从包路径下载

go env -w GOPROXY=https://goproxy.cn,direct

#GOPRIVATE设置私有库

#还可以设置不走 proxy 的私有仓库或组,多个用逗号相隔(可选)

#允许通配符

go env -w GOPRIVATE=git.mycompany.com,github.com/my/private,*.example.com

#GOVCS变量

#可以使用git下载带有 github.com 路径的模块;无法使用任何版本控制命令下载 evil.com上的路径

#使用 git 或 hg 下载所有其他路径(* 匹配所有内容)的模块。

GOVCS=github.com:git,evil.com:off,*:git|hg

#GOSUMDB变量

#默认的GOSUMDB=sum.golang.org验证包的有效性,经常访问不了

go env -w GOSUMDB=off

#使用国内代理

go env -w GOSUMDB=https://goproxy.cn/sumdb/sum.golang.org,sum.golang.org

-

GOPROXY说明

- You can set the variable to URLs for other module proxy servers, separating URLs with either a comma or a pipe.

- When you use a comma, Go tools will try the next URL in the list only if the current URL returns an HTTP 404 or 410.

GOPROXY="https://proxy.example.com,https://proxy2.example.com"- When you use a pipe, Go tools will try the next URL in the list regardless of the HTTP error code.

GOPROXY="https://proxy.example.com|https://proxy2.example.com" -

GOPRIVATE说明

- The GOPRIVATE or GONOPROXY environment variables may be set to lists of glob patterns matching module prefixes that are private and should not be requested from any proxy.

-

GOVCS说明

- 版本控制工具中的错误可能被恶意服务器利用来运行恶意代码

- 如果未设置环境变量GOVCS,或者不匹配,GOVCS的默认处理:允许 git 和 hg 用于公共模块,并且允许所有工具用于私有模块。

go mod命令指南

#最后结果都是写入go.mod文件

go mod init path

go mod edit --replace modulepath=otherpath

go mod edit --exclude modulepath

#tidy整理依赖,增加没有添加或移除未引用等

go mod tidy

#整检依赖是否正解

go mod verify

- 采用mod方式管理依赖,则没有gopath/src,改到gopath/mod

- go.sum不需要手工维护,也不要手工改动

- 所有的子目录里的依赖都组织在根目录的go.mod文件

- replace指令场景

- 替换无法下载的包

- 替换本地自己的包

- 替换 fork 包

- exclude显式的排除某个包的某个版本,例如某个版本有严重bug,如果其他包引用这个版本,就会自动跳过这个版本

- 文章介绍较直白

- 文章介绍retract指令

工作区-多模块

#最后结果都是写入go.work文件

Usage:

go work <command> [arguments]

The commands are:

edit edit go.work from tools or scripts

init initialize workspace file